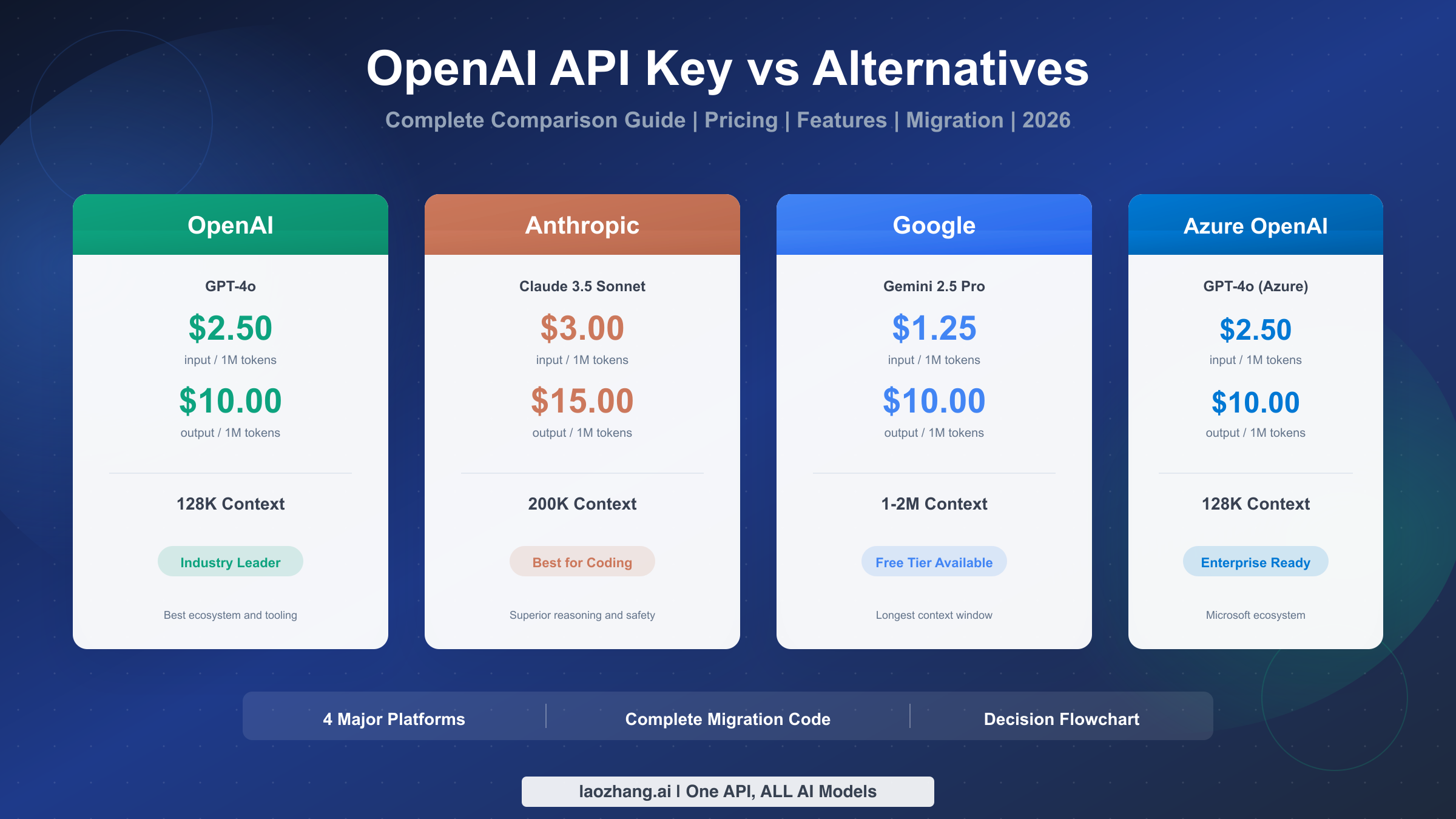

Сравниваете OpenAI API с альтернативами в 2026 году? Вот основные данные: GPT-4o стоит $2,50 за ввод/$10 за вывод на миллион токенов, Claude 3.5 Sonnet предлагает $3/$15 с контекстом 200K, а Gemini 2.5 Pro обеспечивает контекст до 2M токенов при $1,25-$2,50 за ввод. Это полное руководство охватывает реальные сравнения цен, подробные матрицы функций и пошаговые примеры кода для миграции, чтобы помочь вам сделать правильный выбор для вашего конкретного случая использования.

Краткое содержание

Вот что вам нужно знать об основных платформах AI API в 2026 году:

- OpenAI GPT-4o: отраслевой стандарт по $2,50/$10 за 1M токенов, контекст 128K, лучшая экосистема и поддержка SDK

- Anthropic Claude 3.5 Sonnet: премиум-класс по $3/$15, контекст 200K, превосходная производительность в программировании и 90% экономия на кэшировании промптов

- Google Gemini 2.5 Pro: конкурентоспособный по $1,25-$2,50 за ввод, контекст до 2M, бесплатный тариф с 60 RPM

- Azure OpenAI: те же цены, что и OpenAI, корпоративная безопасность с сертификацией SOC 2/HIPAA

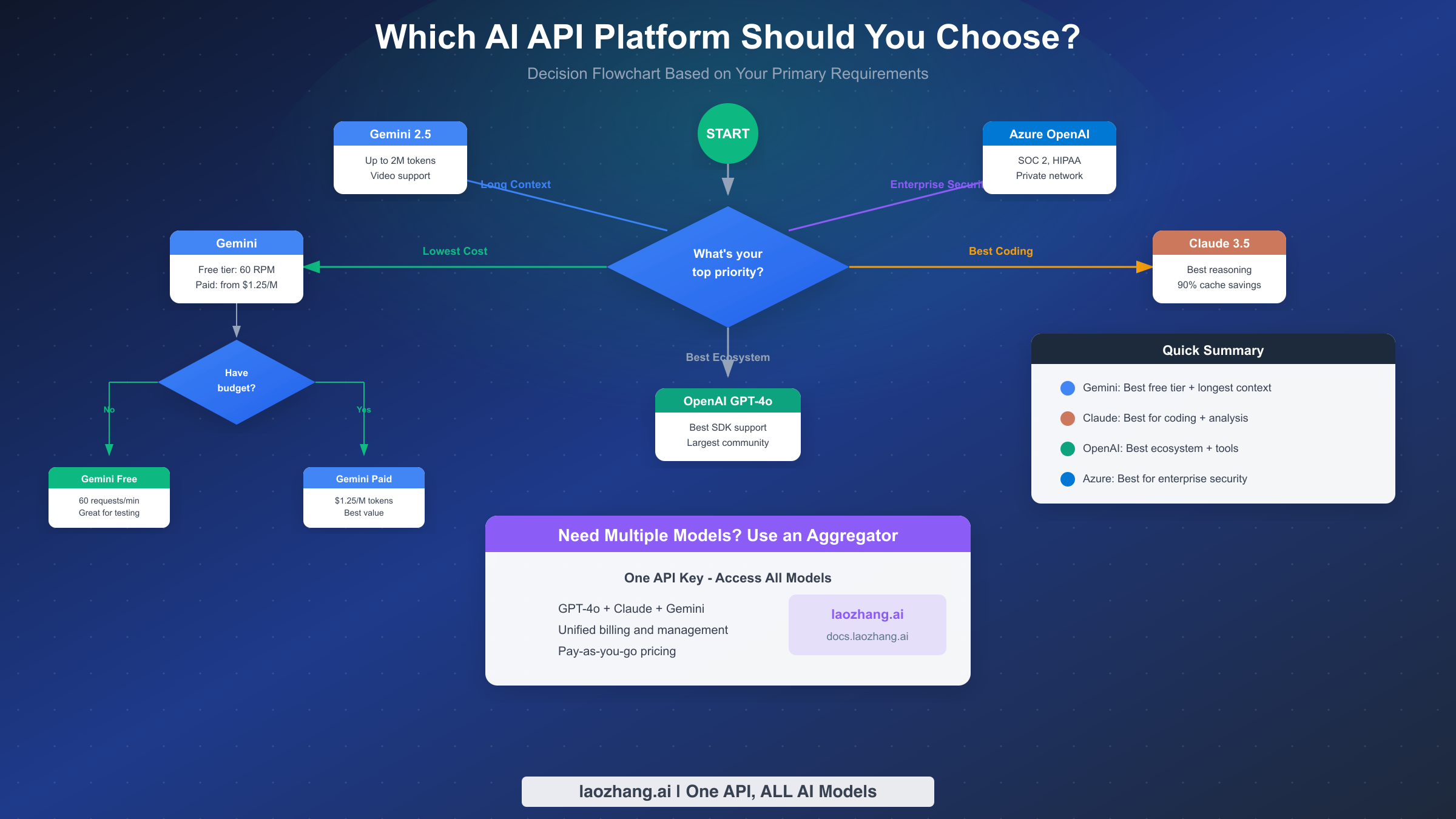

Правильный выбор зависит от ваших приоритетов: оптимизация затрат (Gemini), качество кода (Claude), зрелость экосистемы (OpenAI) или корпоративные требования (Azure).

Знакомство с участниками — обзор платформ AI API

Ландшафт AI API значительно развился, и четыре основные платформы конкурируют за внимание разработчиков. Каждая платформа занимает свою нишу, предлагая уникальные преимущества для различных случаев использования и организационных требований. Понимание этих различий критически важно перед погружением в конкретные сравнения цен и функций.

OpenAI остаётся пионером и лидером рынка, заложив основу для современных AI API с серией GPT. Их экосистема для разработчиков наиболее зрелая, с обширной документацией, ресурсами сообщества и интеграциями сторонних разработчиков. Большинство учебников по AI и примеров кода по умолчанию используют формат API OpenAI, что делает его путём наименьшего сопротивления для многих разработчиков. Компания продолжает инновации с такими функциями, как вызов функций, ставший отраслевым стандартом, который теперь копируют конкуренты.

Anthropic, основанная бывшими исследователями OpenAI, позиционирует Claude как выбор думающего разработчика. Их фокус на безопасности AI выражается в моделях, которые превосходно справляются с нюансированными рассуждениями и следованием сложным инструкциям. Claude заработал особенно сильную репутацию в сообществе разработчиков для задач программирования, где его способность понимать контекст и генерировать точный код соперничает с GPT-4 или превосходит его. Подход Anthropic к конституционному AI приводит к моделям, которые заметно лучше отказывают во вредоносных запросах, оставаясь полезными для легитимных случаев использования.

Google Gemini привносит мощь инфраструктуры и исследований Google на рынок API. Выдающейся особенностью платформы является её огромное контекстное окно, способное обрабатывать до 2 миллионов токенов в одном запросе. Эта возможность открывает варианты использования, которые ранее были невозможны, такие как анализ целых кодовых баз или обработка длинных документов без разбиения на части. Google также предлагает самый щедрый бесплатный тариф среди крупных поставщиков, что делает его привлекательным вариантом для экспериментов и небольших проектов.

Azure OpenAI предоставляет доступ к моделям OpenAI через корпоративную облачную инфраструктуру Microsoft. Хотя базовые модели идентичны прямым предложениям OpenAI, Azure добавляет корпоративные функции, такие как интеграция с виртуальной сетью, приватные конечные точки и комплексные сертификаты соответствия. Для организаций, уже инвестировавших в экосистему Microsoft, или тех, у кого строгие требования безопасности, Azure OpenAI предоставляет знакомую и надёжную платформу.

Если вы новичок в доступе к API и нуждаетесь в руководстве по основам, ознакомьтесь с нашим полным руководством по получению API-ключа OpenAI перед погружением в сравнения ниже.

Конкурентный ландшафт продолжает быстро развиваться. Только за последний год мы увидели драматическое снижение цен на всех платформах, расширение контекстных окон на порядки и мультимодальные возможности, ставшие стандартом. Платформа, которую вы выберете сегодня, может не быть вашим выбором завтра, что делает понимание путей миграции и вариантов агрегаторов особенно ценным. Построение уровней абстракции в ваши AI-интеграции с самого начала экономит значительную переработку позже, по мере того как рынок продолжает меняться.

Особенно интересно, как каждая платформа отреагировала на конкурентное давление. OpenAI сосредоточилась на глубине экосистемы и улучшении опыта разработчиков. Anthropic удвоила ставку на безопасность и возможности рассуждения, одновременно резко снизив затраты на кэширование промптов. Google расширила технические границы с огромными контекстными окнами и мультимодальными инновациями. Azure укрепила корпоративные интеграции и сертификаты соответствия. Эта дифференциация означает, что действительно нет единственной лучшей платформы — правильный выбор полностью зависит от ваших конкретных требований.

Сравнение цен — реальные цифры

Понимание ценообразования API необходимо для принятия обоснованных решений о том, какую платформу использовать. Затраты могут существенно различаться в зависимости от ваших паттернов использования, и то, что выглядит дёшево на бумаге, может стать дорогим на практике. Давайте разберём реальные цифры на основе проверенных данных о ценах за январь 2026 года.

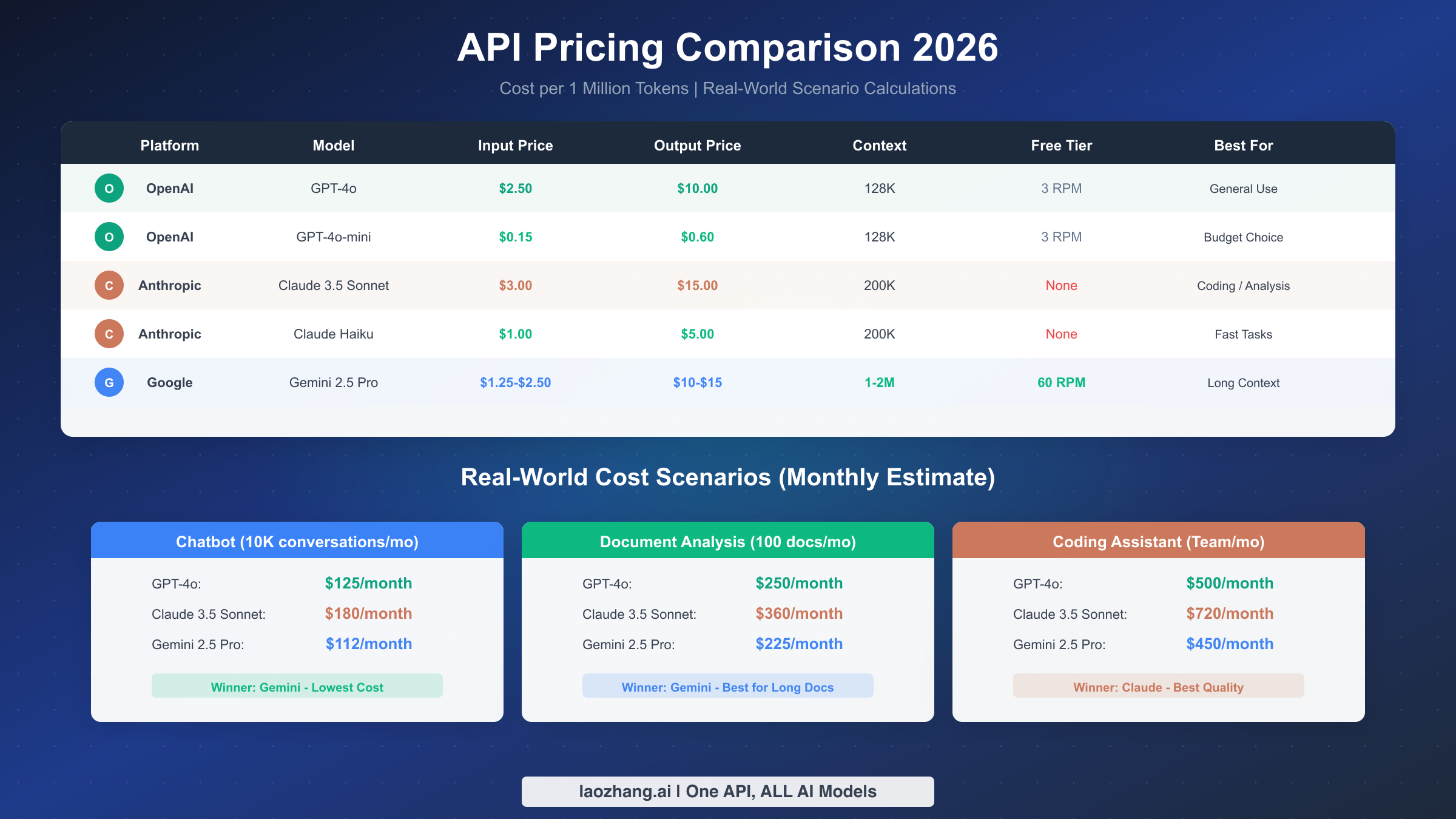

Структура ценообразования OpenAI следует простой модели ввода/вывода. GPT-4o, их флагманская модель, стоит $2,50 за миллион входных токенов и $10,00 за миллион выходных токенов. Более экономичный GPT-4o-mini предлагает существенную экономию по $0,15 за ввод и $0,60 за вывод на миллион токенов, что делает его подходящим для приложений с высоким объёмом, где первоклассная производительность не критична. OpenAI также предоставляет автоматическое кэширование промптов, которое может снизить затраты на ввод на 50% для повторяющихся промптов в течение 5-10 минут. Для более глубокого изучения тарифов OpenAI и оптимизации затрат см. наш детальный разбор цен OpenAI API.

Claude от Anthropic имеет премиальную цену, отражающую его преимущества в производительности. Claude 3.5 Sonnet стоит $3,00 за ввод и $15,00 за вывод на миллион токенов, а более быстрый Claude Haiku предлагает $1,00 за ввод и $5,00 за вывод. Что отличает Anthropic — это агрессивная скидка на кэширование промптов: кэшированные промпты стоят на 90% дешевле, лучшая ставка в отрасли. Это делает Claude особенно экономически эффективным для приложений с повторяющимися промптами, таких как помощники по программированию, которые многократно обрабатывают одни и те же системные инструкции. Наши детали цен Claude API подробно освещают стратегии оптимизации.

Google Gemini представляет наиболее конкурентоспособные цены в сочетании с единственным значимым бесплатным тарифом среди крупных поставщиков. Gemini 2.5 Pro стоит от $1,25 до $2,50 за входные токены (в зависимости от длины контекста) и $10-$15 за выходные. Бесплатный тариф обеспечивает 60 запросов в минуту без затрат, что реально полезно для разработки и небольшого производства. Gemini также предлагает кэширование промптов с настраиваемым TTL, хотя оно требует платного хранения. См. нашу структуру цен Gemini API для полной информации о тарифах.

Azure OpenAI полностью соответствует ценам OpenAI, но работает по другой модели биллинга, привязанной к подпискам Azure. Ценностное предложение не в экономии затрат, а в корпоративных функциях, таких как зарезервированная ёмкость, приватные сети и консолидированный биллинг с другими сервисами Azure.

Реальные сценарии затрат

Абстрактная цена за токен не рассказывает всю историю. Вот что эти цифры означают в практических сценариях, рассчитанных на основе типичных паттернов использования:

Чат-бот (10 000 разговоров в месяц): при среднем 500 входных токенов и 500 выходных токенов на разговор ваши ежемесячные затраты составят примерно $125 с GPT-4o, $180 с Claude 3.5 Sonnet и $112 с Gemini 2.5 Pro. Для бюджетных развёртываний GPT-4o-mini снижает это до примерно $8 в месяц, делая чат-боты на основе AI доступными даже для небольших проектов.

Анализ документов (100 длинных документов в месяц): обработка документов по 50 000 токенов с резюме по 2 000 токенов меняет расчёты. GPT-4o обойдётся примерно в $250 в месяц, Claude около $360, а Gemini примерно в $225. Однако способность Gemini обрабатывать целые документы без разбиения (благодаря контекстному окну 2M) может снизить сложность и улучшить точность.

Помощник по программированию (использование командой разработки): команда, генерирующая 50 000 токенов кода в день с 100 000 токенов контекста на вводе, потратит примерно $500/месяц на GPT-4o, $720 на Claude 3.5 Sonnet или $450 на Gemini. Несмотря на более высокую стоимость, многие команды выбирают Claude для программирования из-за превосходного качества кода, находя инвестиции оправданными.

Скрытые затраты и ловушки ценообразования

Помимо заголовочных тарифов, несколько факторов могут существенно повлиять на ваши реальные затраты. Понимание этих нюансов предотвращает бюджетные сюрпризы и помогает оптимизировать расходы с первого дня.

Различия в подсчёте токенов важнее, чем понимает большинство разработчиков. Хотя все платформы используют похожие схемы токенизации, точные сопоставления различаются. Промпт, который токенизируется в 1000 токенов на OpenAI, может стать 1100 или 900 токенами на Claude или Gemini. Для приложений с высоким объёмом эти различия накапливаются. Самый безопасный подход — протестировать репрезентативные образцы на разных платформах перед принятием обязательств, используя API токенизации каждого поставщика для получения точных оценок.

Уровни ограничения скорости могут вынудить вас к более высоким категориям расходов, чем подразумевают чистые затраты на токены. Если вашему приложению нужна более высокая пропускная способность, чем обеспечивает бесплатный тариф, вы можете платить значительно больше только за разблокировку лимитов скорости, а не за фактическое использование токенов. Система уровней OpenAI, например, требует существенной истории расходов для доступа к более высоким лимитам скорости, что может стать узким местом для растущих приложений.

Затраты на повторные попытки и обработку ошибок часто удивляют команды. Когда запросы терпят неудачу из-за ограничений скорости или временных сбоев, повторные попытки потребляют дополнительные токены. Платформы различаются в том, как они обрабатывают частичные сбои — некоторые учитывают токены даже для неудачных запросов, другие возвращают их. Построение надёжной логики повторных попыток с экспоненциальной задержкой значительно снижает эти скрытые затраты.

Региональное ценообразование и накладные расходы на соответствие добавляют затраты для глобальных приложений. Если вам нужно маршрутизировать запросы через определённые регионы для требований резидентности данных, вы можете столкнуться с более высокой задержкой, что увеличивает использование токенов для интерактивных приложений. Варианты регионального развёртывания Azure OpenAI обеспечивают контроль, но требуют тщательного планирования архитектуры.

Глубокий анализ функций — возможности, которые имеют значение

Помимо ценообразования, функциональные возможности каждой платформы могут определить успех или провал вашего приложения. Эти различия становятся особенно важными по мере масштабирования или решения специализированных задач. Давайте рассмотрим функции, наиболее важные для разработчиков и предприятий.

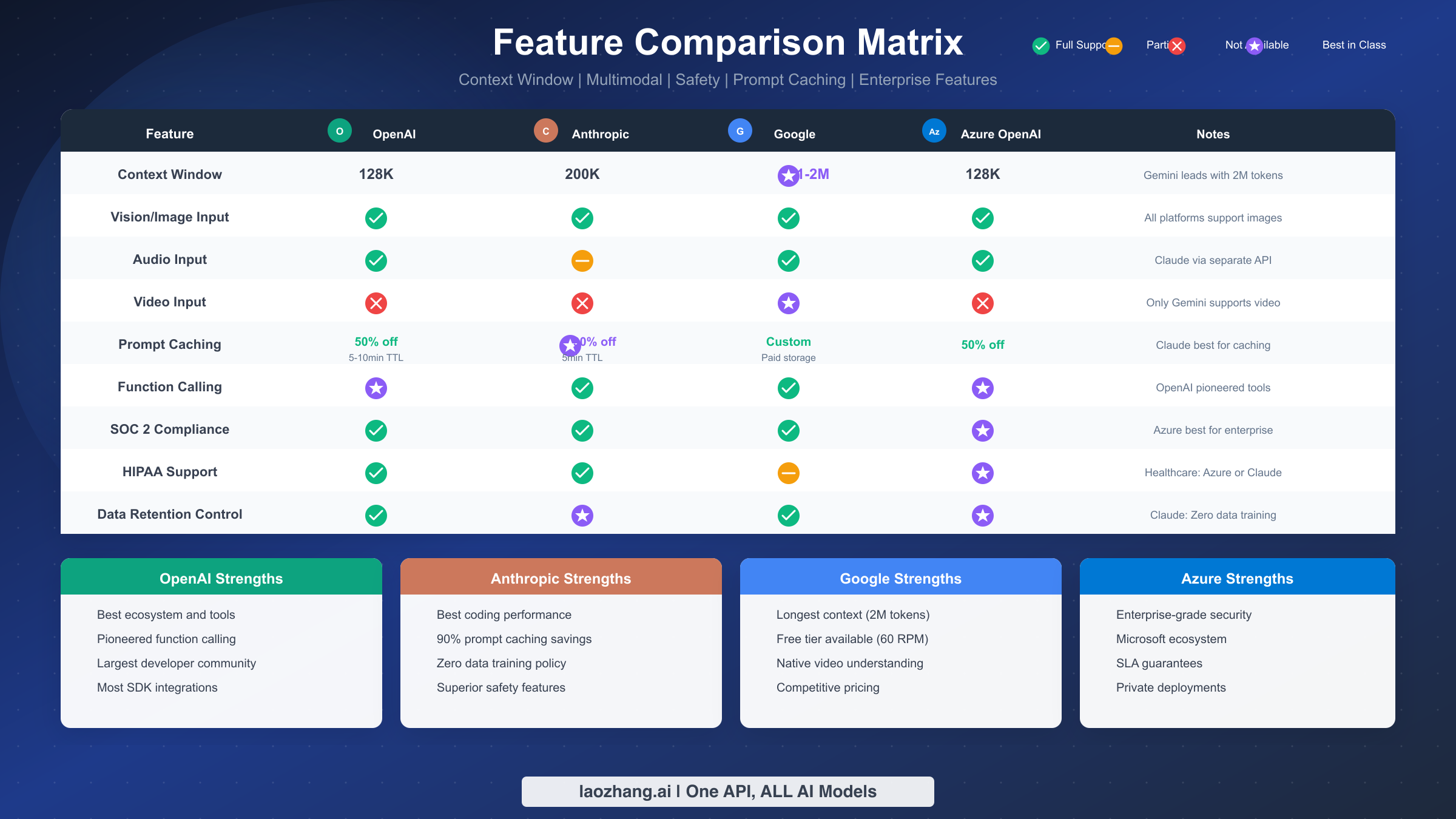

Размер контекстного окна представляет один из наиболее значительных отличительных факторов. GPT-4o от OpenAI и Azure OpenAI поддерживают 128K токенов, что комфортно охватывает большинство случаев использования. Claude расширяет это до 200K токенов, обеспечивая дополнительный запас для приложений, работающих с документами. Gemini 2.5 Pro доминирует в этой категории с поддержкой 1-2 миллионов токенов, открывая совершенно новые категории приложений, такие как анализ кодовых баз или обработка целых книг в одном промпте. Это не просто маркетинговая цифра — разработчики сообщают об успешной обработке репозиториев из 100+ файлов в одном API-вызове.

Мультимодальные возможности стали базовым требованием, но качество реализации различается. Все четыре платформы теперь поддерживают ввод изображений, позволяя отправлять скриншоты, диаграммы или фотографии для анализа. Аудиовход доступен на OpenAI, Google и Azure, при этом Anthropic требует отдельный API для обработки речи. Понимание видео остаётся эксклюзивным преимуществом Gemini — вы можете загружать видеофайлы напрямую в API для анализа, возможность, которую ни один конкурент в настоящее время не предоставляет.

Глубокое сравнение кэширования промптов

Кэширование промптов стало критически важной функцией оптимизации затрат, но реализации существенно различаются между платформами. Понимание этих различий может сэкономить вам значительные средства на производственных нагрузках.

Автоматическое кэширование OpenAI активируется, когда вы повторно используете тот же префикс промпта в течение 5-10 минутного окна. Кэшированные входные токены стоят на 50% дешевле без необходимости настройки. Это хорошо работает для типичных чат-приложений, но обеспечивает ограниченный контроль. Продолжительность кэша сбрасывается при каждом попадании, поэтому активные разговоры поддерживают свой кэш неопределённо долго.

Явное кэширование Anthropic предлагает самые агрессивные скидки — кэшированные чтения стоят только 10% от стандартных ставок на ввод (90% экономии). Однако первоначальная запись в кэш влечёт премию 25%, поэтому функция окупается только при многократных попаданиях в кэш. TTL в 5 минут короче, чем у OpenAI, что требует тщательного проектирования промптов для максимизации попаданий. Для приложений вроде помощников по программированию, которые многократно обрабатывают одни и те же инструкции, кэширование Claude обеспечивает существенную экономию.

Кэширование контекста Google использует другой подход, взимая плату за кэшированное хранение на основе времени и количества токенов. Вы получаете полный контроль над TTL кэша, от минут до часов, но должны активно управлять жизненными циклами кэша. Эта модель хорошо работает для сценариев пакетной обработки, где вы обрабатываете много запросов к одному и тому же контексту.

Корпоративная безопасность и соответствие

Для организаций с регуляторными требованиями функции безопасности часто определяют выбор платформы независимо от ценообразования или производительности. Платформы значительно различаются в своих позициях соответствия и архитектурах безопасности.

Сертификация SOC 2 Type II теперь стандартна для всех четырёх платформ, обеспечивая базовую гарантию практик обработки данных. Однако глубина соответствия различается. Azure OpenAI лидирует с наиболее полным портфелем сертификаций, включая авторизацию FedRAMP High для государственных задач, HIPAA BAA для здравоохранения и отраслевые аттестации для финансовых услуг.

Политики обработки данных раскрывают важные философские различия. Anthropic обязуется к нулевому хранению данных для API-клиентов — ваши промпты и ответы никогда не обучают их модели и удаляются после обработки. OpenAI предлагает аналогичные опции отказа, но по умолчанию использует данные API для обучения, если явно не отключено. Практики Google по данным находятся между этими крайностями, с чёткими политиками хранения, но более сложными процедурами отказа.

Опции сетевой безопасности важны для чувствительных развёртываний. Azure OpenAI поддерживает интеграцию с виртуальной сетью и приватные конечные точки, сохраняя трафик полностью в вашей инфраструктуре Azure. OpenAI и Anthropic предлагают белые списки IP и ротацию API-ключей, но трафик проходит через публичный интернет. VPC Service Controls Google Cloud обеспечивают сетевую изоляцию для Gemini, хотя конфигурация сложнее, чем подход Azure.

Сравнение производительности и надёжности

Помимо функций, перечисленных на маркетинговых страницах, реальные характеристики производительности существенно влияют на производственные приложения. Задержка, пропускная способность и паттерны времени безотказной работы заметно различаются между поставщиками и заслуживают тщательного рассмотрения.

Задержка ответа варьируется в зависимости от модели, сложности запроса и времени суток. В типичных условиях OpenAI и Claude доставляют ответы первого токена за 200-400мс для большинства запросов, с полными ответами, завершающимися за 1-3 секунды для выходов средней длины. Gemini обычно работает немного медленнее, особенно для моделей с большим контекстом, с задержкой первого токена часто достигающей 500-800мс. Azure OpenAI соответствует производительности OpenAI в большинстве сценариев, но может демонстрировать дополнительную задержку в зависимости от вашего региона развёртывания и конфигурации сети.

Производительность стриминга имеет большое значение для интерактивных приложений. Все четыре платформы поддерживают потоковые ответы, но согласованность различается. OpenAI обеспечивает самый плавный опыт стриминга с равномерной доставкой токенов, в то время как Claude иногда демонстрирует паттерны всплесков, когда токены приходят кластерами. Для чат-интерфейсов, где пользователи наблюдают за появлением текста в реальном времени, эти различия влияют на воспринимаемое качество, даже когда общее время ответа одинаково.

Время безотказной работы и надёжность улучшились повсеместно, но исторические паттерны различаются. OpenAI испытала несколько громких сбоев в периоды пиковой нагрузки, особенно вокруг крупных запусков. Claude исторически показывал лучшую стабильность, но с периодическими проблемами конечных точек API. Бесплатный тариф Gemini более подвержен ограничению скорости и деградации производительности в периоды высокого спроса. Azure OpenAI выигрывает от корпоративных обязательств SLA Azure, обеспечивая наиболее формальные гарантии надёжности.

Планирование ёмкости требует понимания характеристик масштабирования каждого поставщика. OpenAI использует систему уровней, где история расходов открывает более высокие лимиты скорости. Anthropic предлагает более высокие лимиты по умолчанию, но требует корпоративных соглашений для самых высоких уровней. Google предоставляет самые щедрые бесплатные лимиты, но ёмкость платного уровня требует планирования ёмкости GCP. Для приложений, ожидающих значительного роста, понимание этих путей масштабирования предотвращает узкие места.

Агрегаторный подход — один ключ для всех моделей

Если сравнение отдельных платформ кажется подавляющим, есть альтернативный подход, набирающий популярность: агрегаторы API, которые предоставляют унифицированный доступ к нескольким моделям через единую интеграцию. Этот подход решает несколько практических проблем, которые становятся очевидными по мере того, как организации развивают свои AI-стратегии.

Проблема множества моделей возникает естественным образом, когда команды экспериментируют с разными платформами. Вы можете обнаружить, что Claude превосходит в ревью кода, GPT-4o лучше справляется с разговорами службы поддержки, а длинный контекст Gemini идеален для суммаризации документов. Управление отдельными API-ключами, биллинговыми отношениями и интеграционным кодом для каждой платформы создаёт операционные накладные расходы, которые плохо масштабируются.

Платформы-агрегаторы API, такие как laozhang.ai, предоставляют унифицированный интерфейс к нескольким моделям. Вы интегрируетесь один раз, используя формат API, совместимый с OpenAI, затем направляете запросы к любой поддерживаемой модели, просто меняя параметр модели. Биллинг консолидируется в один счёт, и вы получаете гибкость переключения моделей без изменений кода.

Практические преимущества выходят за рамки удобства. Агрегаторы часто предоставляют:

- Унифицированное ограничение скорости и очереди: автоматическая обработка логики повторных попыток и лимитов скорости между поставщиками

- Инструменты оптимизации затрат: видимость расходов по моделям на панели управления с предложениями по снижению затрат

- Возможности отказоустойчивости: автоматическая маршрутизация к резервным моделям, если ваш основной выбор испытывает простой

- Упрощённое соответствие: единое отношение с поставщиком упрощает закупки и проверки безопасности

Для команд, которым нужно несколько моделей или которые хотят гибкости для экспериментов, агрегаторный подход снижает сложность, сохраняя доступ к лучшим возможностям каждого поставщика. Незначительная премия в стоимости часто компенсируется сокращённым временем интеграции и операционными накладными расходами.

Реализация мультимодельной архитектуры

Переход от интеграции с одним поставщиком требует продуманных архитектурных решений. Наиболее успешные реализации разделяют несколько общих паттернов, которые балансируют гибкость и поддерживаемость.

Архитектуры на основе маршрутизатора принимают интеллектуальные решения о том, какая модель обрабатывает каждый запрос. Центральный компонент маршрутизатора анализирует входящие запросы — рассматривая тип задачи, уровень пользователя, длину контента или явные подсказки маршрутизации — и направляет их к соответствующему поставщику. Этот паттерн позволяет A/B-тестирование, постепенные миграции и оптимизацию затрат без изменений на клиенте. Маршрутизатор может быть таким же простым, как оператор switch, или таким сложным, как классификатор на основе ML.

Цепочки отказоустойчивости обеспечивают устойчивость к сбоям поставщиков. Когда ваша основная модель терпит неудачу или возвращает ошибки, система автоматически пробует альтернативных поставщиков. Этот паттерн требует тщательного обдумывания совместимости ответов — если формат вывода Claude отличается от GPT-4o, ваше приложение должно обрабатывать оба. Использование форматов API, совместимых с OpenAI, через агрегатор вроде laozhang.ai значительно упрощает это.

Маршрутизация с учётом затрат оптимизирует расходы в реальном времени. Отслеживая затраты на запрос и накопленные расходы, маршрутизаторы могут переключать трафик между эквивалентными моделями на основе бюджетных ограничений. Этот подход особенно выгоден для приложений с переменными нагрузками, направляя избыточный трафик к более дешёвым альтернативам в пиковые периоды, сохраняя качество для приоритетных запросов.

Маршрутизация на основе качества использует сильные стороны каждой модели. Задачи программирования направляются к Claude для его превосходной генерации кода. Анализ длинных документов идёт к Gemini для его расширенного контекста. Разговоры с клиентами используют GPT-4o для его разговорной плавности. Эта специализация улучшает общее качество, потенциально снижая затраты за счёт избежания избыточности для простых задач.

Сложность реализации мультимодельных архитектур окупается по мере развития вашего использования AI. Начав с простого уровня абстракции — даже если изначально направляя всё к одному поставщику — значительно упрощает будущую оптимизацию по сравнению с переработкой тесно связанной интеграции.

Руководство по миграции — переключение стало простым

Переключение поставщиков AI не обязательно означает переписывание вашего приложения с нуля. Основные платформы сошлись на похожих паттернах API, что делает миграцию простой при правильном планировании. Вот практический код для наиболее распространённых путей миграции.

Миграция с OpenAI на Anthropic Claude

Основные концепции переводятся напрямую: сообщения становятся разговорами, системные промпты сопоставляются с системными параметрами, и обработка ответов следует похожим паттернам. Вот полный пример миграции на Python:

pythonfrom openai import OpenAI openai_client = OpenAI(api_key="your-openai-key") def chat_openai(user_message: str, system_prompt: str = "You are a helpful assistant."): response = openai_client.chat.completions.create( model="gpt-4o", messages=[ {"role": "system", "content": system_prompt}, {"role": "user", "content": user_message} ], max_tokens=1000 ) return response.choices[0].message.content # Миграция на Anthropic Claude from anthropic import Anthropic claude_client = Anthropic(api_key="your-anthropic-key") def chat_claude(user_message: str, system_prompt: str = "You are a helpful assistant."): response = claude_client.messages.create( model="claude-3-5-sonnet-20241022", system=system_prompt, # Системный промпт — отдельный параметр messages=[ {"role": "user", "content": user_message} ], max_tokens=1000 ) return response.content[0].text # Структура ответа немного отличается

Ключевые различия для заметок: Claude принимает системный промпт как отдельный параметр, а не как сообщение, и содержимое ответа доступно через response.content[0].text вместо response.choices[0].message.content. Паттерны обработки ошибок похожи, обе библиотеки генерируют специфические типы исключений для ограничений скорости, ошибок аутентификации и ошибок API.

Миграция с OpenAI на Google Gemini

Структура API Gemini отличается более значительно, но концепции остаются согласованными:

python# Оригинальная реализация OpenAI from openai import OpenAI openai_client = OpenAI(api_key="your-openai-key") def chat_openai(user_message: str): response = openai_client.chat.completions.create( model="gpt-4o", messages=[{"role": "user", "content": user_message}], max_tokens=1000 ) return response.choices[0].message.content # Миграция на Google Gemini import google.generativeai as genai genai.configure(api_key="your-gemini-key") model = genai.GenerativeModel("gemini-2.5-pro") def chat_gemini(user_message: str): response = model.generate_content( user_message, generation_config=genai.GenerationConfig( max_output_tokens=1000 ) ) return response.text

Для JavaScript-приложений вот эквивалентная миграция:

javascript// Оригинал OpenAI import OpenAI from 'openai'; const openai = new OpenAI({ apiKey: 'your-openai-key' }); async function chatOpenAI(message) { const response = await openai.chat.completions.create({ model: 'gpt-4o', messages: [{ role: 'user', content: message }], max_tokens: 1000 }); return response.choices[0].message.content; } // Миграция на Anthropic Claude import Anthropic from '@anthropic-ai/sdk'; const anthropic = new Anthropic({ apiKey: 'your-anthropic-key' }); async function chatClaude(message) { const response = await anthropic.messages.create({ model: 'claude-3-5-sonnet-20241022', max_tokens: 1000, messages: [{ role: 'user', content: message }] }); return response.content[0].text; }

Лучшие практики миграции

Помимо изменений кода, успешные миграции требуют внимания к нескольким практическим вопросам:

Оптимизация промптов часто даёт лучшие результаты, чем прямой перевод. У каждой модели разные сильные стороны — Claude хорошо реагирует на детальный контекст и явные запросы на рассуждение, в то время как Gemini превосходит со структурированными форматами вывода. Инвестируйте время в инженерию промптов после миграции для максимизации качества.

Постепенный выкат снижает риск. Начните с направления небольшого процента производственного трафика к новому поставщику, отслеживая проблемы качества и производительности. Большинство команд обнаруживают, что 1-2 недели параллельной работы выявляют крайние случаи, которые пропускает тестирование.

Мониторинг затрат во время миграции предотвращает сюрпризы. Настройте оповещения о расходах перед переключением, поскольку паттерны использования, которые были экономичными на одной платформе, могут оказаться дорогими на другой. Методы подсчёта токенов тонко различаются между поставщиками, иногда приводя к более высоким, чем ожидалось, расходам.

Распространённые проблемы миграции и решения

Реальные миграции редко идут точно по плану. Предвидение распространённых проблем ускоряет ваш график миграции и снижает производственные инциденты.

Несоответствия формата ответов застают многие команды врасплох. Даже для простых текстовых завершений модели различаются в форматировании, обработке пробелов и предпочтениях пунктуации. Claude склоняется к более формальному языку и более длинным предложениям. GPT-4o более разговорный. Gemini значительно варьируется в зависимости от структуры промпта. Если ваше приложение программно анализирует выходные данные модели, ожидайте корректировки логики парсинга.

Различия в чувствительности к промптам требуют повторной оптимизации. Промпт, который отлично работает на OpenAI, может недорабатывать на Claude или наоборот. Системные промпты особенно выигрывают от настройки под конкретную модель. Claude хорошо реагирует на чёткие определения ролей и явные ограничения, в то время как GPT-4o эффективно обрабатывает более неявные инструкции. Закладывайте время на инженерию промптов как часть любой миграции.

Совместимость вызова функций улучшилась, но не идеальна. OpenAI создала парадигму вызова функций/инструментов, и хотя Claude и Gemini приняли похожие паттерны, крайние случаи существуют. Сложные схемы, опциональные параметры и вложенные объекты иногда ведут себя по-разному. Тщательно тестируйте определения ваших инструментов на целевой платформе перед производственной миграцией.

Обработка стриминга и таймаутов требует корректировки. Характеристики времени различаются между поставщиками — размеры чанков, поведение соединения и значения таймаутов по умолчанию все варьируются. Приложения, которые нормально работали со стримингом OpenAI, могут потребовать скорректированных размеров буферов или значений таймаутов для Claude или Gemini. Мониторьте ошибки таймаутов во время тестирования миграции.

Логика ограничения скорости и повторных попыток нуждается в настройке под конкретную платформу. Коды ошибок, заголовки retry-after и рекомендации по задержке различаются между поставщиками. Реализация повторных попыток, оптимизированная для ограничения скорости OpenAI, может работать неоптимально на других платформах. Просмотрите документацию каждого поставщика для их конкретных рекомендаций по повторным попыткам.

Какую платформу выбрать?

После изучения ценообразования, функций и путей миграции выбор в конечном счёте зависит от ваших конкретных приоритетов. Вот структура принятия решений на основе распространённых случаев использования и требований.

Выбирайте OpenAI GPT-4o, если цените зрелость экосистемы и опыт разработчика. Документация OpenAI, ресурсы сообщества и интеграции сторонних разработчиков не имеют себе равных. Большинство учебников по AI предполагают API OpenAI, снижая кривую обучения. Реализация вызова функций наиболее надёжная, и вы найдёте самый широкий выбор SDK и инструментов. Это безопасный, проторённый путь — не всегда самый дешёвый или мощный, но надёжный и хорошо поддерживаемый.

Выбирайте Anthropic Claude, если ваше приложение ориентировано на код или требует тщательного рассуждения. Claude последовательно превосходит конкурентов в бенчмарках программирования и сложных многоэтапных задачах. Скидка 90% на кэширование промптов делает его удивительно экономичным для приложений с повторяющимися промптами. Обучение Claude с фокусом на безопасность также производит выходные данные, которые требуют меньше фильтрации, снижая затраты на модерацию. Для инструментов разработки, интеграций IDE и приложений генерации кода Claude всё чаще становится выбором по умолчанию среди опытных команд.

Выбирайте Google Gemini, если оптимизация затрат или обработка длинного контекста — ваш приоритет. Бесплатный тариф обеспечивает реальную полезность для разработки и небольшого производства. Контекстное окно 2M токенов открывает варианты использования, невозможные на других платформах — анализ целых кодовых баз, обработка объёмных юридических документов или поддержание истории разговоров на тысячи сообщений. Если вы обрабатываете длинные документы или создаёте приложения, которые выигрывают от обширного контекста, технические преимущества Gemini оправдывают его чуть менее зрелую экосистему.

Выбирайте Azure OpenAI, если требования корпоративной безопасности определяют ваши решения. Интеграция с Microsoft предоставляет знакомые элементы управления безопасностью, сертификаты соответствия и процессы закупок для крупных организаций. Интеграция с виртуальной сетью сохраняет конфиденциальные данные в вашей инфраструктуре. Для приложений в здравоохранении, финансовых услугах или государственном секторе портфель соответствия Azure часто делает его единственным жизнеспособным вариантом независимо от других соображений.

Мультимодельная стратегия

Всё чаще продвинутые команды принимают мультимодельный подход вместо выбора одного поставщика. Эта стратегия назначает разные модели для разных задач на основе их сильных сторон:

- Маршрутизация простых запросов к GPT-4o-mini или Claude Haiku для экономии затрат

- Отправка задач программирования к Claude 3.5 Sonnet для качества

- Обработка длинных документов с расширенным контекстом Gemini 2.5 Pro

- Обработка конфиденциальных корпоративных данных через защищённую инфраструктуру Azure OpenAI

Этот подход требует больше интеграционной работы изначально, но оптимизирует как затраты, так и качество для различных случаев использования. Платформы-агрегаторы API, такие как laozhang.ai, упрощают эту архитектуру, предоставляя унифицированный доступ через единую интеграцию.

Для тех, кто заинтересован в изучении бесплатных вариантов при оценке платформ, наше руководство по бесплатному доступу к Gemini API охватывает самый щедрый бесплатный тариф, доступный сегодня.

Защита вашей AI-интеграции от будущего

Ландшафт AI развивается быстро, и сегодняшний оптимальный выбор может не остаться оптимальным в следующем году. Встраивание гибкости в вашу интеграцию с самого начала экономит значительные затраты на переработку.

Уровни абстракции обеспечивают наиболее простую защиту. Вместо прямого вызова API поставщиков по всей вашей кодовой базе централизуйте AI-взаимодействия за внутренним интерфейсом. Этот уровень может начинаться просто — просто обёртывая API-вызовы — и расти, включая маршрутизацию, кэширование и мониторинг. Когда вам нужно переключить поставщиков или добавить новые модели, изменения происходят в одном месте, а не рассеяны по вашему приложению.

Системы флагов функций позволяют постепенные переходы между поставщиками. Обёртывая выбор модели во флаги функций, вы можете переключать трафик между поставщиками без развёртываний. Эта возможность ценна для тестирования новых моделей, реагирования на сбои и оптимизации затрат в реальном времени.

Мониторинг и наблюдаемость предоставляют данные, необходимые для обоснованных решений. Отслеживайте не только затраты, но также задержку, частоту ошибок и метрики качества по поставщикам. Когда выходит новая модель или меняются цены, эти данные говорят вам, имеет ли смысл переключение для вашей конкретной нагрузки.

Регулярные циклы оценки поддерживают ваш стек актуальным. Установите напоминания в календаре для переоценки ваших выборов платформы ежеквартально. Рынок AI API меняется быстро — поставщик, который был дорогим в прошлом квартале, мог снизить цены, или новая модель могла драматически превзойти ваш текущий выбор. Команды, которые регулярно оценивают, захватывают эти возможности.

Часто задаваемые вопросы

Azure OpenAI дешевле, чем прямой OpenAI?

Нет, цена за токен идентична. Ценность Azure OpenAI заключается в корпоративных функциях, таких как интеграция с виртуальной сетью, приватные конечные точки и консолидированный биллинг с другими сервисами Azure. Вы можете увидеть преимущества по затратам через скидки на обязательства Azure или ценообразование зарезервированной ёмкости, но базовые затраты API соответствуют прямому ценообразованию OpenAI.

Какая лучшая альтернатива OpenAI API для программирования?

Claude 3.5 Sonnet от Anthropic последовательно занимает первое место для приложений программирования. Независимые бенчмарки показывают, что Claude превосходит GPT-4 в генерации кода, отладке и ревью кода. Скидка 90% на кэширование промптов также делает Claude экономически эффективным для помощников по программированию, которые многократно обрабатывают одни и те же инструкции и контекст.

Как Claude сравнивается с GPT-4?

Claude 3.5 Sonnet и GPT-4o в целом сопоставимы по возможностям, каждый превосходит в разных областях. Claude склонен производить лучший код и более надёжно следовать сложным инструкциям, в то время как GPT-4o имеет превосходный вызов функций и более зрелую экосистему. Для разговорного AI и приложений общего назначения разница часто незначительна; для специализированных задач рекомендуется тестировать оба.

Gemini API действительно бесплатный?

Да, Google предлагает настоящий бесплатный тариф с 60 запросами в минуту без затрат. Это охватывает способные модели Gemini и включает возможности работы с изображениями. Бесплатный тариф достаточен для разработки, тестирования и небольших производственных приложений. Платные тарифы предлагают более высокие лимиты скорости и дополнительные функции, но не требуются для начала работы.

Можно ли использовать несколько AI API вместе?

Абсолютно. Многие производственные приложения направляют разные запросы к разным поставщикам в зависимости от требований задачи. Платформы-агрегаторы API, такие как laozhang.ai, упрощают это, предоставляя унифицированный доступ к нескольким моделям через единую API-интеграцию. Вы можете переключаться между GPT-4o, Claude и Gemini, меняя один параметр модели без управления отдельными интеграциями.

Какая платформа имеет самое длинное контекстное окно?

Google Gemini 2.5 Pro лидирует с поддержкой 1-2 миллионов токенов в одном запросе, значительно превосходя конкурентов. Claude предлагает 200K токенов, в то время как OpenAI и Azure OpenAI поддерживают 128K токенов. Контекстное окно наиболее важно для приложений, обрабатывающих длинные документы, поддерживающих обширную историю разговоров или анализирующих большие кодовые базы.

Как оптимизировать затраты при использовании AI API?

Несколько стратегий значительно снижают затраты на API у всех поставщиков. Во-первых, эффективно реализуйте кэширование промптов — Claude предлагает 90% экономии на кэшированных чтениях, а OpenAI предоставляет 50% скидки для повторяющихся промптов. Во-вторых, используйте соответствующие уровни моделей: направляйте простые запросы к более дешёвым моделям, таким как GPT-4o-mini или Claude Haiku, вместо постоянного использования флагманских моделей. В-третьих, оптимизируйте промпты, чтобы быть краткими, но эффективными — ненужные многословные инструкции тратят токены. В-четвёртых, рассмотрите пакетную обработку, где позволяет задержка, поскольку некоторые поставщики предлагают лучшие тарифы для асинхронных нагрузок. Наконец, агрегаторы API, такие как laozhang.ai, могут помочь оптимизировать маршрутизацию и обеспечить консолидированную видимость биллинга.

Какова кривая обучения при переключении платформ?

Для разработчиков, знакомых с одной платформой, переключение на другую обычно занимает 1-2 дня сосредоточенной работы для базовой интеграции и 1-2 недели для оптимизации под производственное качество. Основные концепции переводятся напрямую — все платформы используют разговоры на основе сообщений с системными промптами, пользовательскими сообщениями и ответами ассистента. Основная кривая обучения включает понимание специфичных для платформы функций, таких как кэширование промптов, нюансы вызова функций и оптимизация промптов под конкретную модель. Команды, которые абстрагируют свои AI-вызовы за внутренним интерфейсом, находят переключение гораздо более лёгким, чем те, у кого прямые API-вызовы по всей кодовой базе.

Следует ли использовать агрегатор API или интегрироваться напрямую?

Ответ зависит от вашего масштаба и требований. Для простых приложений с одной моделью прямая интеграция проста и избегает дополнительной зависимости. Однако по мере роста ваших потребностей до включения нескольких моделей, оптимизации затрат или требований высокой доступности агрегаторы предоставляют значительную ценность. Они упрощают мультимодельную маршрутизацию, консолидируют биллинг и обеспечивают возможности отказоустойчивости, которые иначе потребовали бы пользовательской инженерии. Незначительные накладные расходы по затратам обычно составляют 10-20%, но часто окупаются за счёт лучшей маршрутизации и сокращённого времени интеграции. Для корпоративных развёртываний, требующих строгого соответствия, оцените, соответствует ли агрегатор вашим требованиям безопасности.

Насколько надёжны бесплатные тарифы для производственного использования?

Бесплатные тарифы адекватно обслуживают разработку и небольшое производство, но на них не следует полагаться для критических приложений. Бесплатный тариф Gemini от Google с 60 RPM является самым щедрым и справляется с разумными нагрузками разработки и тестирования. Однако бесплатные тарифы обычно не предлагают гарантий SLA, могут испытывать ограничение скорости в пиковые периоды и могут измениться или исчезнуть с минимальным уведомлением. Для производственных приложений с реальными пользователями, зависящими от надёжности, закладывайте бюджет на платные тарифы, которые включают обязательства SLA. Используйте бесплатные тарифы для исследований, прототипирования и сред разработки, а не для производственных бэкендов.

Что происходит, если у поставщика сбой?

Сбои периодически происходят на всех платформах, хотя частота и продолжительность различаются. OpenAI исторически испытывала сбои в периоды высокого спроса, особенно вокруг крупных анонсов. Наличие стратегии резервного копирования разумно для производственных приложений. Варианты включают: поддержание интеграции с резервным поставщиком, который может обрабатывать трафик во время сбоев, реализацию мягкой деградации, которая ставит запросы в очередь для последующей обработки, или использование агрегатора API с автоматическим переключением. Мониторьте страницы статуса каждого поставщика и рассмотрите подписку на уведомления об инцидентах. Для критически важных для бизнеса приложений согласуйте SLA, которые включают кредиты за инциденты, и понимайте пути эскалации для сообщения о проблемах.