Claude Opus 4.6 от Anthropic представляет собой самую мощную модель рассуждений в семействе Claude, и программный доступ к ней через Messages API открывает широкий спектр возможностей для разработчиков, создающих интеллектуальные приложения. Независимо от того, проектируете ли вы сложный агентный рабочий процесс, разрабатываете клиентского ассистента или запускаете масштабные конвейеры анализа данных, первый обязательный шаг всегда один и тот же: получение API-ключа и выполнение первого успешного API-запроса. Данное руководство проведёт вас через каждый этап этого процесса -- от создания учётной записи Anthropic и генерации защищённого API-ключа до интеграции на уровне продакшена с помощью SDK, обеспечения безопасности учётных данных, управления лимитами запросов и оптимизации затрат. Все цифры по ценам и пороговые значения лимитов, приведённые в этой статье, верифицированы по официальной документации Anthropic на 8 февраля 2026 года, поэтому вы можете полагаться на эти данные при планировании бюджета и архитектуры интеграции.

Краткое содержание

Начать работу с Claude Opus 4.6 через API несложно, если понимать ключевые шаги и ограничения. Новые аккаунты Anthropic получают $5 бесплатных кредитов, которых достаточно для отправки десятков тестовых запросов к Opus 4.6. Ваш API-ключ будет иметь формат sk-ant-api03-... и отображается только один раз при создании, поэтому его необходимо скопировать немедленно. Установите официальный Python SDK командой pip install anthropic или Node.js SDK командой npm install @anthropic-ai/sdk, затем задайте ключ в переменной окружения ANTHROPIC_API_KEY, чтобы он не попал в исходный код. Стоимость Claude Opus 4.6 составляет $5 за миллион входных токенов и $25 за миллион выходных токенов, однако Batch API снижает эти расходы на 50 процентов -- до $2.50 и $12.50 соответственно -- для задач, не требующих мгновенного ответа (официальная документация Anthropic, 08.02.2026). Лимиты запросов начинаются с 50 запросов в минуту на Tier 1 и масштабируются до 4000 RPM на Tier 4, при этом пополнение на основе алгоритма «корзины токенов» обеспечивает плавную пропускную способность. Кэширование промптов позволяет снизить стоимость повторяющихся входных данных до 90 процентов, доведя эффективную цену чтения из кэша до $0.50 за миллион токенов. Всегда храните ключ в переменных окружения или менеджере секретов, никогда -- в исходном коде, и ротируйте его не реже чем каждые 90 дней.

Настройка аккаунта и генерация API-ключа

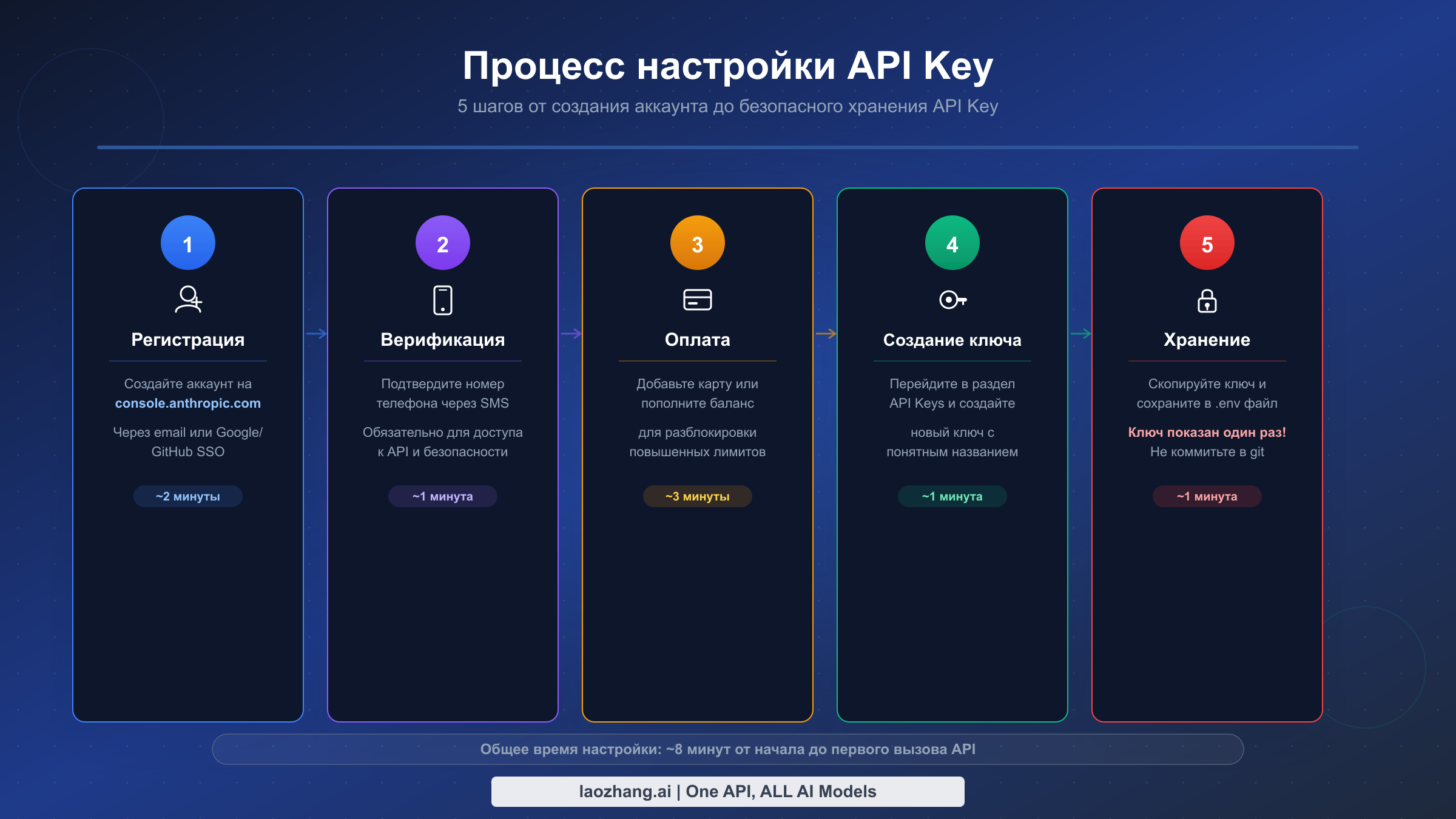

Процесс получения API-ключа Claude Opus 4.6 начинается в консоли разработчика Anthropic, и хотя сами шаги не являются сложными, некоторые детали заслуживают пристального внимания, поскольку ошибки на этом этапе могут привести к досадным задержкам в дальнейшем. Весь процесс занимает около десяти минут, если у вас под рукой поддерживаемый номер телефона и действующий способ оплаты, но разработчики из некоторых регионов или использующие виртуальные номера могут столкнуться с трудностями на этапе верификации, что потребует предварительной подготовки.

Переход в консоль и создание аккаунта -- это первое конкретное действие, которое необходимо выполнить. Откройте браузер и перейдите на console.anthropic.com, затем нажмите кнопку регистрации. Вы можете зарегистрироваться с помощью электронной почты и пароля или пройти аутентификацию через Google. При регистрации по электронной почте потребуется подтвердить адрес, перейдя по ссылке из письма, которое обычно приходит в течение нескольких секунд. При использовании Google-аутентификации процесс быстрее, так как почта уже подтверждена. Независимо от выбранного способа, созданный здесь аккаунт полностью отделён от любой потребительской подписки Claude.ai. Подписка Claude Pro или Team не предоставляет доступа к API, а ваш API-аккаунт не включает функции потребительского продукта. Это различие часто вводит в заблуждение разработчиков, полагающих, что их существующий логин Claude подойдёт для API-вызовов. Стоит подчеркнуть: это две независимые системы с отдельным биллингом, отдельным отслеживанием использования и отдельными учётными данными. Если у вас уже есть опыт работы с потребительским продуктом и вы хотите узнать больше о получении API-ключа, обратитесь к нашему полному руководству по API-ключам Claude для дополнительного контекста о различиях между этими двумя путями доступа.

Прохождение верификации по телефону -- это второй шаг, на котором некоторые разработчики сталкиваются с первым препятствием. Anthropic требует верификацию по SMS для предотвращения злоупотреблений и автоматического создания аккаунтов ботами. Вам потребуется указать номер телефона, способный принимать SMS-сообщения, и Anthropic отправит шестизначный код подтверждения, который нужно ввести на странице консоли. Критически важная деталь: номера VoIP (Voice over IP) отклоняются системой верификации. Сервисы вроде Google Voice, номера Skype и многие провайдеры виртуальных номеров не пройдут верификацию с малоинформативным сообщением об ошибке. Если вы находитесь в стране, где доставка SMS от Anthropic ненадёжна, или у вас есть доступ только к VoIP-номеру, может потребоваться физическая SIM-карта или помощь коллеги с поддерживаемым номером для начальной верификации. Каждый номер телефона может быть привязан к ограниченному количеству аккаунтов, поэтому обойти этот шаг повторными попытками с одним и тем же номером не получится.

Добавление способа оплаты и начальные бесплатные кредиты -- это третий шаг, устанавливающий ваши платёжные отношения с Anthropic. Перейдите в раздел «Billing» консоли и добавьте кредитную карту. Anthropic требует минимальный начальный депозит в размере $5, который автоматически зачисляется как предоплаченный баланс. Хорошая новость: новые аккаунты также получают $5 бесплатных приветственных кредитов (официальная документация Anthropic, 08.02.2026), поэтому ваш начальный депозит $5 фактически даёт вам $10 общей ёмкости расходов. Для Claude Opus 4.6 при цене $5 за миллион входных токенов и $25 за миллион выходных токенов эти десять долларов означают приблизительно 400 000 выходных токенов или 2 000 000 входных токенов для экспериментов, что более чем достаточно для создания и тестирования прототипа. Система биллинга работает по предоплате: вы расходуете кредитный баланс и добавляете средства по мере необходимости. Также можно настроить автоматическое пополнение, чтобы избежать перебоев при низком балансе.

Генерация API-ключа -- это шаг, который создаёт учётные данные, используемые в каждом последующем API-вызове. Перейдите в раздел «API Keys» в левой боковой панели консоли и нажмите кнопку «Create Key». Вам предложат дать ключу описательное имя, например «development-local» или «prod-backend-v1», и назначить его рабочему пространству, если ваша организация использует несколько пространств для изоляции проектов. Выбирайте имя, которое будет понятно через три месяца, когда вы будете просматривать активные ключи и пытаться определить, какой из них обслуживает какое приложение. После подтверждения создания консоль отображает полную строку ключа ровно один раз. Ключ имеет формат sk-ant-api03-, за которым следует длинная буквенно-цифровая строка. Скопируйте его немедленно и сохраните в безопасном месте, например в менеджере паролей. Если вы перейдёте на другую страницу или закроете диалоговое окно, не скопировав ключ, его невозможно будет восстановить. Придётся отозвать потерянный ключ и сгенерировать новый, а значит -- обновить все приложения, которые ссылались на старый ключ.

Проверка работоспособности ключа -- это финальная проверка перед переходом к интеграции. Простейший способ верификации -- команда cURL из терминала, отправляющая минимальный запрос к конечной точке Messages API. Если вы получите корректный JSON-ответ с сообщением от Claude, ваш ключ активен, биллинг настроен правильно, и вы готовы начинать разработку. Если вы получите ошибку аутентификации, перепроверьте, что ключ скопирован полностью, включая префикс sk-ant-api03-, и что биллинговый статус вашего аккаунта активен с положительным кредитным балансом.

Ваш первый API-вызов на Python, Node.js и cURL

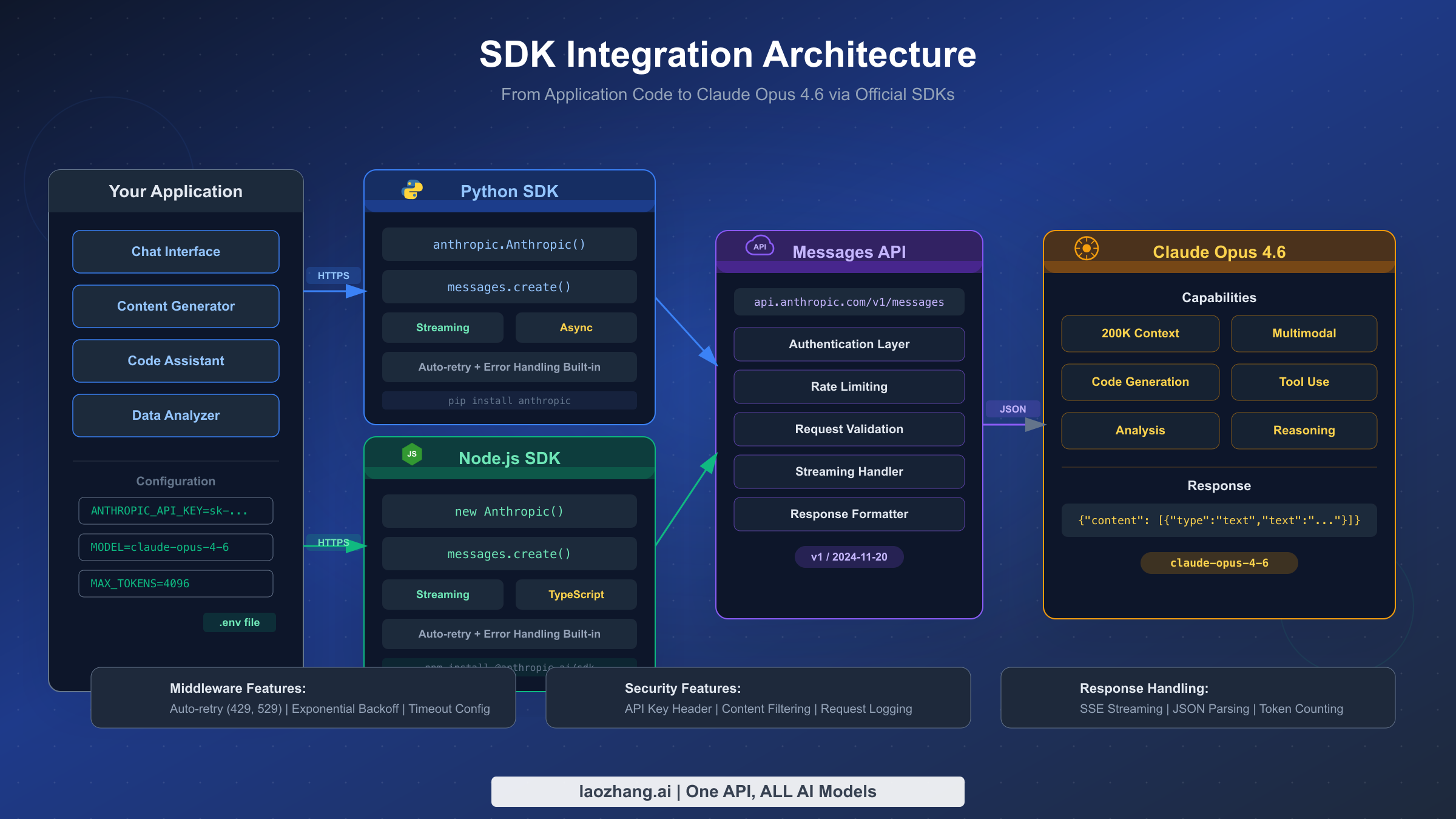

Выполнение первого успешного API-вызова к Claude Opus 4.6 -- это важный рубеж, а процесс значительно упрощён благодаря официальным SDK Anthropic для Python и Node.js, а также прямому HTTP-доступу через cURL для окружений, где SDK неприменим. Каждый из подходов даёт идентичные результаты, поскольку все они обращаются к одной и той же конечной точке Messages API, но SDK предоставляют существенные преимущества: автоматическую логику повторных попыток, типобезопасные объекты ответов и упрощённую аутентификацию, считывающую API-ключ из переменной окружения без необходимости писать код для управления заголовками. Выбор между Python и Node.js обычно определяется вашим существующим технологическим стеком и предпочтениями команды, а cURL наиболее полезен для быстрого ad-hoc тестирования и отладки.

Настройка Python SDK и выполнение первого вызова требует Python 3.8 или новее и одной команды pip install. Выполните pip install anthropic в терминале или виртуальном окружении, затем задайте API-ключ как переменную окружения командой export ANTHROPIC_API_KEY=sk-ant-api03-your-key-here на macOS и Linux или set ANTHROPIC_API_KEY=sk-ant-api03-your-key-here на Windows. После этих двух шагов следующий код отправит сообщение Claude Opus 4.6 и выведет ответ:

pythonimport anthropic client = anthropic.Anthropic() # Uses ANTHROPIC_API_KEY env var message = client.messages.create( model="claude-opus-4-6", max_tokens=1024, messages=[ {"role": "user", "content": "Explain quantum computing in one paragraph."} ] ) print(message.content[0].text)

Конструктор Anthropic() автоматически считывает переменную окружения ANTHROPIC_API_KEY, поэтому передавать ключ в качестве параметра не требуется. Параметр model указывает claude-opus-4-6 -- это строковый идентификатор модели Opus 4.6, а max_tokens задаёт верхнюю границу длины ответа. Массив messages следует формату диалога, где каждое сообщение имеет role (либо «user», либо «assistant») и строку content. При успешном выполнении этот код выводит объяснение квантовых вычислений от Claude прямо в консоль, подтверждая, что ваш API-ключ, установка SDK и сетевое подключение работают корректно.

Использование Node.js SDK следует практически идентичному шаблону. Установите пакет командой npm install @anthropic-ai/sdk, убедитесь, что переменная окружения ANTHROPIC_API_KEY задана, и выполните следующий код:

javascriptimport Anthropic from '@anthropic-ai/sdk'; const client = new Anthropic(); // Uses ANTHROPIC_API_KEY env var const message = await client.messages.create({ model: "claude-opus-4-6", max_tokens: 1024, messages: [ { role: "user", content: "Explain quantum computing in one paragraph." } ] }); console.log(message.content[0].text);

Node.js SDK по умолчанию использует ESM-импорты, поэтому убедитесь, что в package.json вашего проекта указано "type": "module" или что вы используете расширение файла .mjs. Структура объекта ответа аналогична Python SDK: message.content -- это массив блоков контента, первый из которых содержит текстовый ответ в свойстве text. Оба SDK прозрачно управляют HTTP-соединениями, сериализацией запросов и десериализацией ответов, позволяя сосредоточиться на логике приложения, а не на сантехнике HTTP-взаимодействия.

Выполнение прямого cURL-запроса -- это наиболее прозрачный способ взаимодействия с API, поскольку вы видите каждый заголовок и каждый байт тела запроса. Этот подход особенно ценен при отладке проблем с SDK или при интеграции из языка, для которого нет официального SDK:

bashcurl https://api.anthropic.com/v1/messages \ -H "content-type: application/json" \ -H "x-api-key: $ANTHROPIC_API_KEY" \ -H "anthropic-version: 2023-06-01" \ -d '{ "model": "claude-opus-4-6", "max_tokens": 1024, "messages": [ {"role": "user", "content": "Explain quantum computing in one paragraph."} ] }'

Ответ на этот вызов представляет собой JSON-объект с несколькими важными полями. Поле id -- уникальный идентификатор сообщения, который можно использовать для логирования и отладки. Поле type будет иметь значение "message", role -- "assistant", а массив content содержит блоки текста ответа. Поле model подтверждает, какая модель обработала ваш запрос, а объект usage детализирует потребление токенов на input_tokens и output_tokens, что напрямую соответствует вашему биллингу. Мониторинг этих полей использования с самого первого вызова помогает выработать интуитивное понимание стоимости токенов ещё до масштабирования до продакшн-объёмов. Для более глубокого понимания того, как количество токенов соотносится с реальными затратами, ознакомьтесь с нашим подробным разбором ценообразования Claude Opus 4.6.

Интеграция SDK для продакшн-приложений

Переход от простого тестового скрипта к интеграции продакшн-уровня требует освоения нескольких паттернов, которые базовый пример «hello world» не покрывает. Продакшн-приложениям необходимо обрабатывать потоковые ответы для пользовательских интерфейсов реального времени, управлять состоянием многоходовых диалогов между запросами, интегрировать использование инструментов для приложений, которым нужно, чтобы Claude взаимодействовал с внешними системами, и выполнять асинхронные операции, чтобы не блокировать цикл событий приложения. Каждая из этих возможностей хорошо поддерживается официальными SDK, но паттерны реализации достаточно отличаются от базового примера, чтобы заслуживать отдельного внимания и полных примеров кода.

Потоковые ответы для вывода в реальном времени необходимы для любого приложения, где пользователи ожидают ответ Claude в чат-интерфейсе, текстовом редакторе или любом другом интерактивном контексте. Без потоковой передачи приложению пришлось бы ждать генерации всего ответа целиком перед отображением, что создаёт некомфортную задержку, которая может длиться десятки секунд для сложных ответов Opus 4.6. С включённой потоковой передачей приложение получает и отображает токены по мере их генерации, создавая знакомый эффект «печатания», к которому пользователи привыкли в современных AI-чат-интерфейсах. Python SDK предоставляет элегантный потоковый интерфейс на основе контекстного менеджера, автоматически управляющий жизненным циклом соединения:

pythonwith client.messages.stream( model="claude-opus-4-6", max_tokens=1024, messages=[{"role": "user", "content": "Write a short story."}] ) as stream: for text in stream.text_stream: print(text, end="", flush=True)

Контекстный менеджер stream открывает SSE-соединение (server-sent events) к API, а итератор text_stream поочерёдно возвращает текстовые фрагменты по мере их поступления. Параметр flush=True в вызове print гарантирует, что каждый фрагмент появляется в терминале немедленно, а не буферизируется. В веб-приложении вы обычно перенаправляли бы эти фрагменты через WebSocket-соединение или SSE-эндпоинт в браузер клиента. Поток также предоставляет доступ к итоговому объекту message после завершения итерации, что позволяет извлечь общее потребление токенов для отслеживания биллинга. Важная деталь реализации: таймауты сети для потоковых запросов нужно настраивать более щедро, чем для стандартных, поскольку соединение остаётся открытым на протяжении всего времени генерации ответа, которое для длинных ответов Opus 4.6 может быть значительным.

Управление многоходовыми диалогами требует хранения истории всех предыдущих сообщений и передачи этой истории с каждым новым запросом. Messages API работает без сохранения состояния, то есть Anthropic не хранит историю ваших диалогов на своих серверах. Каждый запрос должен включать полный контекст разговора, который вы хотите, чтобы Claude учитывал. Такой подход даёт вам полный контроль над управлением диалогом, но требует дисциплинированной обработки состояния в вашем приложении. Паттерн прост: поддерживайте массив объектов сообщений, добавляйте каждое пользовательское сообщение перед отправкой и добавляйте ответ ассистента после получения:

pythonconversation = [] def chat(user_message): conversation.append({"role": "user", "content": user_message}) response = client.messages.create( model="claude-opus-4-6", max_tokens=4096, system="You are a helpful programming assistant.", messages=conversation ) assistant_message = response.content[0].text conversation.append({"role": "assistant", "content": assistant_message}) return assistant_message

По мере роста диалога накопленное количество токенов для истории сообщений увеличивается с каждым шагом, что напрямую влияет на задержку и стоимость. Диалог из 20 ходов может накопить 10 000 и более входных токенов только из истории, ещё до подсчёта последнего сообщения пользователя. Продакшн-системы обычно реализуют стратегии суммаризации диалога или скользящего окна для удержания контекста в управляемых размерах, что особенно важно, когда накопленная история приближается к пределам контекстного окна Opus 4.6.

Интеграция использования инструментов (вызов функций) позволяет Claude запрашивать информацию из внешних систем или инициировать действия в вашем приложении. Вы определяете набор инструментов с описаниями их параметров в формате JSON Schema, и Claude может выбрать вызов одного или нескольких из них во время ответа. Затем ваше приложение выполняет инструмент, возвращает результат, и Claude включает эту информацию в свой финальный ответ. Этот паттерн лежит в основе агентных приложений, где Claude выступает оркестратором, способным делать запросы к базам данных, вызывать API, искать документы или выполнять вычисления. Реализация требует цикла запрос-ответ: отправьте сообщение, проверьте, содержит ли ответ блоки tool_use, выполните запрошенные инструменты, отправьте результаты обратно и повторяйте, пока Claude не выдаст финальный текстовый ответ без запросов инструментов. Официальная документация SDK предоставляет исчерпывающие примеры этого паттерна для Python и Node.js.

Выполнение асинхронных операций предотвращает блокировку приложения во время ожидания API-ответов, что критически важно для серверных приложений, обслуживающих нескольких одновременных пользователей. Python SDK предоставляет клиент AsyncAnthropic, возвращающий ожидаемые корутины, совместимые с asyncio:

pythonimport asyncio import anthropic async def analyze_document(document_text): client = anthropic.AsyncAnthropic() message = await client.messages.create( model="claude-opus-4-6", max_tokens=2048, messages=[{ "role": "user", "content": f"Analyze this document:\n\n{document_text}" }] ) return message.content[0].text async def main(): documents = ["doc1 text...", "doc2 text...", "doc3 text..."] results = await asyncio.gather( *[analyze_document(doc) for doc in documents] ) return results

Использование asyncio.gather позволяет отправлять несколько API-вызовов параллельно и собирать все результаты вместе, что драматически быстрее последовательного выполнения тех же вызовов. Помните о ваших лимитах запросов, поскольку каждый параллельный вызов засчитывается в квоту запросов в минуту. Node.js SDK по своей природе асинхронен, так как возвращает промисы, поэтому тот же паттерн конкурентности достигается через Promise.all() без необходимости отдельного асинхронного класса клиента.

Безопасность API-ключа от разработки до продакшена

Защита вашего API-ключа Claude Opus 4.6 -- это не необязательная лучшая практика, которую можно отложить на потом. Утечка ключа может привести к несанкционированному использованию, которое опустошит ваш кредитный баланс за считанные минуты, а поскольку API тарифицируется на основе потребления без встроенного потолка расходов (если вы не настроите его самостоятельно), финансовый риск от скомпрометированного ключа может быть значительным. Помимо прямого финансового ущерба, утекший ключ может быть использован для генерации вредоносного контента, который будет приписан вашему аккаунту, создавая юридические и репутационные осложнения, далеко выходящие за рамки непосредственных затрат. Обращайтесь со своим API-ключом с той же тщательностью, с которой вы относились бы к паролю базы данных или учётным данным платёжной системы -- это правильная позиция по безопасности с первого дня.

Управление переменными окружения -- это базовая практика, которая не позволяет API-ключу попасть в исходный код, конфигурационные файлы и историю контроля версий. Создайте файл .env в корне проекта, содержащий ваш ключ, и используйте библиотеку вроде python-dotenv для Python или dotenv для Node.js для загрузки его в окружение приложения при запуске:

bash# .env file ANTHROPIC_API_KEY=sk-ant-api03-your-key-here # .gitignore (add this BEFORE your first commit) .env .env.* .env.local

Критически важный шаг, который пропускают многие разработчики, -- это добавление .env в .gitignore перед первым коммитом. Если файл .env будет зафиксирован хотя бы один раз и затем удалён, ключ останется в истории Git и может быть извлечён любым, кто имеет доступ к репозиторию. Оба SDK Anthropic -- для Python и Node.js -- спроектированы для автоматического считывания переменной окружения ANTHROPIC_API_KEY, поэтому после загрузки файла .env в окружение процесса конструктору SDK не нужен явный параметр ключа. Это соглашение устраняет соблазн жёстко прописать ключ непосредственно в исходных файлах, что является самой распространённой ошибкой безопасности при работе с API-учётными данными. Для командных окружений рассмотрите использование общего менеджера секретов вместо распространения файлов .env через небезопасные каналы вроде электронной почты или Slack.

Реализация стратегии ротации ключей сокращает окно риска, если ключ скомпрометирован без вашего ведома. Установите политику ротации API-ключей не реже чем каждые 90 дней и следуйте определённой последовательности для предотвращения простоев: сначала создайте новый ключ в консоли Anthropic и дайте ему имя, включающее дату ротации для удобства отслеживания. Затем обновите ключ во всех окружениях, начиная с разработки, потом staging и, наконец, продакшн. Проверьте, что каждое окружение корректно работает с новым ключом. Только после подтверждения, что старый ключ больше нигде не используется, отзовите его через консоль. Эта последовательность «создание-обновление-проверка-отзыв» гарантирует, что никогда не наступит момент, когда ваше приложение использует отозванный ключ, что вызвало бы немедленные ошибки аутентификации для всех API-вызовов. Для организаций с автоматизированными конвейерами развёртывания ротацию ключей можно автоматизировать через Anthropic Admin API, позволяющий программное управление ключами без ручного взаимодействия с консолью.

Ведение отдельных ключей для каждого окружения -- это организационная практика, которая ограничивает «радиус поражения» при компрометации любого отдельного ключа и обеспечивает более чёткие аудиторские следы для отслеживания использования. Создайте отдельные API-ключи для локальной машины разработки, staging- или QA-окружения и продакшн-развёртывания, назначив каждый отдельному рабочему пространству, если ваша организация Anthropic поддерживает контроль доступа на уровне рабочих пространств. Такое разделение означает, что случайное раскрытие разработчиком своего локального ключа в публичном репозитории не компрометирует продакшн-доступ. Это также позволяет устанавливать различные лимиты расходов по рабочим пространствам, гарантируя, что вышедший из-под контроля скрипт разработки не сможет израсходовать продакшн-бюджет. Давайте ключам понятные имена, например «prod-api-server-feb-2026» или «dev-local-jsmith», чтобы страница управления ключами в консоли обеспечивала мгновенную визуальную инвентаризацию того, что развёрнуто и где.

Подготовка плана реагирования на утечку ключа до того, как он вам понадобится, гарантирует, что ваша команда сможет действовать быстро при возникновении инцидента безопасности. В тот момент, когда вы подозреваете или подтверждаете, что ключ был раскрыт -- будь то через уведомление GitHub о сканировании секретов, уведомление от системы автоматического обнаружения Anthropic или собственный мониторинг, -- вы должны немедленно отозвать скомпрометированный ключ через консоль. Затем сгенерируйте новый ключ и разверните его во всех затронутых системах. Далее просмотрите журналы использования в консоли за период между предполагаемой утечкой и отзывом, чтобы оценить объём несанкционированного использования и определить характер запросов, выполненных с компрометированным ключом. Наконец, расследуйте причину утечки и внедрите меры по предотвращению повторения, такие как дополнительные pre-commit хуки, автоматическое сканирование репозиториев или более строгий контроль доступа к системам хранения секретов.

Развёртывание в продакшене с облачными менеджерами секретов обеспечивает наиболее надёжную защиту API-ключей в облачных приложениях. AWS Secrets Manager, Google Cloud Secret Manager и Azure Key Vault предлагают зашифрованное хранилище с детальным контролем доступа, возможностью автоматической ротации и полным аудитом. Вместо прямой установки переменных окружения на вычислительных инстансах ваше приложение извлекает ключ из менеджера секретов при запуске, а IAM-политики контролируют, какие сервисные аккаунты авторизованы для доступа к секрету. Такая архитектура означает, что ключ никогда не существует на диске в открытом виде и никогда не виден в файлах конфигурации развёртывания, определениях контейнеров или шаблонах оркестрации. Небольшая дополнительная задержка при обращении к менеджеру секретов при запуске приложения пренебрежимо мала по сравнению с выигрышем в безопасности.

Автоматическое сканирование репозиториев перехватывает случайные коммиты с ключами до того, как они попадут в удалённые репозитории. Установите Gitleaks или аналогичный инструмент в качестве pre-commit хука, который сканирует каждый коммит на наличие паттернов, соответствующих форматам API-ключей. Anthropic участвует в программе партнёрского сканирования секретов GitHub, что означает, что GitHub автоматически сканирует публичные репозитории на паттерны API-ключей Anthropic и уведомляет как владельца репозитория, так и Anthropic при обнаружении ключа. Однако полагаться исключительно на сканирование GitHub -- это реактивный, а не проактивный подход, и он охватывает только публичные репозитории. Запуск собственного сканирования pre-commit перехватывает ошибки до того, как они покинут вашу локальную машину, что значительно лучше, чем обнаружение проблемы после того, как ключ уже отправлен в общий или публичный репозиторий.

Лимиты запросов и обработка ошибок

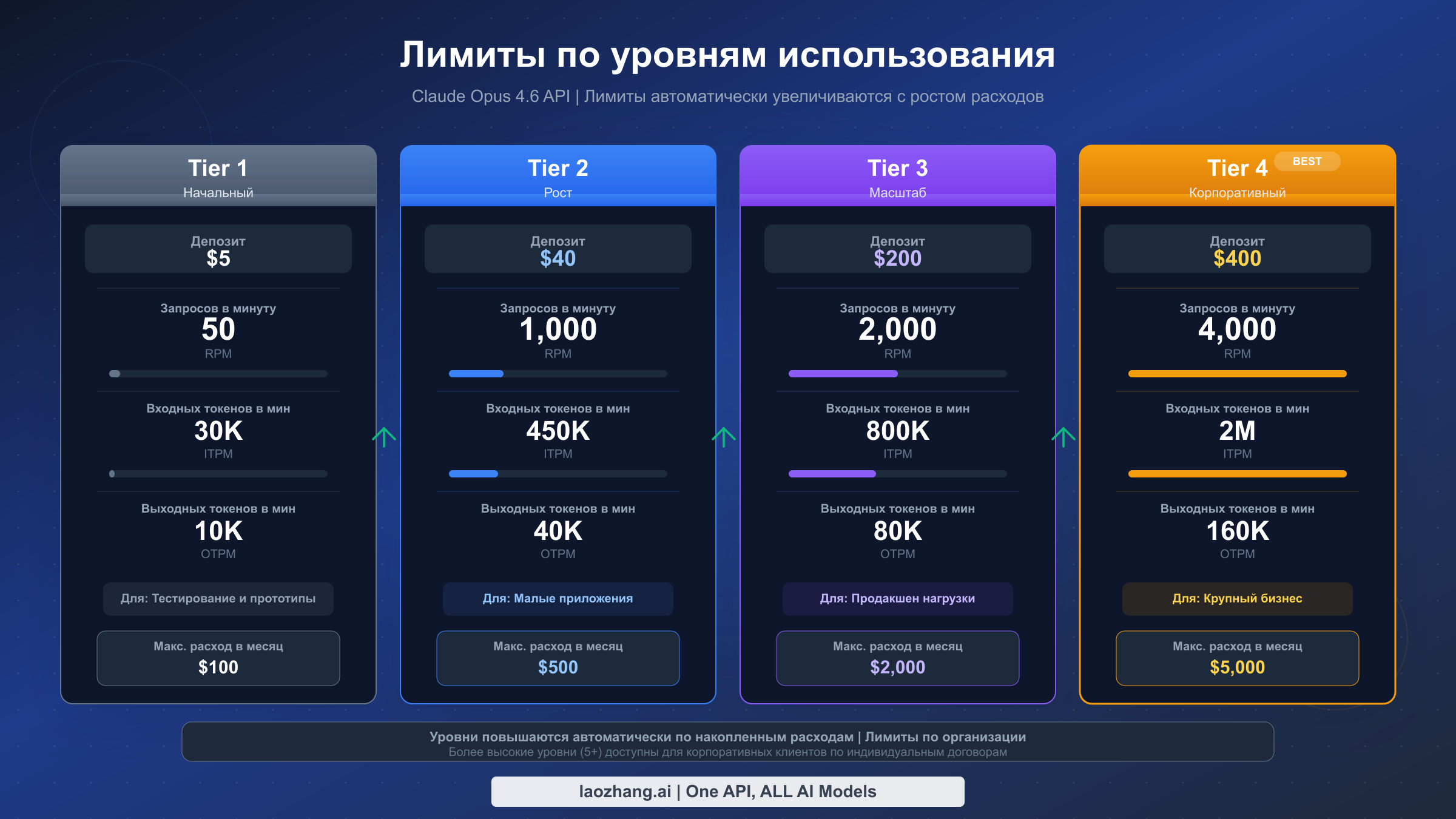

Лимиты запросов -- это ограничители, которые Anthropic устанавливает на использование API для обеспечения справедливого доступа всех клиентов и защиты инфраструктуры от всплесков трафика, способных снизить качество обслуживания. Понимание того, как работают эти лимиты, к какому уровню относится ваш аккаунт и как писать код, изящно обрабатывающий ошибки лимитов, -- всё это необходимо для создания надёжных продакшн-приложений. Самая распространённая ошибка разработчиков в отношении лимитов -- отношение к ним как к второстепенному вопросу, подключение обработки ошибок только после того, как приложение начинает падать в продакшене. Вместо этого учёт лимитов должен быть заложен в архитектуру приложения с самого начала, потому что именно разница между правильно и плохо ведущим себя клиентом определяет, обеспечит ли ваше приложение плавный пользовательский опыт или опыт, прерываемый необъяснимыми сбоями и длительными паузами.

Понимание системы уровней лимитов -- это отправная точка для планирования ёмкости. Anthropic организует доступ к API в четыре уровня с прогрессивно увеличивающимися лимитами, которые открываются по мере увеличения депозита или истории расходов на платформе. В следующей таблице показаны лимиты, специфичные для Opus 4.6, для каждого уровня (официальная документация Anthropic, 08.02.2026):

| Уровень | Необходимый депозит | Запросов в минуту | Входных токенов в минуту | Выходных токенов в минуту |

|---|---|---|---|---|

| Tier 1 | $5 | 50 | 30 000 | 8 000 |

| Tier 2 | $40 | 1 000 | 450 000 | 90 000 |

| Tier 3 | $200 | 2 000 | 800 000 | 160 000 |

| Tier 4 | $400 | 4 000 | 2 000 000 | 400 000 |

Новые аккаунты начинают с Tier 1 после внесения минимального депозита $5. Переход на более высокий уровень требует достижения порога совокупного депозита для этого уровня. Скачок с Tier 1 на Tier 2 -- самый значительный с точки зрения возможностей: лимит запросов увеличивается в 20 раз с 50 до 1 000 RPM, а ёмкость входных токенов -- в 15 раз с 30 000 до 450 000 ITPM. Если ваше приложение обслуживает более нескольких одновременных пользователей, вам почти наверняка понадобится Tier 2 или выше. Для более глубокого анализа того, как эти уровни влияют на различные модели использования, ознакомьтесь с нашим полным руководством по лимитам и уровням.

Как работает алгоритм «корзины токенов» определяет фактическую доступность ёмкости лимитов в каждый конкретный момент. Вместо простого счётчика, сбрасываемого через фиксированные интервалы, Anthropic использует алгоритм «корзины токенов» (token bucket), где ёмкость непрерывно пополняется. Представьте корзину, вмещающую максимальную ёмкость вашего уровня (например, 1 000 запросов для Tier 2) и имеющую постоянный поток пополнения, откалиброванный по вашему лимиту в минуту. При каждом запросе один «токен» извлекается из корзины. Если корзина полна, избыточное пополнение теряется. Если корзина пуста, ваш запрос получает ошибку 429 (превышение лимита). Практическое следствие состоит в том, что кратковременные всплески трафика, превышающие ваш лимит в минуту, допустимы, если вы накопили ёмкость в корзине за периоды меньшей нагрузки. И наоборот, если вы поддерживаете максимальную пропускную способность длительное время, вы израсходуете резерв корзины и затем будете ограничены ровно вашим лимитом в минуту. Такое поведение, дружелюбное к всплескам, означает, что многие приложения с переменным трафиком комфортно работают в рамках своих лимитов даже в пиковые моменты, потому что спокойные периоды между пиками пополняют корзину.

Реализация экспоненциального отступа с логикой повторных попыток превращает ошибки лимитов из фатальных исключений в изящно обрабатываемые задержки, практически незаметные для конечных пользователей. Стратегия проста по концепции: при получении ошибки 429 подождите немного и попробуйте снова, удваивая время ожидания с каждой последовательной неудачей до достижения максимального времени ожидания. Следующая реализация на Python демонстрирует надёжный паттерн повторных попыток, обрабатывающий как ошибки лимитов, так и транзиентные ошибки сервера:

pythonimport time import anthropic def call_with_retry(client, max_retries=5, **kwargs): for attempt in range(max_retries): try: return client.messages.create(**kwargs) except anthropic.RateLimitError as e: if attempt == max_retries - 1: raise wait_time = min(2 ** attempt, 60) retry_after = e.response.headers.get("retry-after") if retry_after: wait_time = int(retry_after) time.sleep(wait_time) except anthropic.APIStatusError as e: if e.status_code >= 500: time.sleep(2 ** attempt) continue raise

Эта функция проверяет заголовок retry-after, который Anthropic включает в ответы с ошибкой лимита, указывающий точное количество секунд ожидания до того, как сервер примет ваш следующий запрос. Использование значения этого заголовка, когда оно доступно, более эффективно, чем слепой экспоненциальный отступ, поскольку позволяет избежать как слишком ранней повторной попытки (впустую потраченный запрос), так и слишком долгого ожидания (ненужная дополнительная задержка). Функция также обрабатывает серверные ошибки 500-й серии более простой стратегией повторных попыток, поскольку эти транзиентные инфраструктурные ошибки редки, но случаются и почти всегда разрешаются в течение нескольких секунд. Для приложений, сталкивающихся с постоянными ошибками 429, обратитесь к нашему специальному руководству по исправлению ошибок 429 rate limit для более продвинутых стратегий, включая очереди запросов и сброс нагрузки.

Понимание лимитов с учётом кэширования -- это важный нюанс, влияющий на планирование пропускной способности. При использовании кэширования промптов входные токены, обслуживаемые из кэша, не засчитываются в лимит входных токенов в минуту (ITPM). Только некэшированные, заново обработанные входные токены расходуют вашу квоту ITPM. Это означает, что приложения с высоким процентом попаданий в кэш фактически имеют значительно более высокую входную пропускную способность, чем их номинальный уровень предполагает. Например, аккаунт Tier 2 с 90-процентным попаданием в кэш для промпта из 10 000 токенов расходует только 1 000 некэшированных входных токенов за запрос из своего лимита в 450 000 ITPM, а не полные 10 000. Такое поведение с учётом кэша создаёт сильный стимул проектировать архитектуру промптов вокруг кэширования, потому что это одновременно снижает стоимость каждого запроса и увеличивает эффективное количество запросов, которые вы можете выполнить за минуту. Лимиты выходных токенов не зависят от кэширования, поскольку выходные токены всегда генерируются заново.

Стратегии оптимизации затрат на API-интеграцию

Claude Opus 4.6 обеспечивает наивысшее качество рассуждений в семействе моделей Claude, но при цене $5 за миллион входных токенов и $25 за миллион выходных токенов (официальная документация Anthropic, 08.02.2026) это также наиболее дорогой уровень. Построение экономически эффективной интеграции не означает полный отказ от Opus 4.6. Скорее, это означает использование подходящей модели для каждой задачи, применение кэширования и пакетной обработки для снижения стоимости запросов и тщательный мониторинг расходов, позволяющий выявлять возможности оптимизации прежде, чем они превратятся в бюджетные проблемы. Наиболее успешные продакшн-развёртывания обычно маршрутизируют запросы к различным моделям в зависимости от сложности задачи, резервируют кэширование промптов для высокочастотных системных промптов и используют Batch API для любых нагрузок, не требующих ответов в реальном времени.

Выбор правильной модели для каждой задачи -- это наиболее эффективная доступная вам оптимизация затрат, поскольку разница в цене между уровнями моделей существенна. Claude Opus 4.6 при $5/$25 за миллион токенов для входа и выхода соответственно в пять раз дороже Claude Haiku 4.5 при $1/$5 за миллион токенов по обоим параметрам. Claude Sonnet 4.5 занимает промежуточное положение при $3/$15 за миллион токенов. Для многих типичных задач, включая суммаризацию текста, простые ответы на вопросы, классификацию и извлечение данных, Haiku или Sonnet дают результаты, функционально неотличимые от Opus, при значительно меньшей стоимости. Резервируйте Opus 4.6 для задач, которые действительно требуют его превосходных рассуждений: сложный многоэтапный анализ, нюансированное креативное письмо, продвинутая генерация кода с архитектурным мышлением и задачи, требующие синтеза информации из очень длинных контекстов. Маршрутизатор, классифицирующий входящие запросы по сложности и направляющий их к соответствующей модели, может снизить вашу среднюю стоимость запроса на 60-80 процентов по сравнению с отправкой всего на Opus. Подробный разбор ценообразования всех моделей см. в нашем полном руководстве по ценам Claude API.

В следующей таблице показано, как сочетание стратегий оптимизации даёт кумулятивную экономию:

| Стратегия | Стандартная стоимость | Оптимизированная стоимость | Экономия |

|---|---|---|---|

| Opus 4.6 стандарт | $5 / $25 MTok | -- | Базовая линия |

| Кэширование промптов | $5 вход | $0.50 чтение из кэша | До 90% на входе |

| Batch API | $5 / $25 | $2.50 / $12.50 | 50% по всем параметрам |

| Кэш + Batch вместе | $5 / $25 | ~$0.25 / $12.50 | До 95% на входе |

(Официальная документация Anthropic, 08.02.2026)

Реализация кэширования промптов для повторяющихся системных промптов нацелена на наиболее распространённый источник напрасного расхода входных токенов: отправку одного и того же длинного системного промпта или контекста документа с каждым запросом. Когда вы отмечаете часть входных данных точкой разрыва кэша, Anthropic сохраняет этот контент и обслуживает его из кэша при последующих запросах с тем же содержимым в той же позиции. Стоимость чтения из кэша составляет всего $0.50 за миллион токенов по сравнению со стандартной стоимостью $5 за миллион для обработки входных данных Opus 4.6, что представляет собой снижение на 90 процентов. Это особенно эффективно для приложений, встраивающих длинный системный промпт, справочный документ или набор few-shot примеров в начало каждого запроса. Чат-бот с системным промптом из 4 000 токенов, выполняющий 1 000 запросов в день, потратит $0.02 в день на кэшированные чтения вместо $0.20 на некэшированные входные данные только для системного промпта, экономя $5.40 в месяц на одном этом компоненте. Кэш имеет минимальное время жизни в пять минут и обновляется при каждом обращении, поэтому приложения с устойчивым трафиком эффективно поддерживают кэш. Подробности реализации см. в нашем руководстве по кэшированию промптов.

Использование Batch API для задач, не требующих немедленного ответа обеспечивает простое 50-процентное снижение стоимости без изменений кода, кроме переключения на конечную точку пакетной отправки. Batch API принимает файл, содержащий множество запросов сообщений, обрабатывает их асинхронно (обычно в течение нескольких часов, хотя Anthropic гарантирует завершение в течение 24 часов) и возвращает все результаты в одном загружаемом выходном файле. Это идеально подходит для таких сценариев, как ночная обработка документов, массовая классификация, конвейеры генерации контента, наборы для оценки и тестирования и любые другие нагрузки, где ответ не нужен в реальном времени. При пакетной цене $2.50 за миллион входных токенов и $12.50 за миллион выходных токенов для Opus 4.6 экономия автоматическая и не требует изменений в инженерии промптов или логике обработки выходных данных. Единственный компромисс -- задержка: вы отправляете пакет и проверяете завершение, а не получаете немедленный ответ. Для нагрузок, допускающих такую задержку, Batch API должен быть вашим вариантом по умолчанию.

Настройка мониторинга расходов и оповещений предотвращает перерасход бюджета и обеспечивает видимость траектории затрат до того, как это станет проблемой. Страница «Usage» в консоли Anthropic показывает ваши ежедневные и ежемесячные расходы с разбивкой по моделям, и вы можете настроить лимиты расходов на уровне рабочего пространства для создания жёсткого потолка потребления. Установите лимит расходов немного выше ожидаемого ежемесячного бюджета и настройте email-оповещения на 50, 75 и 90 процентов от этого лимита, чтобы ваша команда получала предупреждения заблаговременно. В коде приложения логируйте объект usage из каждого API-ответа, включающий точные количества input_tokens и output_tokens, и агрегируйте их в вашей системе мониторинга для отслеживания тенденций затрат на уровне приложения, а не полагаясь исключительно на представление аккаунта в консоли. Такое отслеживание на уровне приложения помогает выявить, какие функции, пользователи или эндпоинты генерируют наибольшие затраты, что позволяет проводить целевую оптимизацию.

Изучение сторонних API-платформ может дополнить ваш прямой доступ к Anthropic для определённых сценариев. Для разработчиков, ищущих более гибкие варианты ценообразования, оплату по факту без требований к депозиту или доступ к нескольким провайдерам ИИ-моделей через единую конечную точку API, такие платформы, как laozhang.ai, предлагают доступ к моделям Claude наряду с моделями от OpenAI, Google и других провайдеров, с альтернативными структурами биллинга и единой документацией, доступной на https://docs.laozhang.ai/. Эти платформы могут быть особенно полезны для сред разработки и тестирования, где меньшие трение единого API перевешивают преимущества прямых отношений с провайдером, или для приложений, которым нужно маршрутизировать запросы между моделями различных провайдеров на основе доступности или стоимости.

Часто задаваемые вопросы

Можно ли использовать Claude API бесплатно? Claude API не является полностью бесплатным, но Anthropic предоставляет значимые бесплатные кредиты, чтобы помочь новым разработчикам начать работу без финансовых обязательств. При создании нового API-аккаунта Anthropic и добавлении способа оплаты с минимальным депозитом $5 на ваш аккаунт зачисляется $5 бесплатных кредитов (официальная документация Anthropic, 08.02.2026). В сочетании с депозитом это даёт вам $10 общей ёмкости расходов. При ценах Claude Opus 4.6 -- $5 за миллион входных токенов и $25 за миллион выходных -- этих десяти долларов достаточно для существенных экспериментов: можно отправить сотни запросов среднего размера и тщательно оценить возможности модели для вашего сценария. После исчерпания бесплатных кредитов API работает по предоплатной модели: вы добавляете средства на аккаунт и расходуете их. Ежемесячной подписки или минимальных периодических платежей за доступ к API нет, вы платите только за фактическое потребление.

Какой формат имеет API-ключ Claude? API-ключи Claude имеют характерный формат, начинающийся с префикса sk-ant-api03-, за которым следует длинная строка буквенно-цифровых символов. Общая длина ключа обычно составляет около 100 символов. Структура префикса служит нескольким целям: sk- указывает, что это секретный ключ, который нельзя раскрывать публично, ant идентифицирует Anthropic как издателя, api03 указывает версию генерации ключа, а оставшиеся символы -- уникальный криптографический идентификатор, привязанный к вашему конкретному аккаунту и рабочему пространству. Этот чётко определённый формат позволяет инструментам вроде Gitleaks и системе сканирования секретов GitHub обнаруживать случайно зафиксированные ключи с высокой точностью и низким уровнем ложных срабатываний. Если вы создаёте валидацию ввода для страницы настроек, принимающей API-ключи, можете проверять наличие префикса sk-ant-api03- как базовую проверку формата, хотя всегда следует верифицировать ключ через фактический API для подтверждения его активности и авторизации.

Можно ли использовать логин Claude.ai для API? Нет, потребительский продукт Claude.ai и Claude API -- это отдельные системы с полностью независимой аутентификацией. Ваш аккаунт Claude.ai, будь он на бесплатном тарифе, Claude Pro или Claude Team, не предоставляет доступа к API, и его учётные данные не пройдут аутентификацию на конечной точке API. И наоборот, наличие API-аккаунта не даёт вам доступа к функциям чат-интерфейса Claude.ai. Такое разделение существует потому, что два продукта обслуживают разные аудитории с разными потребностями: Claude.ai -- это потребительский диалоговый продукт с собственной моделью подписки, а API -- это инфраструктурный сервис для разработчиков с ценообразованием на основе потребления. Вы можете создать оба типа аккаунтов, используя один и тот же email, но они будут иметь отдельные пароли (или OAuth-сессии), отдельные конфигурации биллинга и отдельное отслеживание использования.

Как проверить текущий уровень лимитов? Ваш текущий уровень лимитов отображается в консоли Anthropic в разделе Settings, на странице Limits. Эта страница показывает номер вашего уровня, связанные с ним лимиты для каждой модели и порог депозита или расходов, необходимый для перехода на следующий уровень. Вы также можете определить ваши эффективные лимиты программно, проверяя заголовки ответов, которые Anthropic включает в каждый API-ответ. Заголовки anthropic-ratelimit-requests-limit, anthropic-ratelimit-requests-remaining и anthropic-ratelimit-requests-reset сообщают соответственно ваш лимит запросов в минуту, сколько запросов осталось в текущем окне и когда окно сбрасывается. Аналогичные заголовки существуют для лимитов входных и выходных токенов. Мониторинг этих заголовков в приложении обеспечивает видимость потребления лимитов в реальном времени без необходимости ручной проверки консоли.

Что делать, если API-ключ утёк? Если вы обнаружили или подозреваете, что ваш API-ключ был раскрыт, действуйте немедленно, поскольку каждая минута, пока ключ остаётся активным, -- это минута, в течение которой злоумышленник может расходовать ваши кредиты или генерировать контент от имени вашего аккаунта. Первый шаг -- войти в консоль Anthropic, перейти на страницу «API Keys» и отозвать скомпрометированный ключ. Это мгновенно аннулирует ключ, и дальнейшие запросы с ним будут невозможны. Затем создайте новый ключ, обновите его во всех средах развёртывания и убедитесь, что приложения работают с новым ключом. Наконец, проверьте страницу «Usage» в консоли на предмет необычных расходов между предполагаемым временем утечки и моментом отзыва ключа. Если вы обнаружите несанкционированные списания, обратитесь в службу поддержки Anthropic с деталями. В качестве превентивной меры включите сканирование секретов GitHub для ваших репозиториев и установите инструмент pre-commit хука, например Gitleaks, который сканирует паттерны API-ключей перед разрешением коммитов.

Можно ли получить доступ к Claude API через AWS или Google Cloud? Да, Anthropic сотрудничает с Amazon Web Services и Google Cloud, предоставляя модели Claude через их соответствующие платформы ИИ-сервисов. На AWS Claude доступен через Amazon Bedrock, что означает аутентификацию с использованием существующих IAM-учётных данных AWS вместо API-ключа Anthropic, а биллинг проходит через ваш аккаунт AWS. На Google Cloud Claude доступен через Vertex AI с аналогичными паттернами интеграции, используя учётные данные Google Cloud и биллинг. Эти интеграции с облачными провайдерами особенно привлекательны для организаций, имеющих существующие корпоративные соглашения с AWS или Google Cloud, поскольку использование API может быть консолидировано в единый счёт от вендора и управляться теми же политиками контроля доступа и соответствия требованиям, что и другие облачные сервисы. Идентификаторы моделей и некоторые параметры запросов немного отличаются между прямым Anthropic API и версиями облачных провайдеров, поэтому ознакомьтесь с документацией конкретного облака для точных деталей интеграции.

Есть ли более дешёвый способ доступа к моделям Claude? Несколько стратегий могут значительно снизить стоимость каждого запроса без ущерба для качества ответов. Наиболее эффективен Batch API, предоставляющий фиксированную 50-процентную скидку на стоимость входных и выходных токенов для нагрузок, не требующих ответов в реальном времени, снижая цены Opus 4.6 до $2.50/$12.50 за миллион токенов. Кэширование промптов снижает стоимость входных данных до 90 процентов для повторяющегося контента, при цене чтения из кэша всего $0.50 за миллион токенов. Использование правильной модели для каждой задачи -- ещё одна высокоэффективная стратегия: Claude Haiku 4.5 при $1/$5 за миллион токенов обрабатывает простые задачи за одну пятую стоимости Opus. Сочетание всех трёх подходов -- Haiku для простых задач, Sonnet для средних, Opus с кэшированием для сложных и пакетная обработка для всего, что не требует немедленности -- может снизить вашу эффективную среднюю стоимость на 70-90 процентов по сравнению с отправкой каждого запроса на Opus 4.6 по стандартным ценам. Сторонние платформы, такие как laozhang.ai, также предлагают альтернативные структуры ценообразования, которые некоторые разработчики находят более гибкими для определённых сценариев, особенно на этапах разработки и прототипирования, когда предсказуемость затрат важнее максимальной пропускной способности.