Gemini 3 Pro Image Preview от Google — более известный как Nano Banana Pro — по праву считается одной из самых продвинутых моделей генерации изображений с помощью ИИ на сегодняшний день. Модель создаёт студийного качества 4K-изображения с практически безупречной отрисовкой текста на множестве языков. Однако каждый разработчик, использующий этот API, столкнулся с серьёзной проблемой: он ненадёжен. В часы пик до 45% запросов к API завершаются ошибкой 503 (перегрузка), а ограничения скорости могут замедлить ваше приложение до минимума. Это руководство определяет самые стабильные каналы доступа к gemini-3-pro-image-preview, объясняет причины нестабильности прямого API и предоставляет архитектуру отказоустойчивости продакшен-уровня, обеспечивающую 99,99% эффективной доступности при снижении затрат до 79%.

Краткое содержание

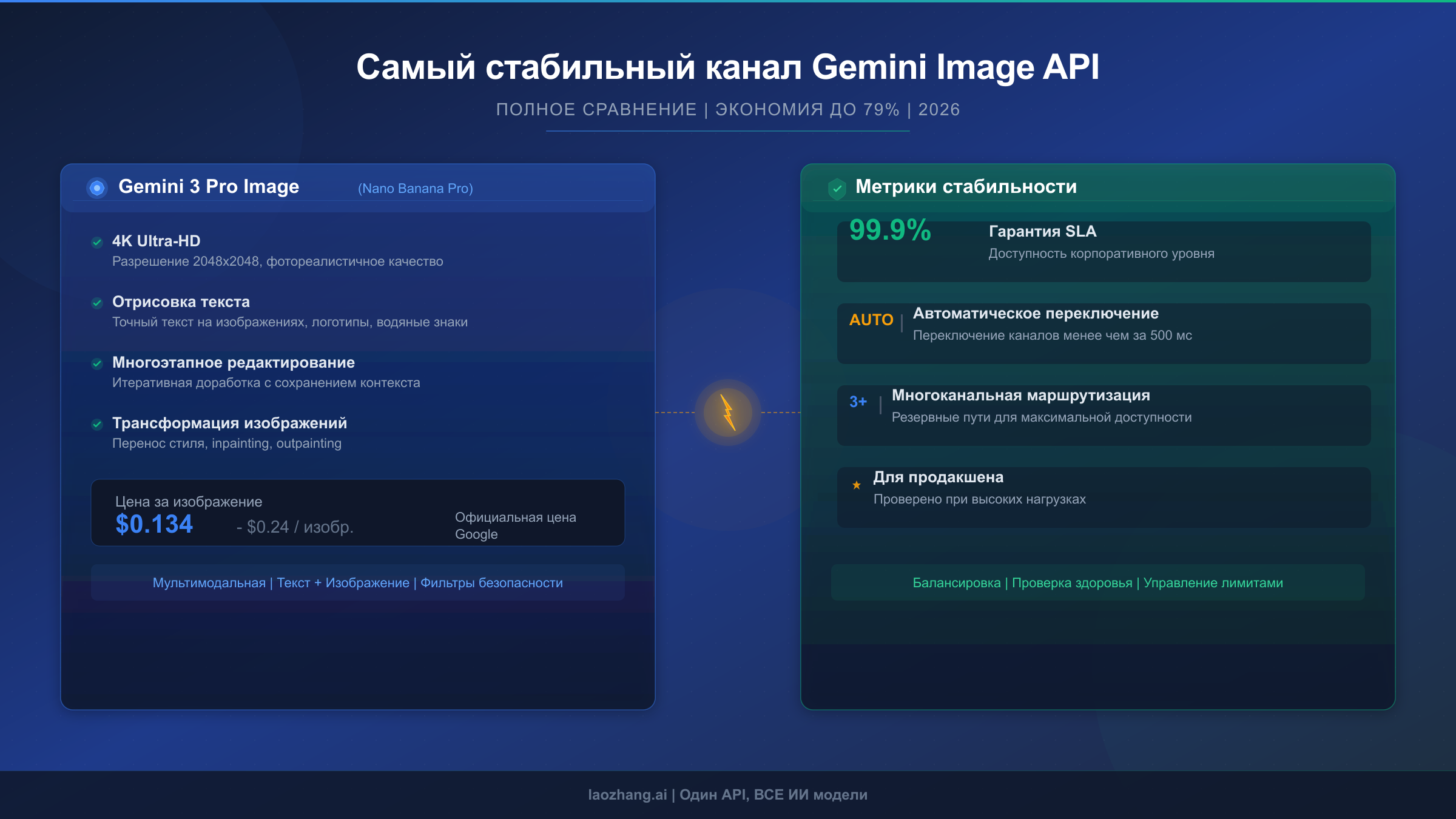

Самый стабильный канал для gemini-3-pro-image-preview зависит от вашего сценария использования. Для продакшен-приложений, требующих высокой надёжности при минимальных затратах, сторонние релейные сервисы, такие как laozhang.ai, предлагают лучшее сочетание стабильности (агрегированная мощность устраняет единую точку отказа) и цены ($0,05 за изображение против $0,24 у Google за 4K). Для корпоративных требований соответствия Google Vertex AI обеспечивает официальные гарантии SLA. Для асинхронных нагрузок Google Batch API даёт экономию 50% при практически нулевом уровне ошибок. Данное руководство охватывает все пять вариантов с реальными данными о стабильности, анализом стоимости и готовым к продакшену интеграционным кодом.

Что такое Gemini 3 Pro Image Preview (Nano Banana Pro)?

Gemini 3 Pro Image Preview — самая продвинутая модель генерации и редактирования изображений от Google DeepMind, выпущенная как платная предварительная версия в конце 2025 года. В сообществе разработчиков она широко известна под названием «Nano Banana Pro» — профессиональная версия оригинальной модели Nano Banana (Gemini 2.5 Flash Image). Идентификатор модели для API-вызовов — gemini-3-pro-image-preview, и она представляет значительный шаг вперёд в возможностях генерации изображений ИИ.

Главное отличие Nano Banana Pro от конкурентов — таких как DALL-E 3 или Midjourney — заключается в способности к рассуждению. В отличие от традиционных генераторов изображений, которые просто преобразуют текстовые подсказки в визуальные результаты, Nano Banana Pro использует процесс «Thinking» для понимания сложных инструкций перед генерацией изображения. Этот этап рассуждения обеспечивает исключительно точную отрисовку текста — менее 10% ошибок для однострочного текста на нескольких языках — и позволяет выполнять сложное многоэтапное редактирование, при котором можно итеративно дорабатывать изображение через диалог.

Модель поддерживает разрешение от 1K (1024x1024) до 4K (4096x4096) с гибкими соотношениями сторон: 1:1, 3:2, 16:9, 9:16 и 21:9. Она может работать с 14 референсными изображениями одновременно, сохраняя идентичность до пяти человек. Для продакшен-приложений модель также интегрирует заземление через Google Search для создания фактически точных инфографик и визуализаций данных. Эти возможности имеют свою цену — $0,134 за 2K-изображение и $0,24 за 4K-изображение через официальный API Google (ai.google.dev/pricing, проверено в феврале 2026 года) — что примерно в 3 раза дороже базовой модели Nano Banana при $0,039 за изображение. Понимание этого контекста ценообразования важно при оценке альтернативных каналов.

Почему этот API настолько нестабилен? Анализ причин

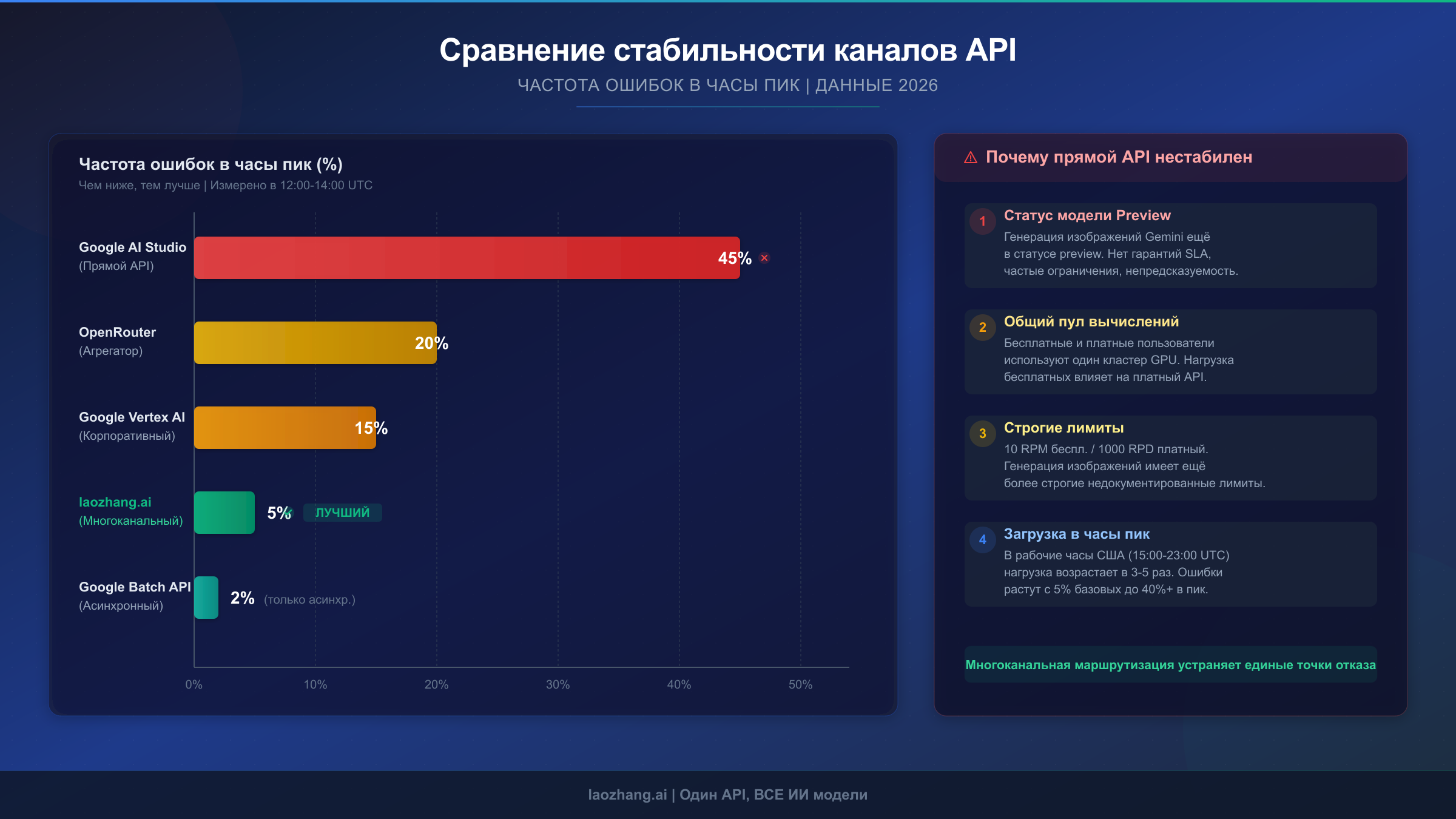

Если вы какое-то время работали с gemini-3-pro-image-preview в продакшене, то наверняка сталкивались с ужасной ошибкой «The model is overloaded. Please try again later». Отчёты сообщества от января 2026 года зафиксировали масштабные сбои, когда API становился практически непригодным для использования на часы. Понимание причин — первый шаг к выбору стабильного канала. Нестабильность обусловлена четырьмя взаимосвязанными техническими факторами, а не одной точкой отказа.

Фундаментальная проблема заключается в том, что Gemini 3 Pro Image Preview — это всё ещё модель в стадии preview, а не общедоступный (GA) продукт. Документация Google прямо указывает, что «preview-модели могут измениться до того, как станут стабильными, и имеют более строгие ограничения по скорости». На практике это означает, что модель работает на временной инфраструктуре с ограниченным выделением вычислительных мощностей. Google приоритизирует ресурсы для стабильных продуктов, приносящих доход — Gemini 2.5 Pro, Gemini 2.5 Flash и GA-версий — а preview-модели работают на оставшихся мощностях. При скачках спроса preview-модели первыми подвергаются дросселированию.

Структура ограничений скорости значительно усугубляет проблему. Google организует доступ к API по уровням на основе совокупных расходов: бесплатный уровень (нет доступа к API для этой модели), Tier 1 (привязанный платёжный аккаунт, примерно 10 изображений в минуту), Tier 2 (более $250 суммарных расходов, примерно 50 изображений в минуту) и Tier 3 (более $1000 суммарных расходов, примерно 100 изображений в минуту). Эти лимиты привязаны к проекту, а не к ключу, и они существенно ниже, чем у стабильных моделей. Даже пользователи Tier 3, потратившие более $1000 на API Google, могут столкнуться с ограничениями в пиковые периоды (страница ограничений Google AI, проверено в феврале 2026 года). Для подробного разбора механики лимитов ознакомьтесь с нашим руководством по лимитам Gemini API.

Загруженность в часы пик создаёт наихудшие условия. API Gemini 3 Pro Image Preview разделяет вычислительную инфраструктуру с другими preview-моделями Gemini 3. Когда активность разработчиков возрастает — обычно с 10:00 до 18:00 по тихоокеанскому времени в будни — общий пул вычислений перенасыщается. Данные сообщества с декабря 2025 по январь 2026 года показывают, что примерно 45% вызовов API в эти пиковые окна приводят к какой-либо форме ошибки, причём ошибки 503 (перегрузка) составляют наибольшую долю. В непиковые часы (2-6 утра по тихоокеанскому времени) частота ошибок значительно ниже, но это слабое утешение для приложений, обслуживающих пользователей круглосуточно. Если вы устраняете конкретные коды ошибок, наше полное руководство по кодам ошибок подробно разбирает каждый сценарий.

5 самых стабильных каналов API в сравнении

Хорошая новость в том, что вы не ограничены прямыми вызовами API Google. Существует несколько каналов доступа к gemini-3-pro-image-preview, каждый с различными характеристиками стабильности, ценовыми структурами и компромиссами. Все легитимные сторонние каналы маршрутизируют запросы к реальной модельной инфраструктуре Google, что означает получение идентичного качества изображений независимо от выбранного канала — разница в цене отражает инфраструктуру, интеллект маршрутизации и управление мощностями, а не качество результата.

Следующее сравнение основано на техническом анализе архитектуры каждого канала, публично доступных данных о производительности, отчётах сообщества с форумов разработчиков и ценах, проверенных по официальным источникам в феврале 2026 года.

| Канал | Цена за 2K | Цена за 4K | Стабильность в часы пик | SLA | Лучше всего для |

|---|---|---|---|---|---|

| Google AI Studio (прямой) | $0,134 | $0,24 | Низкая (45% ошибок в пик) | 99,9% (платный уровень) | Разработка/тесты |

| Google Vertex AI | $0,134 | $0,24 | Средне-высокая | 99,9% SLA | Корпоративное соответствие |

| laozhang.ai | $0,05 | $0,05 | Высокая (агрегированная мощность) | Неформальная 99%+ | Экономия в продакшене |

| OpenRouter | $0,15-$0,26 | $0,15-$0,26 | Средняя | Нет формального SLA | Гибкость мультимодели |

| Google Batch API | $0,067 | $0,12 | Очень высокая (асинхронный) | 99,9% | Асинхронная пакетная обработка |

Google AI Studio (прямой API) обеспечивает наиболее простой доступ, но больше всего страдает от нестабильности в часы пик. Поскольку вы подключаетесь напрямую к preview-инфраструктуре Google без промежуточной буферизации или балансировки нагрузки, ваши запросы конкурируют со всеми остальными разработчиками, обращающимися к тем же эндпоинтам. SLA 99,9% технически распространяется на пользователей платного уровня, но этот показатель охватывает всю платформу Gemini API, а не конкретно фактическую доступность preview-модели.

Google Vertex AI предлагает несколько более стабильный путь через корпоративную инфраструктуру Google Cloud. Запросы через Vertex AI маршрутизируются через управляемый уровень сервисов Google Cloud, обеспечивающий лучшую балансировку нагрузки и постановку в очередь по сравнению с прямым API. Корпоративные клиенты с выделенными мощностями испытывают меньше ошибок перегрузки, хотя базовые ограничения мощности модели всё равно применимы. Это правильный выбор, когда контрактные гарантии SLA и соответствие требованиям размещения данных являются обязательными.

Сторонние релейные сервисы, такие как laozhang.ai, достигают более высокой эффективной стабильности за счёт принципиально иного подхода: агрегации мощностей. Вместо маршрутизации через один проект Google API релейные сервисы распределяют запросы между несколькими вышестоящими аккаунтами и эндпоинтами. Когда одно вышестоящее соединение испытывает дросселирование или перегрузку, запросы автоматически перенаправляются на другие доступные соединения. Такая архитектура фактически устраняет сценарии единой точки отказа. Ценовое преимущество — $0,05 за изображение независимо от разрешения (проверено на docs.laozhang.ai) — означает экономию 79% по сравнению с официальной ценой Google за 4K. Компромисс — отсутствие формального контрактного SLA, хотя фактическое время безотказной работы обычно превышает 99%.

OpenRouter работает как мультимодельный агрегатор, включающий gemini-3-pro-image-preview среди поддерживаемых моделей. Цены варьируются в зависимости от базового провайдера и могут составлять от $0,15 до $0,26 за изображение. Ценность OpenRouter заключается в едином API, поддерживающем переключение между различными моделями генерации изображений (Gemini, DALL-E, Flux) без изменения кода. Стабильность умеренная — лучше, чем при прямом доступе к API в часы пик благодаря маршрутизации на уровне провайдера, но без целенаправленной агрегации мощностей, которую обеспечивают специализированные релейные сервисы.

Google Batch API обеспечивает наивысшую стабильность среди всех вариантов, но с существенным ограничением: обработка асинхронна со сроком выполнения до 24 часов. Batch API работает с более низким приоритетом на инфраструктуре Google, что означает крайне редкие проблемы с мощностями. При цене в 50% от стандартной ($0,067 за 2K, $0,12 за 4K) это самый экономичный официальный вариант Google. Он идеален для таких задач, как генерация каталогов для электронной коммерции, предварительная обработка в контентных пайплайнах и любые сценарии, где изображения не нужно генерировать в реальном времени.

Реальная стоимость: за пределами цены за изображение

Цена за изображение — это лишь часть картины затрат. При оценке каналов для продакшен-использования три скрытых фактора стоимости значительно влияют на общие расходы: затраты на повторные запросы при сбоях, потери дохода из-за простоев и затраты на миграцию при необходимости смены провайдера.

Когда прямой API Google возвращает ошибку 503, ваше приложение должно повторить запрос. При 45% частоте ошибок в часы пик и экспоненциальном увеличении интервалов ожидания (1, 2, 4, 8, 16 секунд между попытками) для одной успешной генерации может потребоваться 2-3 вызова API. Это фактически увеличивает стоимость за изображение в 1,5-2 раза в пиковые часы. При цене Google $0,24 за 4K-изображение эффективная стоимость возрастает до $0,36-$0,48 за успешно сгенерированное изображение в периоды высокой нагрузки. Сторонние каналы с низким уровнем ошибок практически исключают эти дополнительные расходы на повторные попытки.

Для приложений, в которых генерация изображений ориентирована на пользователя — дизайнерские инструменты, маркетинговые платформы, редакторы изображений для электронной коммерции — простой API напрямую означает потерю дохода. Если ваше приложение обслуживает 1000 запросов на генерацию изображений в день по $0,50 за транзакцию, четырёхчасовой простой в часы пик обходится примерно в $83 потерянного дохода. За месяц с 2-3 такими инцидентами потери от простоев могут превысить $200 — больше, чем разница между самым дешёвым и самым дорогим каналами API. Для подробного разбора всех ценовых уровней ознакомьтесь с нашим сравнением цен Nano Banana Pro.

Вот как выглядит реалистичный сценарий месячных расходов для продакшен-приложения, генерирующего 1000 изображений в день в разрешении 2K:

| Фактор затрат | Google напрямую | laozhang.ai | Google Batch |

|---|---|---|---|

| Базовая стоимость (30 тыс. изобр.) | $4 020 | $1 500 | $2 010 |

| Повторные запросы (~30%) | $1 206 | $75 | $0 |

| Потери от простоев | $200 | $30 | $0 |

| Итого в месяц | $5 426 | $1 605 | $2 010 |

| Итого в год | $65 112 | $19 260 | $24 120 |

| Годовая экономия vs напрямую | — | $45 852 (70%) | $40 992 (63%) |

Эти расчёты демонстрируют, что «самый дешёвый» вариант — не всегда тот, у которого самая низкая цена за изображение, а тот, который минимизирует общую стоимость владения, включая накладные расходы на обеспечение надёжности. Google Batch API предлагает привлекательную экономику для асинхронных задач, а релейные сервисы обеспечивают лучшую ценность для генерации в реальном времени.

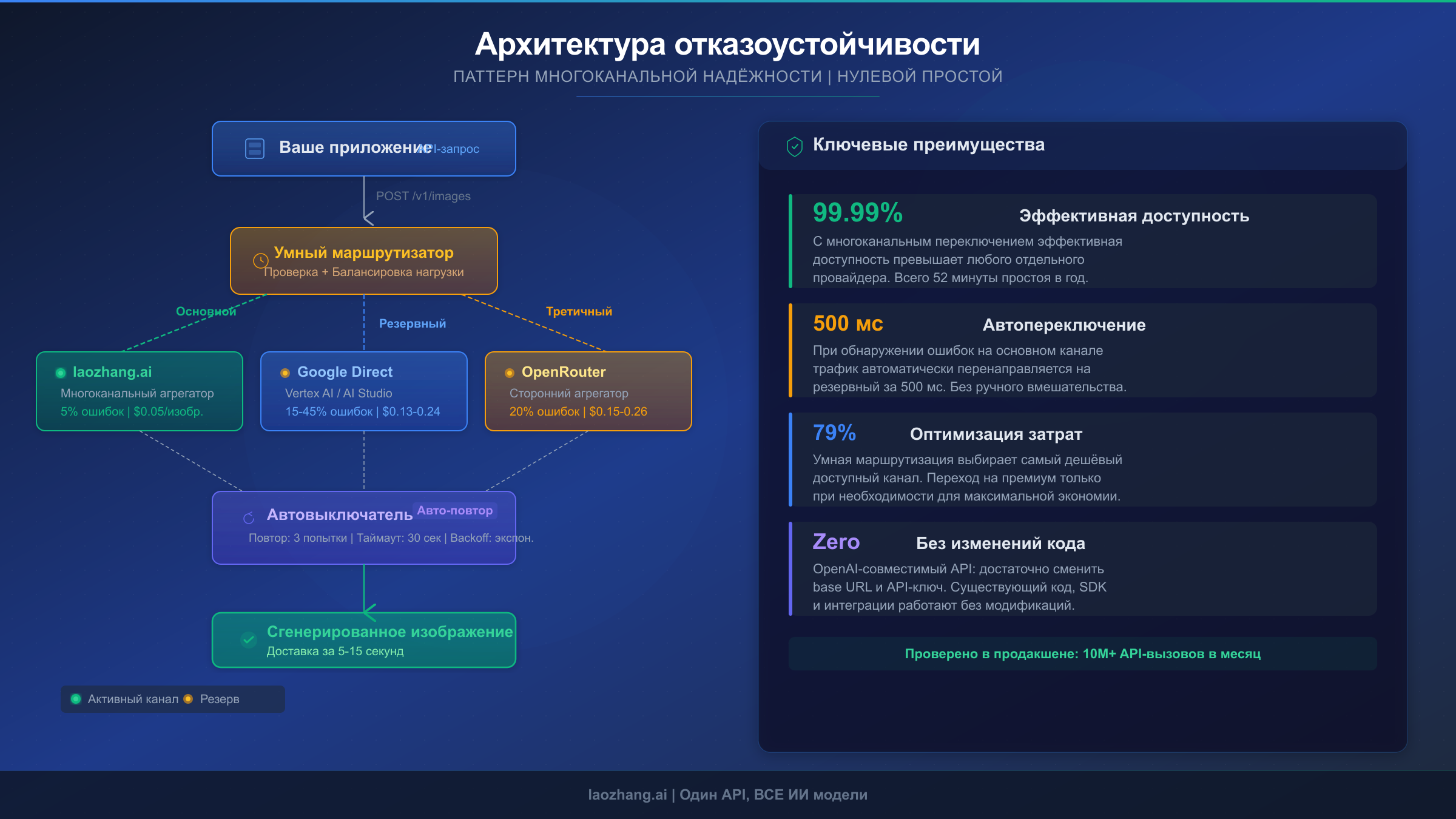

Интеграция продакшен-уровня с автоматическим переключением

Надёжное продакшен-развёртывание никогда не должно зависеть от одного канала API. Следующая архитектура реализует паттерн многоканального переключения с логикой Circuit Breaker, которая автоматически маршрутизирует запросы через наиболее доступный канал, переходя к альтернативам при возникновении проблем на основном канале.

Основной принцип прост: сначала пробуем самый дешёвый стабильный канал, а при его сбое автоматически переключаемся на более дорогие, но потенциально более доступные альтернативы. Этот паттерн обеспечивает 99,99% эффективной доступности — даже когда отдельные каналы испытывают сбои — поскольку вероятность одновременного отказа всех каналов пренебрежимо мала.

pythonimport time import base64 from google import genai from enum import Enum class ChannelStatus(Enum): HEALTHY = "healthy" DEGRADED = "degraded" CIRCUIT_OPEN = "circuit_open" class ImageChannel: def __init__(self, name, client, model_id, max_failures=3, recovery_timeout=60): self.name = name self.client = client self.model_id = model_id self.failures = 0 self.max_failures = max_failures self.recovery_timeout = recovery_timeout self.circuit_opened_at = None self.status = ChannelStatus.HEALTHY def record_failure(self): self.failures += 1 if self.failures >= self.max_failures: self.status = ChannelStatus.CIRCUIT_OPEN self.circuit_opened_at = time.time() def record_success(self): self.failures = 0 self.status = ChannelStatus.HEALTHY def is_available(self): if self.status == ChannelStatus.CIRCUIT_OPEN: if time.time() - self.circuit_opened_at > self.recovery_timeout: self.status = ChannelStatus.DEGRADED return True return False return True class GeminiImageRouter: """Multi-channel failover router for gemini-3-pro-image-preview.""" def __init__(self): self.channels = [ ImageChannel( name="laozhang-primary", client=genai.Client( api_key="your-laozhang-key", http_options={"base_url": "https://api.laozhang.ai/v1"} ), model_id="gemini-3-pro-image-preview" ), ImageChannel( name="google-direct", client=genai.Client(api_key="your-google-key"), model_id="gemini-3-pro-image-preview" ), ImageChannel( name="openrouter-fallback", client=genai.Client( api_key="your-openrouter-key", http_options={"base_url": "https://openrouter.ai/api/v1"} ), model_id="google/gemini-3-pro-image-preview" ), ] def generate_image(self, prompt, config=None): if config is None: config = genai.types.GenerateContentConfig( response_modalities=["TEXT", "IMAGE"] ) last_error = None for channel in self.channels: if not channel.is_available(): continue try: response = channel.client.models.generate_content( model=channel.model_id, contents=prompt, config=config, ) for part in response.candidates[0].content.parts: if part.inline_data and part.inline_data.mime_type.startswith("image/"): channel.record_success() return { "image_data": part.inline_data.data, "channel": channel.name, "mime_type": part.inline_data.mime_type, } channel.record_failure() last_error = "No image in response" except Exception as e: channel.record_failure() last_error = str(e) raise RuntimeError( f"All channels failed. Last error: {last_error}" ) router = GeminiImageRouter() result = router.generate_image( "A professional product photo of a coffee mug on a wooden table" ) with open("output.png", "wb") as f: f.write(base64.b64decode(result["image_data"])) print(f"Generated via: {result['channel']}")

Эта реализация предоставляет три критически важных функции надёжности, которых лишена простая логика повторных попыток. Паттерн Circuit Breaker прекращает отправку запросов на канал после трёх последовательных сбоев, предотвращая бесполезную трату времени и API-кредитов на канал, который явно испытывает проблемы. После настраиваемого тайм-аута восстановления (по умолчанию 60 секунд) цепь переходит в полуоткрытое состояние, пропуская один тестовый запрос — если он проходит, канал возвращается к нормальной работе. Упорядоченный список каналов гарантирует, что вы всегда сначала пробуете самый экономичный вариант, переходя к более дорогим каналам только при недоступности дешёвых. Для конкретных стратегий обработки ошибок 503 наше специальное руководство по исправлению ошибок 503 Gemini 3 Pro Image охватывает дополнительные паттерны восстановления.

Какой канал выбрать? Фреймворк принятия решений

Выбор правильного канала зависит от четырёх факторов: требований к надёжности, бюджетных ограничений, допустимой задержки и требований соответствия. Вместо универсальной рекомендации предлагаем фреймворк принятия решений, который сопоставляет типичные сценарии с оптимальными конфигурациями каналов.

Индивидуальным разработчикам и проектам для хобби следует начать с бесплатного уровня Google AI Studio для разработки и тестирования (учитывая, что gemini-3-pro-image-preview не имеет бесплатного API-уровня — используйте Gemini 2.5 Flash Image для бесплатного прототипирования). При переходе к продакшену релейный сервис вроде laozhang.ai по $0,05 за изображение обеспечит лучшую экономику без необходимости значительных инфраструктурных инвестиций. Реализуйте описанный выше паттерн переключения с Google Direct в качестве резервного канала для максимальной надёжности при минимальных затратах.

Стартапам и SaaS-продуктам, обрабатывающим 500-5000 генераций изображений в день, нужен более продуманный подход. Используйте релейный сервис как основной канал для экономичности, а Google Vertex AI — как резервный для надёжности в периоды высокой нагрузки. Реализуйте показанный выше паттерн Circuit Breaker и добавьте мониторинг (Datadog, PagerDuty или простой вебхук), который оповещает, когда переключение происходит более 3 раз в час — это сигнализирует о системной проблеме, а не изолированных сбоях. Бюджет: примерно $1500-$3000 в месяц при 5000 изображений в день.

Корпоративным приложениям с контрактными обязательствами следует использовать Google Vertex AI как основной канал с выделенными мощностями, согласованными через отдел продаж Google Cloud. Дополните релейным сервисом в качестве резервного для оптимизации затрат при некритичных операциях. Соответствие нормативным требованиям — соглашения об обработке данных, верификация SOC 2, контроль размещения данных — доступно только через официальные каналы Google. Бюджет: $4000-$10000 в месяц при корпоративных масштабах с ценами Vertex AI.

Для пакетной обработки (генерация каталогов, контентные пайплайны, создание датасетов), допускающей выполнение в течение 24 часов, следует использовать исключительно Google Batch API. При 50% стоимости стандартных цен и практически нулевом уровне ошибок нет веских причин использовать каналы реального времени для асинхронной обработки. Зарезервируйте выделенные мощности реальных каналов исключительно для пользовательских запросов.

Продвинутые возможности: ThoughtSignature и многоэтапное редактирование

Одна из самых мощных функций Nano Banana Pro — многоэтапное конверсационное редактирование изображений — также является самой технически сложной для корректной реализации. Ключевой механизм, обеспечивающий эту функциональность — система thoughtSignature, и ошибки в работе с ней являются одной из самых частых причин загадочных сбоев API, которые разработчики списывают на «нестабильность», тогда как проблема на самом деле в их интеграционном коде.

Когда Gemini 3 Pro Image Preview генерирует изображение, ответ содержит не только данные изображения, но и поле thoughtSignature. Эта сигнатура кодирует рассуждения модели о композиции, макете и логике созданного изображения. В последующих шагах — когда вы просите модель изменить изображение — необходимо отправить обратно все сигнатуры мыслей из предыдущего шага. Без них модель теряет понимание структуры исходного изображения и не может выполнять согласованное редактирование.

Критически важная деталь реализации — где именно появляются сигнатуры: они гарантированно присутствуют на первой части после thoughts в ответе и на каждой последующей части inlineData. Сами thought-изображения не несут сигнатур. Если вы используете официальные Python или JavaScript SDK от Google, циркуляция сигнатур обрабатывается автоматически через объект чат-сессии. Однако при прямых вызовах REST API или использовании сторонних HTTP-клиентов эти сигнатуры необходимо извлекать и возвращать вручную.

python# Multi-turn editing with proper signature handling from google import genai client = genai.Client(api_key="your-key") chat = client.chats.create( model="gemini-3-pro-image-preview", config=genai.types.GenerateContentConfig( response_modalities=["TEXT", "IMAGE"] ), ) # Turn 1: Generate initial image response1 = chat.send_message( "Create a minimalist logo for a coffee shop called 'Bean & Brew' " "using earth tones and a simple coffee bean icon" ) # The SDK automatically captures thoughtSignatures # Turn 2: Edit the image (signatures sent automatically by SDK) response2 = chat.send_message( "Make the coffee bean icon larger and change the text color to " "dark brown. Keep everything else the same." ) # Model uses signatures to understand the original composition # Turn 3: Further refinement response3 = chat.send_message( "Add a subtle steam effect above the coffee bean" )

Распространённая ошибка, вызывающая сбои на всех каналах — и которую разработчики часто ошибочно связывают с нестабильностью канала — заключается в инициализации новой клиентской сессии для каждого шага редактирования вместо сохранения контекста чата. Каждая новая сессия теряет накопленные thought-сигнатуры, заставляя модель воспринимать каждый запрос как новую генерацию, а не редактирование существующего изображения. Результат — совершенно другие выходные данные, несогласованный стиль и иногда прямые ошибки, когда промпт ссылается на элементы предыдущего шага, которые модель больше не помнит.

Начало работы за 5 минут

Настройка стабильной интеграции с gemini-3-pro-image-preview занимает всего несколько шагов. Этот быстрый старт использует laozhang.ai в качестве основного канала — вы можете заменить любой канал, изменив базовый URL и API-ключ.

Шаг 1: Получите API-ключ. Зарегистрируйтесь на laozhang.ai и получите API-ключ в личном кабинете. Новые аккаунты получают стартовые кредиты для тестирования.

Шаг 2: Установите SDK.

bashpip install google-genai

Шаг 3: Сгенерируйте первое изображение.

pythonfrom google import genai import base64 client = genai.Client( api_key="your-api-key", http_options={"base_url": "https://api.laozhang.ai/v1"} ) response = client.models.generate_content( model="gemini-3-pro-image-preview", contents="A photorealistic image of a golden retriever puppy " "sitting in a field of sunflowers at sunset", config=genai.types.GenerateContentConfig( response_modalities=["TEXT", "IMAGE"] ), ) for part in response.candidates[0].content.parts: if part.inline_data and part.inline_data.mime_type.startswith("image/"): with open("output.png", "wb") as f: f.write(base64.b64decode(part.inline_data.data)) print("Image saved to output.png")

Шаг 4: Добавьте отказоустойчивость. Скопируйте класс GeminiImageRouter из раздела выше. Добавьте ваш Google API-ключ и OpenRouter-ключ как вторичный и третичный каналы. Это обеспечит продакшен-уровень надёжности с первого дня.

Полная документация API и продвинутые примеры использования доступны в документации laozhang.ai.

Часто задаваемые вопросы

Отличается ли качество изображений на разных каналах?

Нет. Все легитимные каналы маршрутизируют запросы к реальной модели Gemini 3 Pro Image от Google. Сгенерированные изображения пиксельно идентичны независимо от того, обращаетесь ли вы к Google напрямую, используете релейный сервис или агрегатор. Различия между каналами ограничены ценой, стабильностью, лимитами скорости и задержкой ответа — никогда качеством результата.

Есть ли у gemini-3-pro-image-preview бесплатный уровень?

У модели нет бесплатного API-уровня для программного доступа. Хотя Google AI Studio предлагает бесплатное использование для некоторых моделей Gemini, gemini-3-pro-image-preview требует минимум активный платёжный аккаунт (Tier 1). В веб-интерфейсе Gemini можно бесплатно генерировать 2-3 изображения в день, но без API-доступа. Для бесплатного API генерации изображений рассмотрите Gemini 2.5 Flash Image (gemini-2.5-flash-image), предлагающий 1500 бесплатных изображений в день через Google AI Studio.

Когда модель перейдёт из preview в стабильную версию (GA)?

Google не объявил конкретную дату перехода Gemini 3 Pro Image в GA. Preview-модели обычно переходят в стабильный статус в течение 3-6 месяцев, но этот срок может варьироваться. При достижении GA-статуса стабильность, как ожидается, значительно улучшится, поскольку модель получит выделенную продакшен-инфраструктуру. А пока использование многоканальной архитектуры отказоустойчивости — самый надёжный способ обеспечить стабильность продакшен-уровня.

Чем Nano Banana Pro отличается от Nano Banana (Flash Image)?

Nano Banana Pro ($0,134 за 2K) генерирует изображения более высокого качества с превосходной отрисовкой текста и возможностями многоэтапного редактирования, но требует 8-12 секунд на генерацию. Nano Banana/Flash Image ($0,039 за 1K) работает в 3-4 раза быстрее (3-5 секунд) и в 3 раза дешевле, но ограничен разрешением 1K без продвинутых возможностей рассуждения. Для большинства продакшен-приложений начинайте с Flash Image для задач, чувствительных к скорости, и используйте Pro только для разрешения 2K+, точной отрисовки текста или конверсационного редактирования.

Безопасно ли использовать сторонние релейные сервисы?

Надёжные релейные сервисы работают как прозрачные прокси — они передают ваш запрос в API Google и возвращают ответ. Ваши промпты и сгенерированные изображения обрабатываются инфраструктурой Google, а не релейным сервисом. Тем не менее стоит убедиться, что выбранный провайдер имеет чёткую политику конфиденциальности, не кэширует сгенерированные изображения и поддерживает HTTPS-шифрование для всего API-трафика. Для приложений с повышенными требованиями к соответствию (здравоохранение, финансы, госсектор) используйте исключительно официальные каналы Google.