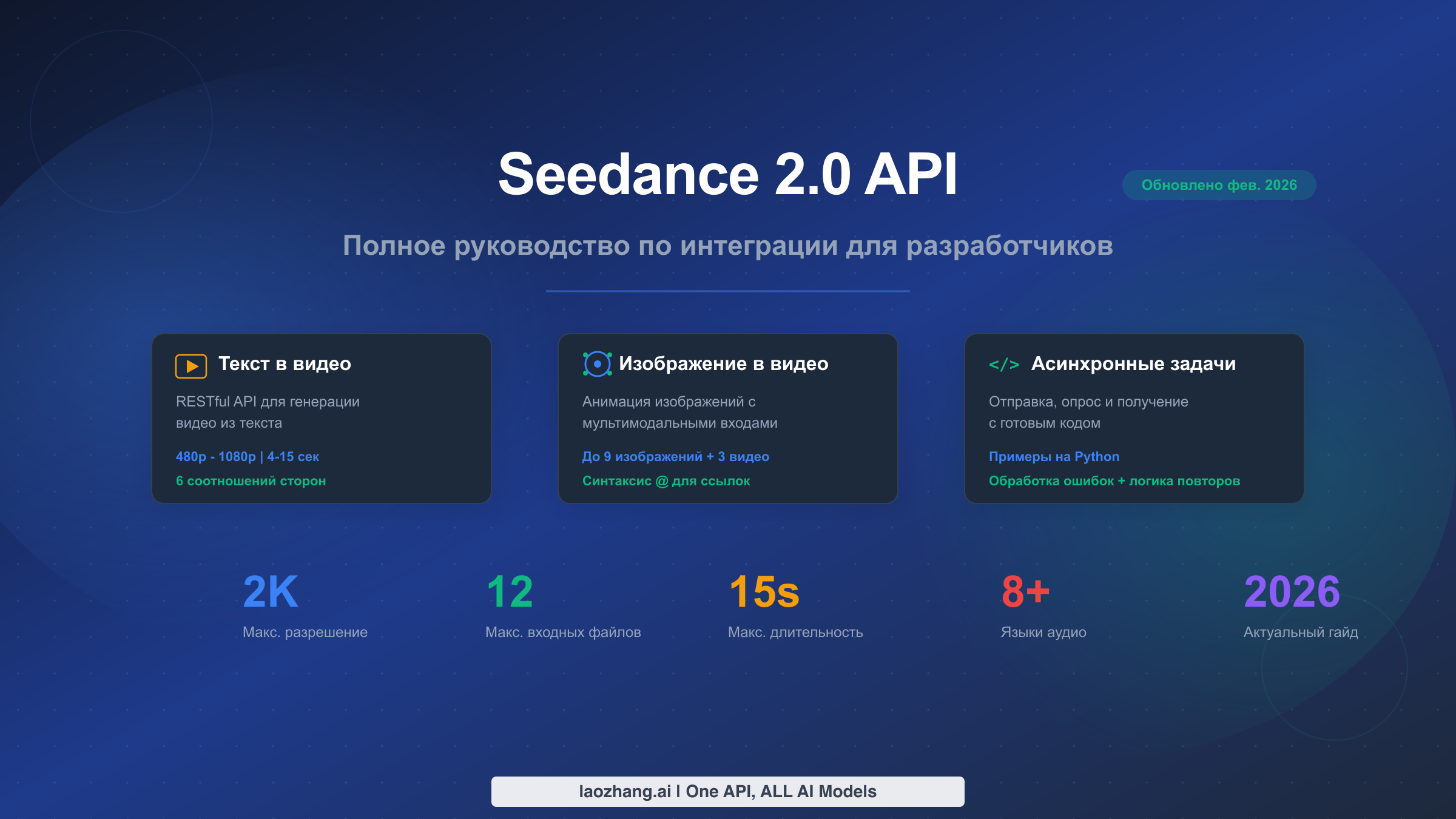

Seedance 2.0 от ByteDance представляет собой значительный прорыв в области генерации видео с помощью ИИ. Модель поддерживает сценарии текст-в-видео и изображение-в-видео с разрешением до 2K, длительностью от 4 до 15 секунд и уникальной мультимодальной системой ввода, способной одновременно принимать до 12 референсных файлов. По состоянию на 12 февраля 2026 года официальный REST API ещё не был публично выпущен ByteDance, однако разработчики уже могут получить доступ к возможностям Seedance 2.0 через сторонние API-платформы. В этом руководстве представлено всё, что необходимо для интеграции Seedance 2.0 в ваши приложения: спецификации эндпоинтов, этапы аутентификации, готовый к продакшену Python-код с обработкой ошибок, документация по лимитам и кросс-платформенное сравнение цен с Sora 2, Runway Gen-4 и Kling 3.0.

Краткое содержание

Seedance 2.0 предлагает генерацию ИИ-видео через асинхронные RESTful-эндпоинты для текст-в-видео и изображение-в-видео. Ожидается, что официальный API от ByteDance появится около 24 февраля 2026 года. До этого момента сторонние платформы, такие как laozhang.ai, предоставляют OpenAI-совместимый доступ. Ключевые характеристики: разрешение 480p-2K, клипы от 4 до 15 секунд, мультимодальный ввод 12 файлов, встроенный звук с синхронизацией губ на 8+ языках. Ориентировочные цены варьируются от $0,10/мин (Basic 720p) до $0,80/мин (Cinema 2K), что потенциально в 10-100 раз дешевле Sora 2 за один клип.

Что такое Seedance 2.0 API и доступен ли он?

Seedance 2.0 — это новейшая модель генерации видео от ByteDance, официально анонсированная 10 февраля 2026 года. Построенная на основе предшественников (Seedance 1.0 и 1.5 Pro), эта модель второго поколения вносит кардинальные улучшения в качество видео, когерентность движений и возможности мультимодального ввода. Модель лежит в основе потребительской платформы Jimeng (Цзимэн) и предназначена как для профессионалов в области создания контента, так и для разработчиков, встраивающих функции генерации видео в свои приложения.

Самое важное, что разработчикам необходимо понимать прямо сейчас, — это различие между возможностями модели и доступностью её API. На официальной странице моделей ByteDance по адресу seed.bytedance.com в настоящее время перечислены только Seedance 1.0 и 1.5 Pro — Seedance 2.0 там ещё не отображается (проверено через Browser MCP 12 февраля 2026 года). Ожидается, что официальный REST API будет запущен через Volcengine (Volcano Ark), облачную платформу ByteDance, примерно 24 февраля 2026 года. Это означает, что между анонсом модели и доступностью официального API существует приблизительно двухнедельный разрыв.

Несмотря на этот разрыв, разработчики не остаются без вариантов. Несколько сторонних платформ-агрегаторов API уже начали предлагать доступ к Seedance 2.0 через собственные эндпоинты. Такие платформы обычно оборачивают возможности базовой модели в OpenAI-совместимые интерфейсы, что означает минимальные изменения в коде интеграции при последующем переходе на официальный API. На данный момент доступны три основных пути получения доступа: прямые сторонние агрегаторы, имеющие партнёрские соглашения с ByteDance, унифицированные API-платформы вроде laozhang.ai, предоставляющие единый эндпоинт для нескольких моделей генерации ИИ-видео, и веб-интерфейс Jimeng для ручного тестирования и прототипирования перед переходом к API-интеграции.

Понимание этого графика критически важно для планирования вашего плана разработки. Если вы создаёте продуктовую функцию, которую необходимо запустить в феврале 2026 года, доступ через сторонние платформы — ваш лучший вариант. Если ваши сроки продлеваются до марта, возможно, стоит дождаться официального API с его гарантированной стабильностью, обязательствами по SLA и прямой поддержкой от ByteDance. В любом случае паттерны эндпоинтов, задокументированные в этом руководстве, следуют де-факто стандарту, сформировавшемуся на различных платформах, поэтому ваши инвестиции в код сохранят свою ценность независимо от выбранного пути.

Эндпоинты и параметры Seedance 2.0 API

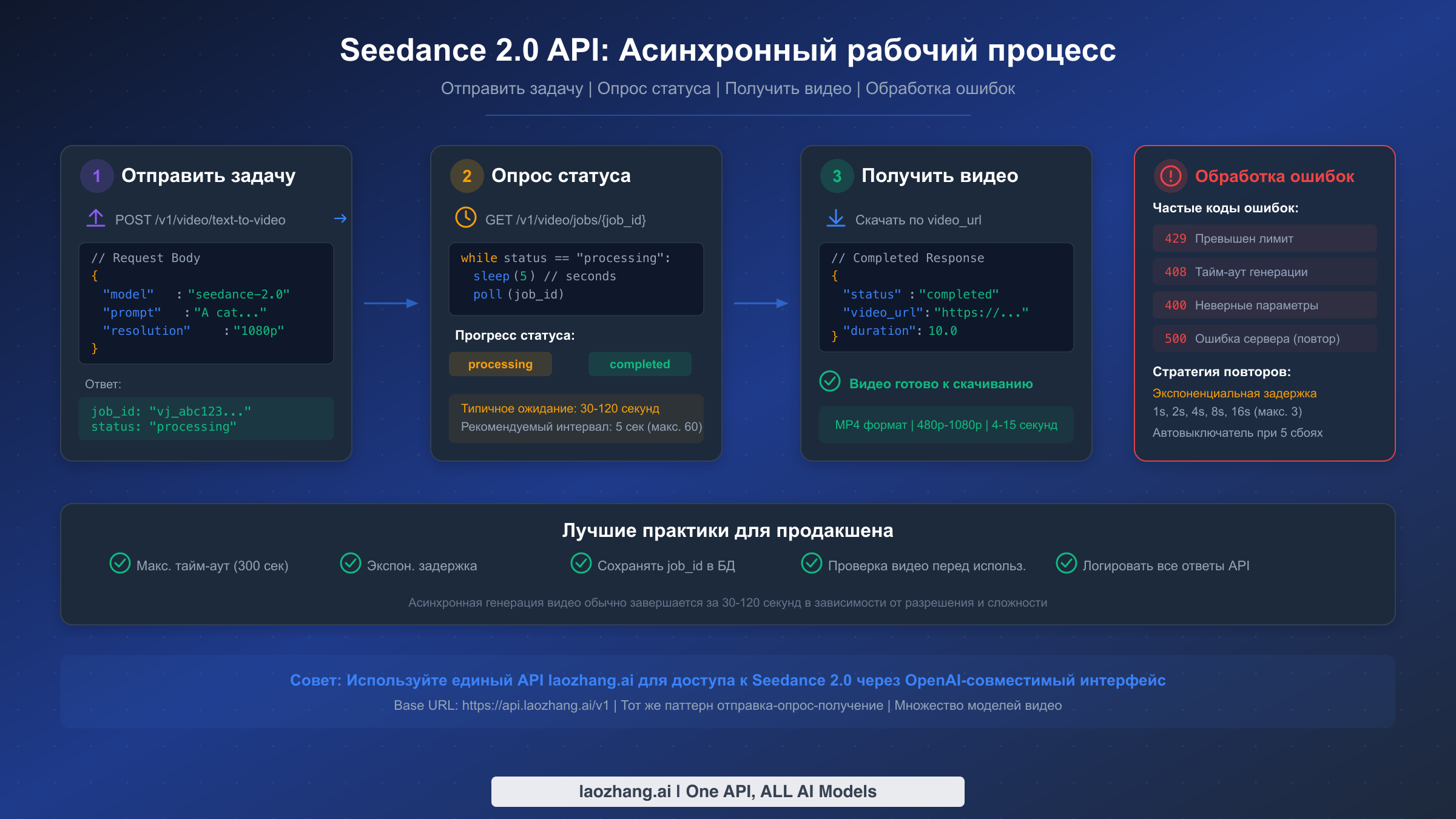

Seedance 2.0 следует асинхронной архитектуре на основе задач (job-based), которая является общепринятой среди API генерации ИИ-видео. В отличие от генерации текста или изображений, которые могут возвращать результаты за секунды, генерация видео требует значительного вычислительного времени — обычно от 30 до 120 секунд в зависимости от разрешения и длительности. Это означает, что каждая интеграция должна реализовывать трёхфазный рабочий процесс: отправить запрос на генерацию, опрашивать статус выполнения задачи и получить готовый видеофайл. Глубокое понимание этих эндпоинтов и их параметров необходимо для построения надёжной интеграции.

Эндпоинт текст-в-видео

Основной эндпоинт для генерации видео из текстовых промптов следует REST-паттерну, знакомому любому, кто работал с OpenAI или аналогичными API. Вы отправляете POST-запрос с промптом и параметрами конфигурации, а сервер возвращает идентификатор задачи, с помощью которого вы отслеживаете прогресс.

Эндпоинт принимает следующие ключевые параметры. Поле model указывает seedance-2.0 в качестве целевой модели. Поле prompt содержит текстовое описание желаемого видео, причём более длинные и детализированные промпты, как правило, дают лучшие результаты. Параметр resolution управляет качеством выходного видео с вариантами от 480p через 720p и 1080p до 2K (уровень Cinema). Параметр duration принимает значения от 4 до 15 секунд, при этом более длительные видео стоят пропорционально дороже. Наконец, поле aspect_ratio поддерживает шесть вариантов: 16:9, 9:16, 4:3, 3:4, 21:9 и 1:1, что охватывает все форматы от горизонтального видео до вертикального контента для социальных сетей и сверхширокого кинематографического формата.

| Параметр | Тип | Обязательный | Значения | Описание |

|---|---|---|---|---|

| model | string | Да | seedance-2.0 | Идентификатор целевой модели |

| prompt | string | Да | До 2000 символов | Текстовое описание видео |

| resolution | string | Нет | 480p, 720p, 1080p, 2K | Качество выходного видео |

| duration | integer | Нет | 4-15 | Длительность видео в секундах |

| aspect_ratio | string | Нет | 16:9, 9:16, 4:3, 3:4, 21:9, 1:1 | Пропорции кадра |

Эндпоинт изображение-в-видео

Эндпоинт изображение-в-видео расширяет рабочий процесс текст-в-видео, принимая референсные изображения, видео и аудиофайлы наряду с текстовым промптом. Именно здесь Seedance 2.0 по-настоящему выделяется на фоне конкурентов. Используя синтаксис ссылок @, вы можете включить до 9 изображений, 3 видео и 3 аудиофайлов в один запрос на генерацию. Модель использует эти ссылки для управления движением, стилем, консистентностью персонажей и аудиосинхронизацией в выходном видео.

Синтаксис @ работает непосредственно внутри поля промпта. Например, промпт вида @image1 The person in this photo starts walking towards the camera, @audio1 указывает модели анимировать референсное изображение с синхронизацией под указанную аудиодорожку. Эта мультимодальная возможность особенно полезна для создания видео с консистентными персонажами, демонстраций продуктов и повествовательного контента, где важна визуальная непрерывность.

Эндпоинт статуса и получения результатов

После отправки запроса на генерацию вы получаете идентификатор задачи и должны опрашивать эндпоинт статуса для отслеживания прогресса. GET-эндпоинт возвращает текущий статус вместе с процентом выполнения, оценкой оставшегося времени и — по завершении — URL для скачивания готового видео. Типичная последовательность статусов проходит через queued, processing и завершается completed или failed. Правильно реализованная стратегия опроса использует 5-секундные интервалы с максимальным тайм-аутом в 300 секунд в сочетании с экспоненциальной задержкой при ошибках, чтобы не перегружать API в периоды высокой нагрузки.

Как получить API-ключ Seedance 2.0 (3 способа)

Для начала работы с Seedance 2.0 API необходим API-ключ, однако способ его получения зависит от того, когда вы читаете это руководство и насколько быстро вам нужен доступ. По состоянию на февраль 2026 года существуют три различных подхода, каждый со своими компромиссами между скоростью, стоимостью и долгосрочной стабильностью. Правильный выбор сейчас сэкономит вам значительные усилия по рефакторингу в дальнейшем, поэтому стоит разобраться в последствиях каждого варианта, прежде чем писать первую строку кода.

Способ 1: Официальный API ByteDance (скоро)

Самый прямой вариант — как только он станет доступен — регистрация непосредственно через Volcengine (volcano.com), облачную вычислительную платформу ByteDance. Судя по паттерну, установленному при выпуске предыдущих моделей Seedance, официальный API обычно запускается через 10-14 дней после анонса модели, что указывает на ожидаемую дату доступности около 24 февраля 2026 года. Процесс регистрации, вероятно, будет включать создание аккаунта Volcengine, прохождение верификации разработчика, генерацию API-ключа в консоли и подключение к соответствующему тарифному плану. Официальный API обеспечит лучшие гарантии по времени безотказной работы, лимитам и прямой поддержке, что делает его рекомендуемым выбором для продуктовых нагрузок, которые могут подождать до даты запуска.

Способ 2: Сторонние агрегаторы API (доступно сейчас)

Для разработчиков, которым нужен немедленный доступ, несколько сторонних платформ уже предоставляют эндпоинты Seedance 2.0. Эти агрегаторы поддерживают собственную инфраструктуру и системы биллинга, обеспечивая при этом доступ к базовой модели. Ключевое преимущество — немедленная доступность, однако компромисс заключается в том, что ценообразование, лимиты и надёжность варьируются между провайдерами. При оценке агрегаторов обратите особое внимание на наличие OpenAI-совместимого интерфейса, поскольку это значительно снижает трудоёмкость миграции при последующем переходе на официальный API. Большинство авторитетных агрегаторов предоставляют чёткую документацию, прозрачное ценообразование и обоснованные гарантии доступности.

Способ 3: Унифицированные API-платформы (рекомендуется для мультимодельного использования)

Если вашему приложению нужен доступ к нескольким моделям генерации видео — не только Seedance 2.0, но и Sora 2, Veo 3.1 и другим — унифицированная API-платформа предлагает наиболее эффективный подход. Платформы вроде laozhang.ai предоставляют единый API-ключ, единый базовый URL (https://api.laozhang.ai/v1 ) и единообразный интерфейс для всех поддерживаемых моделей. Это означает, что для переключения между Seedance 2.0 и Sora 2 достаточно изменить параметр model в запросе без необходимости переписывать код интеграции. Практические преимущества существенны: один биллинговый аккаунт, один набор учётных данных для управления и один паттерн обработки ошибок, работающий со всеми моделями. Для разработчиков, создающих функции генерации видео с возможностью переключения на альтернативные модели при сбоях, такой подход обеспечивает наиболее отказоустойчивую архитектуру. Полная документация по API доступна на docs.laozhang.ai.

Независимо от выбранного способа, паттерн аутентификации через API-ключ остаётся единым для всех платформ. Вы включаете ключ в заголовок Authorization как Bearer-токен: Authorization: Bearer your_api_key_here. Все последующие примеры кода в этом руководстве используют этот стандартный паттерн, поэтому они будут работать с любым из трёх способов доступа — достаточно подставить соответствующий базовый URL и API-ключ.

Лимиты, квоты и разбор цен

Лимиты и ценообразование относятся к наименее документированным аспектам API для генерации ИИ-видео, и Seedance 2.0 не исключение. Поскольку официальный API ещё не запущен, доступная информация о лимитах поступает от сторонних платформ и экстраполяции с предыдущих тарифов модели Seedance. В этом разделе собраны лучшие доступные данные, чтобы вы могли спланировать ёмкость и бюджет с разумной уверенностью, при этом мы чётко указываем, что подтверждено, а что является оценкой.

Основываясь на паттернах существующих сторонних платформ и задокументированных ограничениях ByteDance для Seedance 1.5 Pro, разработчикам следует рассчитывать примерно на 10-20 параллельных запросов на генерацию на один API-ключ, при этом допустимая частота отправки в минуту варьируется в зависимости от тарифного плана. Типичная глубина очереди до срабатывания лимита составляет 50-100 ожидающих задач. При превышении лимита API возвращает HTTP 429 с заголовком Retry-After, указывающим количество секунд ожидания. Рекомендуемый подход — экспоненциальная задержка начиная с 1 секунды, с удвоением до максимума в 16 секунд и размыкателем цепи (circuit breaker), прекращающим повторные попытки после 5 последовательных отказов.

Тарифные планы (ориентировочно)

Ценовая структура Seedance 2.0 построена по тарифной модели на основе разрешения и длительности. Эти цены собраны из нескольких сторонних источников (nxcode.io, seedanceapi.org, обзорные статьи SERP) по состоянию на февраль 2026 года и должны рассматриваться как ориентировочные до публикации официальных цен ByteDance.

| Тариф | Разрешение | Ориент. стоимость за минуту | Оптимально для |

|---|---|---|---|

| Basic | 720p | ~$0,10/мин | Прототипирование, черновики для соцсетей |

| Pro | 1080p | ~$0,30/мин | Продуктовый контент, маркетинговые видео |

| Cinema | 2K | ~$0,80/мин | Высокобюджетные продакшены, коммерческое использование |

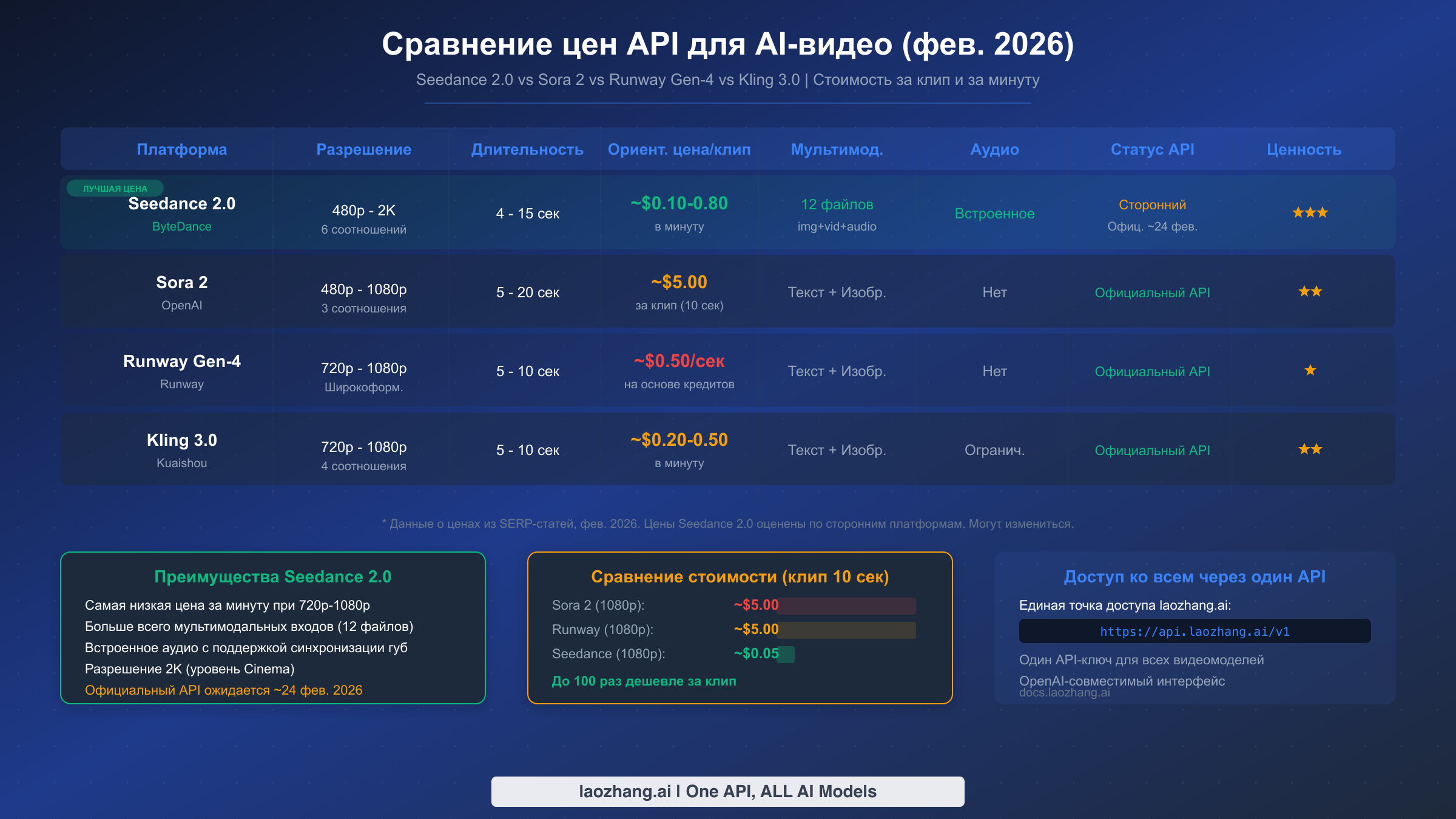

Кросс-платформенное сравнение цен

Чтобы понять ценообразование Seedance 2.0 в контексте, ниже представлено сравнение с тремя наиболее популярными альтернативами для разработчиков, создающих функции ИИ-видео. Сравнение демонстрирует заметное преимущество в стоимости, делающее Seedance 2.0 особенно привлекательным для сценариев с большими объёмами генерации.

| Платформа | Разрешение | Длительность | Ориент. цена за клип | Цена за минуту | Мультимодальный ввод |

|---|---|---|---|---|---|

| Seedance 2.0 (Pro) | 1080p | 10 сек | ~$0,05 | ~$0,30/мин | 12 файлов (изобр.+видео+аудио) |

| Sora 2 (Official) | 1080p | 10 сек | ~$5,00 | ~$30/мин | Текст + Изображение |

| Runway Gen-4 | 1080p | 10 сек | ~$5,00 | ~$30/мин | Текст + Изображение |

| Kling 3.0 | 1080p | 10 сек | ~$0,08 | ~$0,50/мин | Текст + Изображение |

Разница в стоимости впечатляет. На тарифе Pro Seedance 2.0 примерно в 100 раз дешевле за клип по сравнению с Sora 2 при сопоставимом разрешении и длительности. Даже с учётом того, что это ориентировочные цены, разница на порядок величины указывает на то, что Seedance 2.0 будет чрезвычайно конкурентоспособен по цене, что, вероятно, обусловлено стратегией ByteDance по быстрому завоеванию доли рынка среди разработчиков. Для приложений, генерирующих сотни или тысячи видео в месяц, эта разница в ценах выражается в экономии тысяч долларов.

Для разработчиков, которым нужен доступ к нескольким моделям видео, стоит рассмотреть подход с использованием унифицированной платформы. Через laozhang.ai вы можете получить доступ к Sora 2 от $0,15 за запрос на базовом тарифе и к Veo 3.1 от $0,15 за запрос — оба с асинхронными API, где неуспешные генерации не тарифицируются, что является значительным преимуществом для продуктовых нагрузок. Это означает, что вы можете сравнивать Seedance 2.0 с Sora 2 и Veo 3.1, используя одну и ту же кодовую базу, один API-ключ и один биллинговый аккаунт, что упрощает бенчмаркинг качества и стоимости между моделями до принятия окончательного решения. Подробности доступны на docs.laozhang.ai.

Полный Python-код интеграции

В этом разделе представлен готовый к продакшену Python-код, который вы можете адаптировать для своих приложений. В отличие от концептуальных примеров, встречающихся в большинстве статей о Seedance 2.0, этот код включает полноценную обработку ошибок, логику повторных попыток с экспоненциальной задержкой, управление тайм-аутами и асинхронный опрос — все элементы, необходимые для надёжного развёртывания в продакшене. Каждая функция спроектирована для работы с любым OpenAI-совместимым эндпоинтом, поэтому вы можете использовать этот код с официальным API, сторонними агрегаторами или унифицированными платформами, просто изменив базовый URL и API-ключ.

Генерация текст-в-видео

Следующая реализация охватывает полный рабочий процесс текст-в-видео. Класс SeedanceClient инкапсулирует аутентификацию, отправку запросов, опрос статуса и загрузку видео в удобный интерфейс, корректно обрабатывающий крайние случаи.

pythonimport requests import time import logging from typing import Optional, Dict, Any logging.basicConfig(level=logging.INFO) logger = logging.getLogger("seedance") class SeedanceClient: """Production-ready Seedance 2.0 API client with retry logic.""" def __init__(self, api_key: str, base_url: str = "https://api.laozhang.ai/v1" ): self.api_key = api_key self.base_url = base_url.rstrip("/") self.headers = { "Authorization": f"Bearer {api_key}", "Content-Type": "application/json" } self.max_retries = 3 self.poll_interval = 5 # seconds self.max_poll_time = 300 # 5 minutes def _request_with_retry(self, method: str, url: str, **kwargs) -> requests.Response: """Execute HTTP request with exponential backoff retry.""" for attempt in range(self.max_retries): try: response = requests.request(method, url, headers=self.headers, timeout=30, **kwargs) if response.status_code == 429: retry_after = int(response.headers.get("Retry-After", 2 ** attempt)) logger.warning(f"Rate limited. Retrying in {retry_after}s...") time.sleep(retry_after) continue response.raise_for_status() return response except requests.exceptions.RequestException as e: wait_time = 2 ** attempt logger.error(f"Request failed (attempt {attempt + 1}): {e}") if attempt < self.max_retries - 1: time.sleep(wait_time) else: raise raise RuntimeError("Max retries exceeded") def text_to_video( self, prompt: str, resolution: str = "1080p", duration: int = 10, aspect_ratio: str = "16:9" ) -> Dict[str, Any]: """Submit a text-to-video generation job.""" payload = { "model": "seedance-2.0", "prompt": prompt, "resolution": resolution, "duration": duration, "aspect_ratio": aspect_ratio } response = self._request_with_retry( "POST", f"{self.base_url}/video/text-to-video", json=payload ) result = response.json() logger.info(f"Job submitted: {result.get('job_id', 'unknown')}") return result def poll_job(self, job_id: str) -> Dict[str, Any]: """Poll job status until completion or timeout.""" start_time = time.time() while time.time() - start_time < self.max_poll_time: response = self._request_with_retry( "GET", f"{self.base_url}/video/jobs/{job_id}" ) status_data = response.json() status = status_data.get("status", "unknown") progress = status_data.get("progress", 0) logger.info(f"Job {job_id}: {status} ({progress}%)") if status == "completed": return status_data elif status == "failed": error_msg = status_data.get("error", "Unknown error") raise RuntimeError(f"Generation failed: {error_msg}") time.sleep(self.poll_interval) raise TimeoutError(f"Job {job_id} timed out after {self.max_poll_time}s") def download_video(self, video_url: str, output_path: str = "output.mp4") -> str: """Download the generated video file.""" response = requests.get(video_url, stream=True, timeout=60) response.raise_for_status() with open(output_path, "wb") as f: for chunk in response.iter_content(chunk_size=8192): f.write(chunk) logger.info(f"Video saved to {output_path}") return output_path def generate_video( self, prompt: str, output_path: str = "output.mp4", **kwargs ) -> str: """End-to-end: submit, poll, and download in one call.""" job = self.text_to_video(prompt, **kwargs) job_id = job["job_id"] result = self.poll_job(job_id) video_url = result["video_url"] return self.download_video(video_url, output_path) if __name__ == "__main__": client = SeedanceClient( api_key="your_api_key_here", base_url="https://api.laozhang.ai/v1" # or official URL when available ) try: path = client.generate_video( prompt="A serene mountain lake at sunrise with mist rising from the water, " "drone shot slowly revealing the surrounding forest, cinematic quality", resolution="1080p", duration=10, aspect_ratio="16:9" ) print(f"Video generated: {path}") except TimeoutError: print("Generation timed out - try again or reduce resolution") except RuntimeError as e: print(f"Generation failed: {e}")

Генерация изображение-в-видео с мультимодальными ссылками

Рабочий процесс изображение-в-видео расширяет базовый клиент для обработки загрузки файлов наряду с текстовыми промптами. Эта реализация демонстрирует синтаксис ссылок @, который делает мультимодальную систему ввода Seedance 2.0 особенно мощной для создания видео с консистентными персонажами и переноса стиля.

pythonimport base64 from pathlib import Path def image_to_video( client: SeedanceClient, prompt: str, image_paths: list, output_path: str = "i2v_output.mp4", resolution: str = "1080p", duration: int = 8 ) -> str: """Generate video from images using Seedance 2.0 multimodal input.""" # Encode images as base64 encoded_images = [] for img_path in image_paths: with open(img_path, "rb") as f: img_data = base64.b64encode(f.read()).decode("utf-8") ext = Path(img_path).suffix.lstrip(".") encoded_images.append({ "type": f"image/{ext}", "data": img_data }) # Build multimodal payload payload = { "model": "seedance-2.0", "prompt": prompt, "resolution": resolution, "duration": duration, "references": encoded_images } response = client._request_with_retry( "POST", f"{client.base_url}/video/image-to-video", json=payload ) job = response.json() result = client.poll_job(job["job_id"]) return client.download_video(result["video_url"], output_path) # Usage example if __name__ == "__main__": client = SeedanceClient(api_key="your_key", base_url="https://api.laozhang.ai/v1" ) video = image_to_video( client, prompt="@image1 The person begins walking toward the camera with a confident stride, " "camera slowly zooms in, natural lighting", image_paths=["reference_photo.jpg"], resolution="1080p", duration=8 ) print(f"Image-to-video complete: {video}")

Пакетная обработка с контролем параллелизма

Для продуктовых нагрузок, требующих генерации нескольких видео, следующая реализация добавляет контроль параллелизма с помощью модуля Python concurrent.futures. Это критически важно для соблюдения лимитов при максимизации пропускной способности.

pythonfrom concurrent.futures import ThreadPoolExecutor, as_completed def batch_generate( client: SeedanceClient, prompts: list, max_workers: int = 3, output_dir: str = "./videos" ) -> list: """Generate multiple videos with controlled concurrency.""" Path(output_dir).mkdir(parents=True, exist_ok=True) results = [] with ThreadPoolExecutor(max_workers=max_workers) as executor: future_to_prompt = {} for i, prompt in enumerate(prompts): output_path = f"{output_dir}/video_{i:03d}.mp4" future = executor.submit( client.generate_video, prompt, output_path ) future_to_prompt[future] = (i, prompt) for future in as_completed(future_to_prompt): idx, prompt = future_to_prompt[future] try: path = future.result() results.append({"index": idx, "path": path, "status": "success"}) logger.info(f"Batch [{idx}] completed: {path}") except Exception as e: results.append({"index": idx, "error": str(e), "status": "failed"}) logger.error(f"Batch [{idx}] failed: {e}") return sorted(results, key=lambda x: x["index"])

Весь приведённый выше код разработан для работы с любым OpenAI-совместимым эндпоинтом. Для переключения между провайдерами достаточно изменить параметр base_url — никаких других изменений в коде не требуется. Это позволяет без труда тестировать на сторонних платформах сейчас и мигрировать на официальный API после его запуска.

Устранение типичных проблем с API

Работа с API для генерации ИИ-видео порождает категорию ошибок, с которыми API для текста и изображений сталкиваются крайне редко. Генерация видео требует значительных вычислительных ресурсов, занимает продолжительное время и чувствительна к содержанию промптов, требованиям к разрешению и серверной нагрузке — всё это создаёт режимы отказа, требующие специфических стратегий обработки. В этом разделе задокументированы наиболее распространённые проблемы, с которыми сталкиваются разработчики при интеграции Seedance 2.0, и проверенные решения для каждой из них.

Наиболее частая ошибка, с которой сталкиваются разработчики, — HTTP 429 (Too Many Requests), указывающая на превышение лимита запросов платформы. Обычно это происходит при быстрой последовательной отправке нескольких запросов на генерацию или при слишком агрессивном опросе статуса. Правильная реакция — реализовать экспоненциальную задержку: подождать 1 секунду после первого 429, затем 2 секунды, затем 4 и так далее до максимума в 16 секунд. Если вы получаете 5 последовательных ответов 429, полностью прекратите повторные попытки и подождите не менее 60 секунд перед отправкой новых запросов. Код пакетной обработки в предыдущем разделе уже реализует этот паттерн через метод _request_with_retry.

Ошибки тайм-аута (HTTP 408 или клиентские тайм-ауты) — вторая по распространённости проблема, требующая иной стратегии. Генерация видео объективно занимает 30-120 секунд, поэтому слишком низкий тайм-аут HTTP-клиента приведёт к ложным отказам. Установите тайм-аут отправки запроса на 30 секунд (для начального POST) и общий тайм-аут опроса на 300 секунд. Если задача не завершилась за 300 секунд, скорее всего, она зависла — отмените её и отправьте повторно с пониженным разрешением или меньшей длительностью для снижения вычислительных требований.

| Код ошибки | Причина | Решение |

|---|---|---|

| 429 | Превышение лимита запросов | Экспоненциальная задержка (1 с, 2 с, 4 с, 8 с, 16 с), размыкатель цепи после 5 отказов |

| 408 | Тайм-аут генерации | Повторная отправка с пониженным разрешением; проверка сложности промпта |

| 400 | Некорректные параметры | Проверка соответствия значений resolution, duration, aspect_ratio спецификации API |

| 401 | Ошибка аутентификации | Проверка валидности API-ключа; подтверждение наличия прав на генерацию видео |

| 413 | Слишком большой payload | Уменьшение числа референсных файлов или сжатие изображений перед загрузкой |

| 500 | Ошибка сервера | Повторная попытка до 3 раз; при сохранении проблемы — обращение в поддержку платформы |

| 503 | Сервис недоступен | Высокая серверная нагрузка; ожидание 30-60 секунд и повторная попытка |

Нарушения политики контента представляют собой категорию ошибок, уникальную для API генеративного ИИ. Когда система безопасности модели отклоняет промпт, вы обычно получаете ответ 400 с конкретным сообщением об ошибке, указывающим на нарушение политики. Такие ошибки не следует повторять с тем же промптом — вместо этого переработайте промпт в соответствии с правилами платформы по контенту. При использовании платформ вроде laozhang.ai, предлагающих политику «без оплаты за неудачи», нарушения контент-политики не влекут за собой расходов, что является существенным преимуществом для приложений, где промпты от пользователей могут периодически активировать фильтры безопасности.

Менее очевидная, но не менее важная проблема — истечение срока действия URL видео до момента его загрузки. Большинство платформ хранят сгенерированные видео в течение 24 часов, после чего URL становится недействительным. Ваше приложение должно загружать и сохранять видео немедленно после завершения генерации, а не хранить URL для последующего обращения. Если вы создаёте систему с очередью загрузки видео, убедитесь, что обработчик очереди обрабатывает её в пределах окна действия ссылки и реализует собственную логику повторных попыток при сбоях загрузки.

Seedance 2.0 vs Sora 2 vs Runway Gen-4: сравнение для разработчиков

Выбор правильного API для генерации ИИ-видео зависит от ваших конкретных требований по нескольким параметрам: качество результата, экономическая эффективность, зрелость API, гибкость входных данных и сложность интеграции. Оценивая эти платформы для проекта разработки, вам необходимо сравнение, которое выходит за рамки маркетинговых заявлений и фокусируется на факторах, реально влияющих на ваш код, бюджет и пользовательский опыт. Этот раздел предоставляет такое сравнение на основе данных из официальной документации, стороннего тестирования и подробного сравнения моделей, опубликованного на нашем сайте.

Основные преимущества Seedance 2.0 лежат в трёх областях: гибкость мультимодального ввода, экономическая эффективность и аудиовозможности. Ни один другой API в настоящее время не принимает до 12 референсных файлов (9 изображений, 3 видео, 3 аудио) в одном запросе на генерацию. Это делает его уникально подходящим для приложений, требующих консистентности персонажей в нескольких видео, демонстраций продуктов с конкретными визуальными ссылками или генерации музыкальных клипов с синхронизацией движений губ. Ориентировочное ценообразование от $0,10 до $0,80 за минуту позиционирует его как наиболее экономичный вариант для объёмных сценариев использования. Разработчикам, создающим приложения для контент-мейкеров, автоматизации социальных сетей или производства видео для электронной коммерции, стоит серьёзно рассмотреть Seedance 2.0.

Sora 2 от OpenAI остаётся эталоном по качеству видео и соответствию промптам. Если ваше приложение отдаёт приоритет наивысшей визуальной точности и бюджет позволяет оплачивать примерно $5 за 10-секундный клип, Sora 2 обеспечивает исключительные результаты. Официальный API стабилен и хорошо задокументирован, с предсказуемыми лимитами и зрелой экосистемой SDK. Для разработчиков, уже работающих на платформе OpenAI, Sora 2 бесшовно интегрируется с существующей аутентификацией и биллингом. Подробное руководство по интеграции можно найти в нашем руководстве по интеграции Sora 2 API.

| Характеристика | Seedance 2.0 | Sora 2 | Runway Gen-4 | Kling 3.0 |

|---|---|---|---|---|

| Макс. разрешение | 2K | 1080p | 1080p | 1080p |

| Диапазон длительности | 4-15 сек | 5-20 сек | 5-10 сек | 5-10 сек |

| Мультимодальный ввод | 12 файлов | Текст + Изображение | Текст + Изображение | Текст + Изображение |

| Встроенный звук | Да (8+ языков) | Нет | Нет | Ограниченно |

| Ориент. цена/10 сек | ~$0,05 | ~$5,00 | ~$5,00 | ~$0,08 |

| Зрелость API | Только сторонний | Официальный, стабильный | Официальный, стабильный | Официальный |

| Поддержка SDK | Только REST | Python, Node | REST, Python | REST |

| Асинхронный паттерн | На основе опроса | На основе опроса | На основе опроса | На основе опроса |

Runway Gen-4 занимает промежуточную позицию с сильной экосистемой креативных инструментов и хорошо задокументированным API. Его кредитная модель ценообразования менее предсказуема, чем стоимость за клип, но обеспечивает тесную интеграцию с веб-инструментами монтажа Runway, что может быть ценно для команд, сочетающих API-автоматизацию с ручной творческой работой. Документация API обширна, а сообщество разработчиков активно, что снижает порог входа.

Для разработчиков, сравнивающих стоимость между платформами, статья о доступных альтернативных API для видео содержит более детальный анализ, включая скидки за объём и пакетное ценообразование. Также может оказаться полезной статья о ценах и квотах Sora 2 для полного понимания картины затрат при сравнении с Seedance 2.0.

Практическая рекомендация для большинства разработчиков — использовать мультимодельный подход в текущий период стремительной эволюции генеративного видео. Вместо того чтобы полностью привязываться к одной платформе, выстраивайте слой интеграции с поддержкой переключения моделей через унифицированный API, тестируйте качество вывода каждой модели применительно к вашему конкретному сценарию использования и оптимизируйте затраты после валидации качества. Примеры кода, приведённые ранее в этом руководстве, спроектированы именно для такого подхода — они работают с любым OpenAI-совместимым эндпоинтом, что делает переключение моделей изменением одного параметра конфигурации.

Журнал изменений API и официальная дорожная карта

Отслеживание быстро развивающейся экосистемы Seedance 2.0 требует знания того, что уже произошло и чего ожидать. Этот журнал изменений служит справочным материалом, который мы обновляем по мере появления официальных объявлений. Добавьте эту страницу в закладки и возвращайтесь периодически, чтобы не пропустить изменения, способные повлиять на вашу интеграцию.

10 февраля 2026 — Seedance 2.0 официально анонсирован ByteDance. Продемонстрированы ключевые возможности: текст-в-видео, изображение-в-видео с мультимодальным синтаксисом @ для ссылок, встроенная генерация звука с синхронизацией губ, поддержка разрешений 480p-2K, длительность 4-15 секунд, 6 форматов соотношения сторон. Модель доступна через потребительскую платформу Jimeng.

11-12 февраля 2026 — Сторонние агрегаторы API начинают предлагать доступ к Seedance 2.0. Первые отзывы свидетельствуют об улучшении качества по сравнению с Seedance 1.5 Pro в когерентности движений, рендеринге текста и консистентности человеческого тела. Официальный REST API ещё не доступен.

Ожидается: ~24 февраля 2026 — Запуск официального API через Volcengine (Volcano Ark). Ожидается публикация лимитов, официальных тарифных планов, обязательств по SLA и документации для разработчиков. Основано на предыдущих паттернах запуска ByteDance для Seedance 1.0 и 1.5 Pro.

Ожидается: I квартал 2026 — Выпуск SDK-пакетов для Python и JavaScript/TypeScript. Поддержка вебхуков для push-уведомлений о завершении задач (устраняя необходимость опроса). Возможный корпоративный тариф с индивидуальными SLA-соглашениями.

Для разработчиков, интегрирующих сейчас через сторонние платформы, ключевым моментом для отслеживания является дата запуска официального API и совпадение путей эндпоинтов с задокументированными в этом руководстве паттернами. Мы намеренно использовали пути эндпоинтов, соответствующие консенсусу между несколькими сторонними реализациями, который исторически близко совпадает с официальными запусками. Тем не менее, имена параметров, форматы ответов и коды ошибок могут измениться при выходе официального API. Класс SeedanceClient, представленный в этом руководстве, централизует всё взаимодействие с API в методах, которые легко обновить, поэтому адаптация к официальному API должна потребовать изменений только в базовом URL и, возможно, нескольких именах параметров.

Часто задаваемые вопросы

Доступен ли официально Seedance 2.0 API?

По состоянию на 12 февраля 2026 года — нет. ByteDance не запускала официальный REST API для Seedance 2.0. На странице моделей (seed.bytedance.com) перечислены только Seedance 1.0 и 1.5 Pro. Сторонние платформы предоставляют доступ через собственные эндпоинты. Запуск официального API ожидается около 24 февраля 2026 года через Volcengine.

Сколько стоит генерация одного видео через Seedance 2.0 API?

Ориентировочные цены из сторонних источников: ~$0,10/мин при 720p (Basic), ~$0,30/мин при 1080p (Pro) и ~$0,80/мин при 2K (Cinema). Типичный 10-секундный клип в 1080p стоит около $0,05. Это сторонние оценки по состоянию на февраль 2026 года, которые будут обновлены после публикации официальных цен.

Можно ли использовать один и тот же код для Seedance 2.0 и Sora 2?

Да, если вы используете OpenAI-совместимую платформу. Класс SeedanceClient из этого руководства работает с любой платформой, поддерживающей асинхронный паттерн «отправить-опросить-получить». Для переключения моделей достаточно изменить параметр model и base_url — никаких других изменений в коде не требуется.

Что происходит, если генерация видео завершается неудачей?

Это зависит от платформы. Некоторые платформы взимают плату за неудачные генерации, тогда как другие (например, laozhang.ai) предлагают политику «без оплаты за неудачи», при которой отклонения модерацией контента, тайм-ауты и ошибки сервера не влекут расходов. Всегда уточняйте политику биллинга платформы перед масштабированием продуктового использования.

Сколько времени занимает генерация видео?

Типичное время генерации составляет 30-120 секунд в зависимости от разрешения, длительности и серверной нагрузки. Более высокие разрешения (1080p, 2K) и большая длительность (10-15 секунд) требуют пропорционально больше времени. Установите тайм-аут опроса не менее 300 секунд, чтобы учесть условия пиковой нагрузки.