要点速览

OpenClaw 是一款开源 AI 助手网关,可在本地运行并连接 WhatsApp、Telegram、Discord 和 Slack。只需一行命令安装(npm install -g openclaw@latest),运行配置向导(openclaw onboard),即可从任何消息平台与 AI 对话。本指南涵盖多平台安装、Docker 部署、消息集成、Browser Relay 设置和故障排除——助你在一小时内从零开始搭建功能完整的个人 AI 助手。

前置条件与安装方式选择

在开始安装之前,你需要了解可用的选项,并根据自己的使用场景选择最合适的路径。OpenClaw(前身为 Clawdbot 和 Moltbot)提供三种主要安装方式,每种方式根据技术需求和部署环境都有其独特优势。如果你使用过 OpenClaw 的前身产品,可以参考我们之前的 Clawdbot 安装指南了解平台的演进历程。

最常见的方式是 npm/pnpm 全局安装,这是从零到可用 AI 助手的最快路径。此方法需要系统安装 Node.js 22 或更高版本,可在 macOS、Linux 和 Windows(通过 WSL2)上无缝运行。npm 安装非常适合个人电脑,你可以快速访问 OpenClaw 的 CLI 命令,并通过标准包管理器工作流轻松更新。

对于生产环境或 VPS 部署,Docker 安装具有显著优势。容器化方式提供与主机系统完全隔离、通过沙箱执行增强安全性,以及在需要时简化清理。Docker 部署需要 Docker Engine 和 Docker Compose v2,以及至少 2GB RAM(推荐 4GB)和 10GB 磁盘空间用于容器镜像和日志。

源码安装面向希望为 OpenClaw 做贡献或需要自定义代码库的开发者。此路径需要 Git、Node.js 和 pnpm,让你可以访问最新的开发功能并修改 OpenClaw 的行为。虽然维护更复杂,但源码安装提供了对 AI 助手最深层次的控制。

系统要求概览

在开始安装之前,请确保你的系统满足以下最低要求。根据所选安装方式,要求略有不同,但所有路径都有一些基本需求以确保稳定运行。

| 要求 | npm 安装 | Docker 安装 | 源码安装 |

|---|---|---|---|

| 内存 | 最少 2GB,推荐 4GB | 最少 4GB,推荐 8GB | 最少 2GB |

| 磁盘空间 | 500MB 用于包 | 10GB 用于镜像 | 1GB 用于源码 |

| Node.js | v22.0.0 或更高 | 主机不需要 | v22.0.0 或更高 |

| Docker | 不需要 | Docker Engine 24.0+ | 不需要 |

| 操作系统 | macOS、Linux、WSL2 | 任何支持 Docker 的系统 | macOS、Linux、WSL2 |

内存推荐考虑了 Gateway 进程、活动通道连接以及 AI 代理在复杂任务期间的工作内存。如果你计划运行带有多个标签页的 Browser Relay 或处理大型文档,请分配额外内存——8GB 为大多数工作流提供充足空间。

平台特定注意事项

对于 macOS 用户,安装过程很简单——Node.js 可通过 Homebrew 或官方安装程序轻松安装,所有功能开箱即用。如果你计划构建配套应用(macOS 菜单栏应用、iOS 节点),需要安装 Xcode 或命令行工具。macOS 用户在 Apple Silicon 上享有原生 ARM64 支持,在 M1/M2/M3 机器上提供出色性能。launchd 集成确保你的 Gateway 在系统启动后自动运行,作为后台用户服务运行,无需手动干预。

对于 Homebrew 用户,Node.js 安装很简单:

bashbrew install node@22

Linux 用户(推荐 Ubuntu 22.04 或 24.04)享有原生支持和出色性能。systemd 用户服务集成意味着你的 Gateway 可以作为后台服务运行,在启动时自动启动。Debian、Fedora 和 Arch Linux 也运行良好,但 Ubuntu 提供了经过最多测试的体验。确保你的系统有所需的开发库——大多数发行版默认包含这些,但你可能需要在基于 Debian 的系统上安装 build-essential 以编译任何原生模块。

对于 Ubuntu/Debian 系统,使用以下命令准备环境:

bashsudo apt update && sudo apt install -y curl build-essential curl -fsSL https://deb.nodesource.com/setup_22.x | sudo -E bash - sudo apt install -y nodejs

Windows 用户必须使用 WSL2(Windows 子系统 Linux)而不是原生 Windows。原生 Windows 未经测试,已知与 OpenClaw 的依赖项存在兼容性问题——特别是围绕 Unix 域套接字和文件系统监视。首先安装带有 Ubuntu 的 WSL2,然后在 WSL 环境中按照 Linux 安装步骤操作。WSL2 架构提供接近原生的 Linux 性能,同时保持对 Windows 应用程序的访问。请注意,Gateway 在 WSL2 内部运行,但你可以从常规 Windows 浏览器访问其仪表板,创建无缝的跨环境体验。

快速安装(macOS、Linux、Windows WSL2)

让 OpenClaw 运行起来最快的方式是一行命令安装,它会自动处理 Node.js 验证和包安装。打开终端并运行以下命令通过 npm 全局安装 OpenClaw。

bashnpm install -g openclaw@latest

或者,如果你更喜欢使用 pnpm 进行包管理,可以使用 pnpm add -g openclaw@latest。两种方式产生相同的结果——选择取决于你现有的工具链偏好。

包安装完成后,需要运行配置向导。这个交互式过程配置你的 Gateway 设置,设置与 AI 提供商的认证,并准备后台服务。--install-daemon 标志确保 OpenClaw 安装用户级服务(macOS 上的 launchd,Linux 上的 systemd),保持 Gateway 运行。

bashopenclaw onboard --install-daemon

配置向导会引导你完成几个配置步骤。首先,它询问你的 Gateway 设置——对于大多数用户,选择"本地网关(此机器)"是正确的选择。接下来,你将配置与首选 AI 提供商的认证。OpenClaw 支持 Anthropic(Claude)、OpenAI(GPT 模型)和通过 Ollama 的本地模型。对于 Anthropic,你可以使用 API 密钥或通过 OAuth 的 Claude Pro/Max 订阅凭据。

验证安装

配置完成后,通过检查状态来验证 Gateway 是否正常运行:

bashopenclaw gateway status

你应该看到输出表明 Gateway 正在运行并监听默认端口(18789)。如果状态显示 Gateway 未运行,你可以手动启动它用于调试目的 openclaw gateway,或使用 openclaw gateway logs 检查日志。

测试安装的最快方式是在浏览器中打开仪表板。导航到 http://127.0.0.1:18789/( 或 http://localhost:18789/ )访问控制界面。这个网页界面让你可以立即与 AI 助手聊天,无需配置任何消息平台。如果页面无法加载,首先使用 openclaw gateway 确保 Gateway 正在运行。

仪表板不仅仅是一个聊天界面——它是整个 OpenClaw 安装的综合控制面板。在这里你可以监控活动会话、查看对话历史、管理已连接的通道和调整配置设置。侧边栏显示每个平台的实时连接状态,帮助你快速识别任何连接问题。

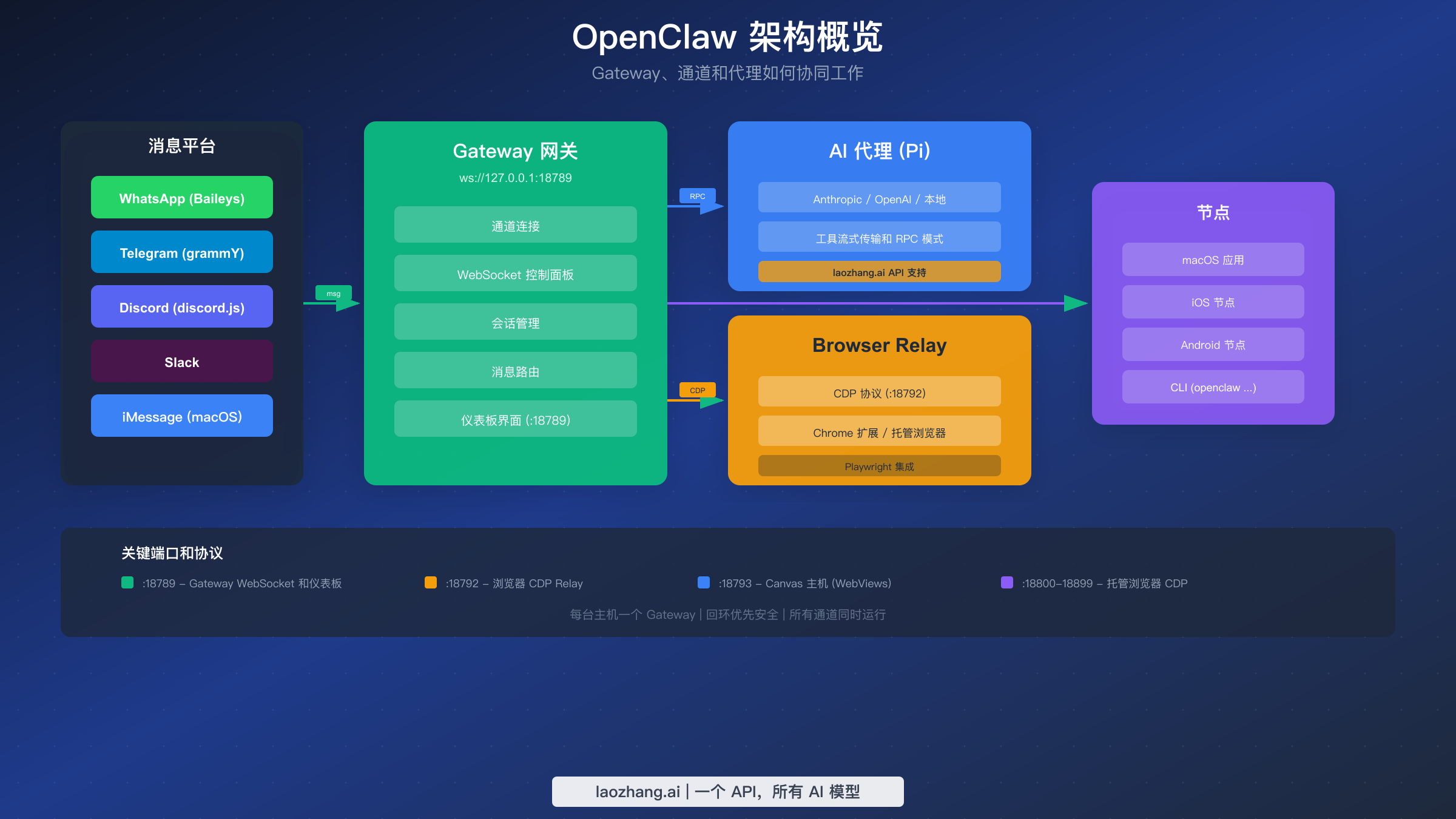

理解 Gateway 架构

当你运行 openclaw gateway 时,你正在启动一个持久的 WebSocket 服务器,作为所有通信的中央枢纽。Gateway 维护与每个消息平台的长连接,缓冲传入消息,将请求路由到适当的 AI 代理,并将响应传递回用户。这种架构意味着只要 Gateway 进程运行,即使你关闭终端窗口或注销系统,你的 AI 助手也保持 24/7 可用。

Gateway 默认监听多个端口:

| 端口 | 用途 | 访问 |

|---|---|---|

| 18789 | Gateway WebSocket 和仪表板 | 主控制界面 |

| 18792 | 浏览器 CDP Relay | 浏览器自动化 |

| 18793 | Canvas 主机 | WebView 渲染 |

| 18800-18899 | 托管浏览器 CDP | 隔离的浏览器实例 |

出于安全考虑,所有端口默认绑定到回环地址(127.0.0.1)。远程访问需要显式配置和认证令牌。

Windows WSL2 特定步骤

对于 Windows 用户,安装需要额外的前置步骤。首先,确保 WSL2 已安装并配置了 Ubuntu。以管理员身份打开 PowerShell 并运行:

powershellwsl --install -d Ubuntu

Ubuntu 安装完成并创建用户账户后,打开 Ubuntu 终端并继续标准 Linux 安装。注意,你应该在 WSL2 内部运行所有 OpenClaw 命令,而不是从 Windows PowerShell 或命令提示符。Gateway 在 WSL2 环境内运行,你可以从 Windows 浏览器访问其仪表板 http://localhost:18789/。

Docker 生产部署

Docker 部署是生产环境、VPS 托管或需要增强隔离和安全性场景的最稳健选择。容器化方式确保 OpenClaw 在具有明确资源边界和简化备份/恢复程序的受控环境中运行。

首先克隆 OpenClaw 仓库以获取 Docker 配置文件:

bashgit clone https://github.com/openclaw/openclaw.git cd openclaw

仓库包含一个 docker-setup.sh 脚本,自动化整个 Docker 配置过程。此脚本在本地构建 Gateway 镜像,在容器上下文中运行配置向导,生成安全令牌,并通过 Docker Compose 启动服务。

bash./docker-setup.sh

在设置过程中,你将回答与 npm 安装相同的配置问题——Gateway 模式、AI 提供商凭据和可选的通道配置。脚本创建两个重要的卷挂载:~/.openclaw 用于配置和 API 密钥,~/openclaw/workspace 用于代理可访问的文件。

环境变量和自定义

Docker 部署支持多个环境变量进行自定义。OPENCLAW_DOCKER_APT_PACKAGES 允许你在镜像构建期间添加系统包,如果你的 Skills 需要额外的依赖项。OPENCLAW_EXTRA_MOUNTS 将额外的主机目录绑定到容器。OPENCLAW_HOME_VOLUME 创建一个命名的 Docker 卷,用于持久化容器的主目录。

bashexport OPENCLAW_HOME_VOLUME="openclaw_home" export OPENCLAW_EXTRA_MOUNTS="$HOME/.codex:/home/node/.codex:ro" ./docker-setup.sh

容器管理命令

部署后,使用标准 Docker Compose 命令管理你的 OpenClaw 实例。使用 docker compose ps 检查容器状态——Gateway 容器应显示状态"Running"或"Up"。使用 docker compose logs -f openclaw-gateway 查看日志以监控任何问题。

对于需要 CLI 访问的管理任务,使用辅助容器:

bashdocker compose run --rm openclaw-cli status docker compose run --rm openclaw-cli dashboard --no-open

更新和维护 Docker 安装

Docker 部署需要定期维护以保持安全补丁和新功能的最新状态。更新过程涉及拉取最新镜像并重新创建容器,同时保留数据卷。

bashdocker compose pull docker compose down docker compose up -d # 验证更新成功 docker compose exec openclaw-gateway openclaw version

对于生产环境,考虑实施分阶段更新流程。在部署到生产之前在开发环境中测试新版本,并维护 ~/.openclaw 配置目录的备份。Docker 卷独立于容器生命周期持久化数据,因此你的 API 密钥、通道配置和对话历史在容器更新后仍然存在。

资源监控和优化

监控 Docker 容器的资源使用以确保最佳性能:

bash# 实时资源统计 docker stats openclaw-gateway # 内存和 CPU 限制(添加到 docker-compose.yml) services: openclaw-gateway: deploy: resources: limits: cpus: '2' memory: 4G reservations: memory: 1G

如果你注意到内存消耗过高,请检查活动会话——Browser Relay 标签页和长对话历史随时间消耗内存。在低活动期间定期重启 Gateway 可以帮助维持最佳性能。

Docker 安全最佳实践

Docker 部署实现安全优先的默认设置。容器以非 root 用户(node,UID 1000)运行,删除所有 Linux 功能,默认启用只读根文件系统。代理会话在隔离的容器中执行,防止对主机系统的任何潜在损害。这些措施创建了纵深防御保护,如果任何组件被攻破,可以限制影响范围。

配置卷挂载时,遵循最小权限原则。只映射代理绝对需要访问的目录。永远不要直接映射你的主目录、SSH 密钥或凭据文件。创建一个范围有限的专用工作区文件夹。以下是安全卷配置的示例:

yamlvolumes: # 仅配置 - 除凭据外只读 - ~/.openclaw:/home/node/.openclaw:rw # 具有明确范围的工作区 - ~/projects/ai-workspace:/workspace:rw # 临时输出 - /tmp/openclaw-output:/output:rw

沙箱模式通过在一次性容器中执行代理命令添加另一层保护。每个命令在隔离环境中运行,容器在执行后立即销毁——即使代理尝试恶意操作,损害也被控制并自动清理。

消息平台集成

OpenClaw 的核心价值在于其能够将多个消息平台桥接到统一的 AI 助手。一旦你的 Gateway 运行起来,你可以连接 WhatsApp、Telegram、Discord、Slack 和其他平台——所有通道同时运行,无论你使用哪个应用,都与同一个 AI 大脑交互。

WhatsApp 集成(Baileys)

WhatsApp 集成使用 Baileys 库通过 WhatsApp Web 协议进行通信。要连接你的 WhatsApp 账户,运行通道登录命令:

bashopenclaw channels login

CLI 在终端显示一个二维码。在手机上打开 WhatsApp,导航到设置 > 已关联的设备 > 关联设备,然后扫描二维码。几秒钟内,你的 WhatsApp 账户就会连接到 Gateway,你可以通过任何 WhatsApp 聊天开始与 AI 助手对话。

对于群聊,OpenClaw 默认使用基于提及的激活——机器人只在你 @提及它时响应。这可以防止 AI 在繁忙的群组中回复每条消息。你可以在 ~/.openclaw/openclaw.json 配置文件中调整此行为:

json{ "channels": { "whatsapp": { "allowFrom": ["+15555550123"], "groups": { "*": { "requireMention": true } } } }, "messages": { "groupChat": { "mentionPatterns": ["@openclaw"] } } }

Telegram 机器人集成(grammY)

Telegram 集成通常被称为"简单模式",因为 Telegram 就是为机器人而设计的。首先,通过 Telegram 的 @BotFather 创建一个新机器人。向 BotFather 发送 /newbot,按照提示命名你的机器人,然后获取你的机器人令牌。

将 Telegram 通道添加到 OpenClaw:

bashdocker compose run --rm openclaw-cli providers add --provider telegram --token YOUR_BOT_TOKEN

或者如果使用 npm 安装:

bashopenclaw channels add telegram --token YOUR_BOT_TOKEN

添加令牌后,你需要批准初始配对。在 Telegram 中向你的新机器人发送消息,然后批准配对请求:

bashopenclaw pairing approve telegram [PAIRING_CODE]

Telegram 机器人支持私信和群聊。在群组中,配置提及模式以控制机器人何时响应。

Discord 机器人集成(discord.js)

Discord 集成支持私信、服务器频道和高级功能如斜杠命令。在 Discord 开发者门户创建一个 Discord 应用程序,向你的应用程序添加一个机器人,并复制机器人令牌。

在 Discord 开发者门户中启用必要的意图——你需要"消息内容意图"才能让机器人在服务器中读取消息内容。

bashopenclaw channels add discord --token YOUR_DISCORD_BOT_TOKEN

使用开发者门户中的 OAuth2 URL 生成器邀请你的机器人到你的 Discord 服务器。选择"bot"范围和适当的权限(发送消息、读取消息历史等)。

Slack 集成

Slack 集成通过 Slack 的 Bot API 工作。在 api.slack.com/apps 创建一个新的 Slack 应用,添加机器人令牌范围(chat:write、channels:history 等),并将应用安装到你的工作区。

bashopenclaw channels add slack --token xoxb-YOUR-SLACK-BOT-TOKEN

iMessage 集成(仅限 macOS)

对于 macOS 用户,OpenClaw 通过消息应用提供原生 iMessage 集成。此集成需要 macOS 菜单栏应用和正确的权限配置。

bash# 安装 macOS 应用 openclaw desktop install

安装后,在系统设置 > 隐私与安全 > 自动化中授予 OpenClaw 应用访问消息的权限。iMessage 通道与其他平台类似工作——来自你配置的联系人的消息路由到 AI 助手,响应直接出现在你的消息对话中。

同时运行多个通道

OpenClaw 的一个关键优势是所有通道并发运行。你可以在通勤时通过 WhatsApp 从手机发消息,到达办公室后在笔记本电脑上切换到 Telegram,然后通过 Discord 与团队交流——同一个 AI 助手处理一切,具有共享的上下文和记忆。默认情况下,私信合并到共享的"主"会话中,而群聊保持隔离。

这种多通道架构开启了强大的工作流程。想象一下,在通勤时通过 WhatsApp 开始对话,到达办公室后通过 Discord 在桌面上继续,稍后通过 Telegram 检查结果。AI 在整个过程中保持完整的上下文,记住之前的指令并在之前的工作基础上构建。

通道优先级允许你定义哪些平台在通知和响应方面优先。在你的 openclaw.json 中配置:

json{ "channels": { "priority": ["telegram", "discord", "whatsapp", "slack"], "notifications": { "preferPrimary": true, "crossPost": false } } }

消息路由和过滤

OpenClaw 支持复杂的消息路由规则,控制不同类型的消息如何被处理。你可以将特定主题路由到专门的代理,根据发送者过滤消息,或为敏感操作实施审批工作流程。

json{ "routing": { "rules": [ { "match": { "content": "/code" }, "agent": "coding-assistant" }, { "match": { "channel": "discord", "server": "work" }, "agent": "work-assistant" } ] } }

这些路由规则支持高级用例,如为不同上下文维护不同的 AI 个性——工作通道的专业助手和个人聊天的休闲助手。

AI 提供商配置

OpenClaw 支持多个 AI 提供商,让你可以灵活选择首选模型和管理成本。代理层(Pi)处理实际的 AI 推理,你可以配置它使用 Anthropic、OpenAI、本地模型或 API 聚合服务。

Anthropic(Claude)配置

对于 Anthropic 的 Claude 模型,你有两种认证选项。推荐的方式是直接使用 API 密钥。在 console.anthropic.com 生成密钥,然后配置 OpenClaw:

bashopenclaw configure --section auth

选择 Anthropic 作为你的提供商,并在提示时粘贴你的 API 密钥。密钥安全存储在 ~/.openclaw/credentials/。

或者,如果你有 Claude Pro 或 Max 订阅,可以通过 OAuth 认证来使用订阅包含的使用量。此选项将你的令牌支出限制在订阅级别。

OpenAI 配置

OpenAI 配置遵循类似的模式。在 platform.openai.com 生成 API 密钥,然后通过配置向导添加。OpenAI 支持从 GPT-4o 到 o3 的广泛模型。

laozhang.ai 作为替代 API 提供商

对于寻求经济实惠的 API 访问或简化计费的用户,laozhang.ai 提供统一的 API 网关,支持多种 AI 模型。该服务通过单一 API 端点提供对 Claude、GPT、Gemini 和其他模型的访问,价格通常比直接提供商访问更低。查看 laozhang.ai 文档了解详细的集成说明。

有关 API 密钥管理和第三方集成的详细信息,请参阅我们的 OpenRouter 集成指南。

通过 Ollama 使用本地模型

对于注重隐私或希望在没有 API 成本的情况下本地运行 AI 的用户,OpenClaw 通过 Ollama 支持本地模型。这种设置将所有数据保留在你的机器上——没有 API 调用,没有使用跟踪,完全隐私。

首先,安装 Ollama 并下载一个功能强大的模型:

bash# 安装 Ollama(macOS/Linux) curl -fsSL https://ollama.com/install.sh | sh # 拉取功能强大的模型(推荐 Llama 3 70B 用于复杂任务) ollama pull llama3:70b # 或使用较小的模型以获得更快的响应 ollama pull llama3:8b

配置 OpenClaw 使用你的本地 Ollama 实例:

bashopenclaw configure --section auth # 选择"Ollama(本地)"作为提供商 # 输入端点:http://localhost:11434 # 选择你首选的模型

本地模型以响应质量换取隐私和成本节约。对于复杂的编码任务或细微的对话,像 Claude 或 GPT-4 这样的云模型通常优于本地替代品。然而,对于常规任务、快速问题或数据敏感性至关重要的情况,本地模型提供了出色的选择。

模型选择指南

选择正确的 AI 模型取决于你的用例、预算和质量要求。以下是指导你决策的实用对比:

| 模型 | 最适合 | 成本 | 速度 | 质量 |

|---|---|---|---|---|

| Claude 3.5 Sonnet | 复杂推理、编码 | $3/1M 输入 | 中等 | 优秀 |

| Claude 3.5 Haiku | 快速任务、高量 | $0.25/1M 输入 | 快 | 良好 |

| GPT-4o | 通用、视觉 | $2.50/1M 输入 | 快 | 优秀 |

| GPT-4o mini | 预算有限、简单任务 | $0.15/1M 输入 | 非常快 | 良好 |

| Llama 3 70B(本地) | 隐私优先、无 API 成本 | 免费(计算) | 因机器而异 | 良好 |

对于大多数用户,从 Claude 3.5 Sonnet 或 GPT-4o 开始提供质量和能力的最佳平衡。当你了解自己的使用模式后,可以通过将较简单的任务路由到更快、更便宜的模型来优化成本。

成本管理和使用监控

OpenClaw 提供内置工具用于监控 API 使用和管理成本。仪表板显示实时令牌消耗,你可以设置使用限制以防止意外费用:

json{ "agents": { "limits": { "maxTokensPerDay": 100000, "maxTokensPerSession": 50000, "warningThreshold": 0.8 } } }

当使用量接近限制时,OpenClaw 会通过你配置的通道发送通知。这种主动警报帮助你避免意外账单并相应调整使用模式。

安全最佳实践

运行一个可以执行命令和浏览网页的 AI 助手需要仔细注意安全。OpenClaw 实现了多层安全措施,但理解和正确配置它们对于安全运行至关重要。

API 密钥保护

你的 AI 提供商 API 密钥如果暴露代表着重大的财务风险。OpenClaw 将凭据存储在 ~/.openclaw/credentials/ 中,具有受限的文件权限。永远不要将这些文件提交到版本控制,避免共享配置目录。对于生产部署,考虑使用环境变量或像 HashiCorp Vault 这样的密钥管理服务。

Docker 沙箱隔离

使用 Docker 部署时,代理会话默认在隔离的容器中执行。这意味着任何文件操作、命令执行或潜在的破坏性操作都发生在一次性容器内,而不是在你的主机系统上。Gateway 本身在主机上运行以维护通道连接,但执行环境保持沙箱化。

在你的 openclaw.json 中配置沙箱行为:

json{ "agents": { "defaults": { "sandbox": { "enabled": true, "scope": "session", "workspace": { "access": "rw", "path": "~/openclaw/workspace" } } } } }

网络安全

Gateway 默认绑定到回环地址(127.0.0.1),意味着只能从本地机器访问。对于远程访问,使用 SSH 隧道或 VPN,而不是直接暴露 Gateway 端口。如果必须绑定到网络接口,始终使用 --token 标志要求认证。

最小权限原则

配置卷挂载或工作区访问时,应用最小权限原则。只给代理访问特定项目目录的权限,而不是广泛的文件系统访问。在不需要写访问时使用只读挂载(ro)。

Browser Relay:用 AI 控制你的 Chrome 标签页

Browser Relay 是 OpenClaw 最强大的功能之一,使你的 AI 助手能够直接控制网页浏览器。通过 Chrome DevTools Protocol(CDP),OpenClaw 可以导航页面、点击元素、填写表单、提取数据和截图——所有这些都由来自任何消息平台的自然语言命令触发。

理解架构

Browser Relay 通过一系列组件运行。当你发送像"打开 Google 并搜索 OpenClaw 文档"这样的消息时,消息从你的聊天应用传递到 Gateway,Gateway 将其路由到 Pi 代理。代理解释你的意图并调用浏览器工具,该工具与 Browser Relay 服务器通信。Relay 将高级命令转换为控制实际浏览器的 CDP 消息。

Relay 服务器默认监听端口 18792(http://127.0.0.1:18792 )。它接受来自 Gateway 的请求并维护与基于 Chromium 的浏览器的 CDP 连接。

三种浏览器配置类型

OpenClaw 支持三种不同的浏览器控制方式,每种适用于不同的用例:

Extension Relay 是默认配置,使用你现有的 Chrome 安装。安装 OpenClaw Browser Relay 扩展,然后手动将其附加到你想让代理控制的标签页。这种方式让你可以利用已登录的会话、书签和浏览上下文。

bashopenclaw browser extension install

安装后,在 Chrome 中启用扩展(你需要启用开发者模式来加载未打包的扩展)。要附加一个标签页,在查看你想控制的页面时点击扩展图标——当附加时徽章显示"ON"。

OpenClaw-managed 配置运行一个专用的 Chromium 实例,具有自己的用户数据目录。这个隔离的浏览器与你的个人浏览数据没有连接,非常适合不应该影响你主浏览器的自动化任务。

在你的设置中配置托管浏览器:

json{ "browser": { "enabled": true, "defaultProfile": "openclaw" } }

Remote CDP 连接到运行在其他地方的 Chromium 浏览器——对于 Docker 部署或连接到远程服务器上的浏览器很有用。在你的配置文件中指定 CDP URL。

调试浏览器问题

如果浏览器操作失败,使用调试工具识别问题:

bashopenclaw browser status openclaw browser highlight <ref>

highlight 命令直观地标识 Playwright 正在定位的元素,帮助你理解为什么选择器可能不匹配。对于依赖 Playwright 的功能(导航、操作、截图),确保你安装了完整的 Playwright 包,而不仅仅是 playwright-core。

常见问题包括页面导航后的陈旧元素引用(页面更改后重新运行快照)、不正确的选择器和沙箱限制。在沙箱化会话中,启用主机浏览器控制 agents.defaults.sandbox.browser.allowHostControl: true 以使用扩展 relay。

实用 Browser Relay 示例

通过示例理解 Browser Relay 有助于澄清其功能。以下是展示该功能强大能力的常见工作流程:

网页研究自动化:请你的 AI 研究一个主题,它可以导航到搜索引擎、访问多个来源、提取相关信息并综合发现——全部自动完成。

用户:"研究 AWS Lambda 的当前定价并总结成本"

AI:[打开浏览器,导航到 AWS 定价页面,提取数据,返回摘要]

表单填写:Browser Relay 可以使用自然语言指令完成网页表单,对于重复的数据输入任务很有用。

用户:"用我的详细信息填写 example.com 上的联系表单"

AI:[导航到页面,识别表单字段,输入信息,提交]

截图文档:通过捕获特定元素或整个页面的截图来生成视觉文档。

用户:"对我们仪表板的主要指标部分截图"

AI:[打开仪表板,等待加载,捕获目标截图]

Browser Relay 性能考虑

Browser Relay 操作比纯文本交互消耗更多资源。每个附加的标签页维护一个需要内存的 CDP 连接,复杂的页面交互涉及代理和浏览器之间的多次往返。

为了最佳性能:

- 将并发附加的标签页限制在 3-5 个(典型工作负载)

- 不再需要时使用浏览器命令关闭标签页

- 自动化密集型任务优先使用 OpenClaw-managed 配置

- 在不需要视觉反馈的后台操作中使用无头模式

在你的浏览器配置中配置无头模式:

json{ "browser": { "profiles": { "automation": { "headless": true, "viewport": { "width": 1920, "height": 1080 } } } } }

有关协议集成的更多信息,请参阅我们的 MCP 协议指南。

故障排除与常见问题

即使仔细设置,你也可能遇到问题。本节涵盖最常见的问题及其解决方案,按类别组织以便快速参考。有关认证特定问题,我们的认证故障排除指南提供更深入的内容。

安装问题

| 问题 | 解决方案 |

|---|---|

| "Node 版本太旧" | 通过 nvm 或官方安装程序安装 Node.js 22+ |

| 权限被拒绝(npm) | 使用 npm install -g 配合 sudo 或修复 npm 权限 |

| WSL2 不可用 | 在 PowerShell 中以管理员身份运行 wsl --install |

| 找不到 Docker | 安装 Docker Desktop(macOS/Windows)或 Docker Engine(Linux) |

Gateway 连接问题

| 问题 | 解决方案 |

|---|---|

| "端口 18789 已被使用" | 停止现有 Gateway 或使用 --port 标志更改端口 |

| 仪表板无法加载 | 使用 openclaw gateway status 验证 Gateway 正在运行 |

| "需要 Gateway 令牌" | 使用 openclaw gateway token 生成令牌并添加到 URL |

| 服务无法启动 | 使用 openclaw gateway logs 检查日志查看具体错误 |

通道/平台问题

| 问题 | 解决方案 |

|---|---|

| WhatsApp 二维码无法扫描 | 确保手机和电脑在同一网络;重新生成二维码 |

| Telegram 机器人不响应 | 验证机器人令牌;检查 @BotFather 是否禁用机器人 |

| Discord 权限错误 | 在开发者门户添加所需意图;重新邀请机器人 |

| "设备配对失败" | 使用 openclaw pairing approve <channel> <code> 批准配对 |

AI 提供商问题

| 问题 | 解决方案 |

|---|---|

| "无效的 API 密钥" | 在提供商控制台重新生成密钥;验证没有空格 |

| "超出速率限制" | 升级计划或等待;考虑使用 laozhang.ai 获得更高限制 |

| "找不到模型" | 检查模型名称拼写;验证你的账户可以访问该模型 |

| 高延迟 | 切换到更快的模型(Flash vs Pro);检查网络连接 |

Browser Relay 问题

| 问题 | 解决方案 |

|---|---|

| "浏览器已禁用" | 在配置中启用:browser.enabled: true;重启 Gateway |

| "Playwright 不可用" | 安装完整的 Playwright 包,不仅仅是 playwright-core |

| 扩展显示红色图标 | 检查 relay 连接;验证端口 18792 可访问 |

| "找不到选择器" | 获取新快照;使用 browser highlight 调试 |

有用的调试命令

bash# 检查整体系统健康状况 openclaw doctor # 查看详细的 Gateway 日志 openclaw gateway logs --tail 100 # 列出已连接的设备和通道 openclaw devices list # 测试 AI 提供商连接 openclaw chat "你好,你正常工作吗?" # 浏览器调试 openclaw browser status openclaw browser screenshot

日志和诊断深入

openclaw doctor 命令执行全面的健康检查,测试安装的每个组件。它验证 Node.js 版本,检查所需的依赖项,测试通道连接,验证 API 凭据,并确认 Browser Relay 功能。故障排除时首先运行此命令——它可以快速识别最常见的问题。

对于更深入的调查,日志文件包含有关 Gateway 操作的详细信息。在 macOS 上,日志通常位于 ~/.openclaw/logs/。在使用 systemd 的 Linux 上,你也可以通过 journalctl 访问日志:

bash# 查看 systemd 服务日志 journalctl --user -u openclaw-gateway -f # 导出日志用于共享/分析 openclaw gateway logs --export ~/desktop/openclaw-debug.log

在 GitHub 上报告问题时,包括 openclaw doctor 的输出和相关的日志摘录。在共享之前清理任何 API 密钥或个人信息。

恢复和重置程序

如果你的 OpenClaw 安装进入无法恢复的状态,几个重置选项可以帮助恢复功能而不会丢失所有配置:

bash# 软重置 - 重启 Gateway 并重新连接通道 openclaw gateway restart # 通道重置 - 清除通道会话,需要重新认证 openclaw channels reset --channel whatsapp # 完全重置 - 删除所有配置(谨慎使用) openclaw reset --confirm

在执行完全重置之前,备份你的 ~/.openclaw 目录。这会保留你的 API 密钥、通道配置和对话历史,允许你在需要时恢复设置。

性能优化技巧

如果你遇到响应时间慢或资源使用高的问题,考虑以下优化策略:

- 减少对话历史保留 - 长历史消耗内存并增加上下文处理时间

- 使用适当的模型 - 将简单查询路由到更快、更轻的模型

- 限制 Browser Relay 范围 - 关闭未使用的标签页,自动化优先使用无头模式

- 安排维护重启 - 定期 Gateway 重启防止内存累积

- 使用内置工具监控 - 使用

openclaw metrics识别瓶颈

json{ "performance": { "historyRetention": 50, "sessionTimeout": 3600, "gcInterval": 1800 } }

下一步与资源

安装和配置 OpenClaw 后,你已准备好探索其全部潜力。该平台远不止基本聊天——通过 Skills、自动化和集成,OpenClaw 可以成为强大的生产力工具。

创建自定义 Skills

Skills 是扩展 OpenClaw 功能的模块化函数。ClawHub 市场提供 700+ 社区创建的 Skills,涵盖从智能家居控制到开发自动化的所有内容。要探索可用的 Skills 或创建你自己的,请查看我们的创建自定义 Skills 指南。

官方资源

- OpenClaw 文档 — 所有功能的综合参考

- GitHub 仓库 — 源代码、问题和讨论

- ClawHub 市场 — Skills 和扩展

- Discord 社区 — 支持和讨论

高级主题探索

当你熟悉基本操作后,考虑探索不同用例的多代理路由、计划任务的 cron 作业自动化、事件驱动工作流的 webhook 集成,以及通过 Tailscale 或 SSH 隧道的远程 Gateway 访问。

OpenClaw 将你的消息应用转变为强大的 AI 界面。无论你是自动化繁琐任务、构建 24/7 AI 助手,还是尝试 AI 驱动的网页自动化,该平台为无数可能性提供了基础。从基础开始,探索文档,随着需求增长逐步扩展你的设置。

获取帮助和社区支持

OpenClaw 社区积极帮助新手和有经验的用户。当你遇到本指南或官方文档中未涵盖的问题时:

- 在 GitHub 上搜索现有问题——你的问题可能已经有解决方案

- 加入 Discord 社区进行实时讨论和支持

- 创建详细的 bug 报告,包括日志、配置片段和重现步骤

- 分享你的解决方案,当你解决了其他人可能遇到的问题时

OpenClaw 的开源性质意味着社区不断改进平台。你的反馈、bug 报告和贡献帮助让项目对每个人都变得更好。无论你是修复文档中的拼写错误还是实现新功能,各种规模的贡献都受欢迎。

为你的安装做好未来准备

随着 AI 能力的快速发展,OpenClaw 被设计为能够适应。模块化架构允许你在不重新配置通道的情况下更换 AI 提供商,在新平台可用时添加它们,并通过 Skills 系统集成新兴工具。通过现在建立坚实的基础,你可以利用未来的进步而无需从头开始。

保持安装更新以受益于安全补丁、新功能和改进的模型支持。在 GitHub 上订阅 OpenClaw 发布或关注项目的公告频道,以了解重要更新。