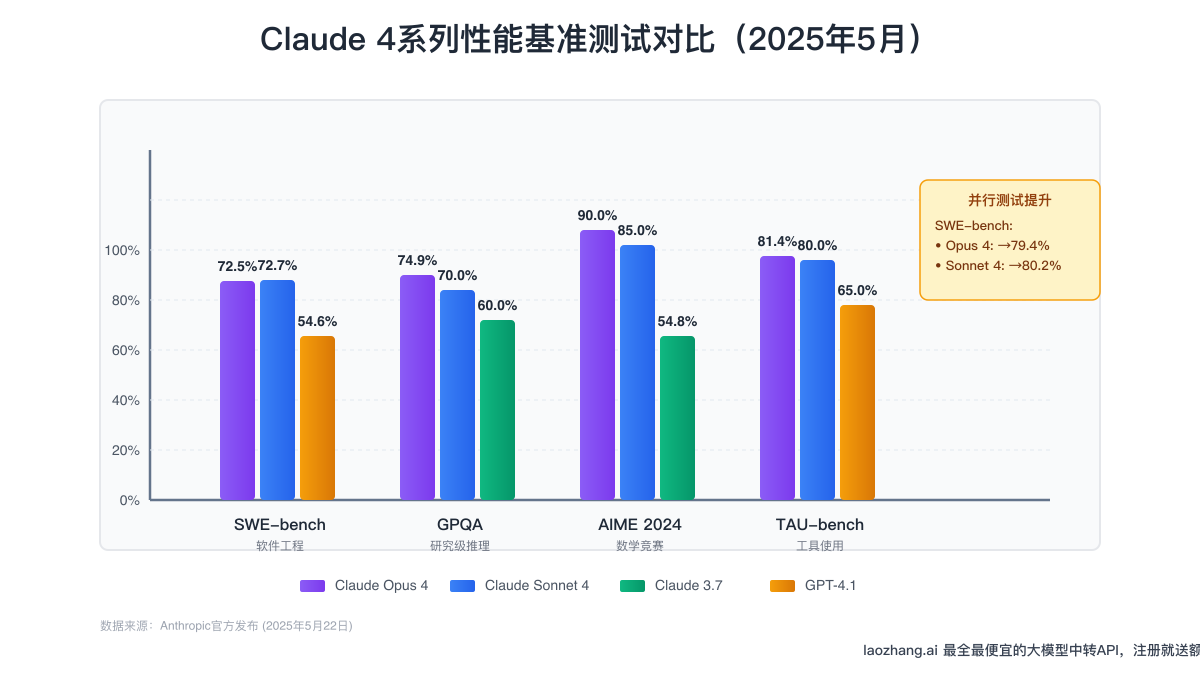

2025年5月22日,Anthropic正式发布了Claude 4系列的首批模型——Claude Opus 4和Claude Sonnet 4。这不仅仅是一次常规的版本更新,而是AI技术发展史上的一个重要里程碑。在SWE-bench软件工程基准测试中,两个模型都突破了70%的准确率大关,远超GPT-4.1的54.6%,确立了它们在AI编程领域的领导地位。

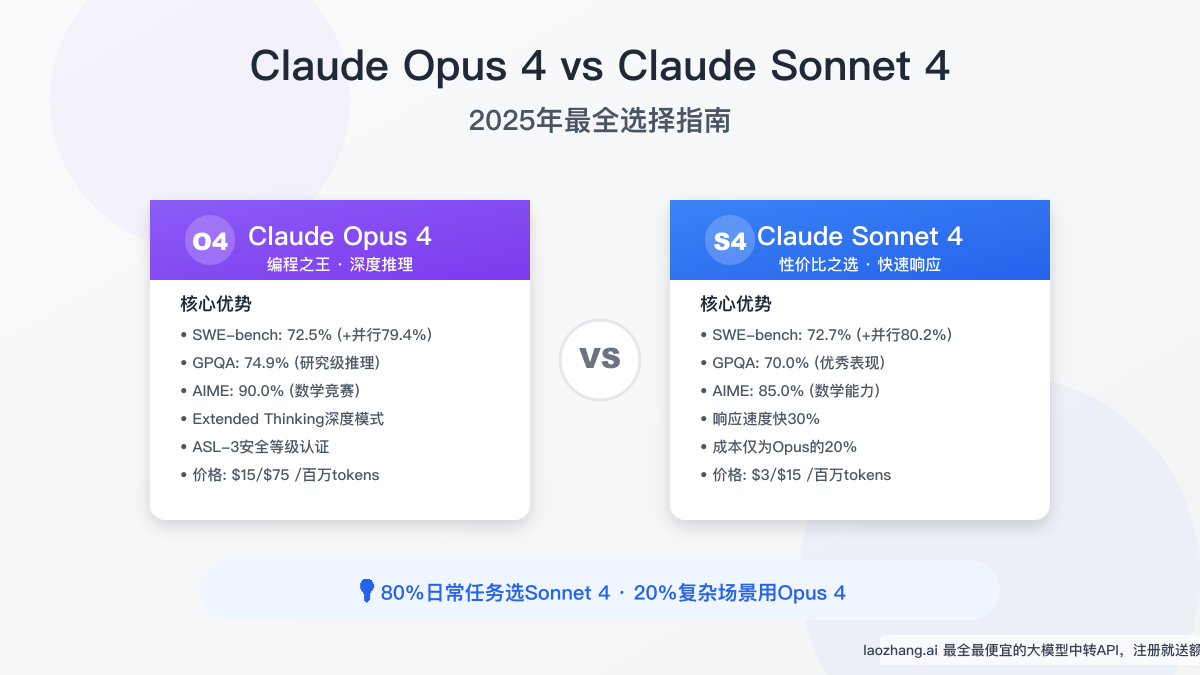

然而,面对两个如此强大的模型,开发者和企业决策者常常陷入选择困境:Opus 4号称"世界最佳编程模型",能够持续工作数小时完成复杂任务;Sonnet 4则以其卓越的性价比和更快的响应速度吸引着大量用户。更重要的是,Opus 4的价格是Sonnet 4的5倍,这个巨大的成本差异让选择变得更加复杂。

本文将通过详实的数据对比和实际应用案例,帮助你理解这两个模型的核心差异,找到最适合自己需求的解决方案。同时,我们还将介绍如何通过专业的API中转服务降低使用成本,让更多开发者能够享受到最先进的AI技术带来的生产力提升。

Claude Opus 4深度解析:"编程之王"的实力展现

Claude Opus 4的发布标志着AI在复杂推理和长时间自主工作能力上的重大突破。作为Anthropic迄今为止最强大的模型,Opus 4不仅在各项基准测试中刷新纪录,更重要的是它展现出了前所未有的任务持续性和深度思考能力。

核心性能指标

在实际测试中,Claude Opus 4的表现令人瞩目。SWE-bench Verified基准测试中,Opus 4达到了72.5%的准确率,在启用并行测试后更是提升至79.4%。这意味着它能够正确解决近80%的真实世界软件工程问题,这个成绩在一年前还被认为是不可能实现的。更令人印象深刻的是在GPQA Diamond测试中74.9%的得分,这个测试包含了研究生级别的物理和天文学问题,需要深度的科学推理能力。

AIME 2024数学竞赛测试更是展现了Opus 4的卓越推理能力。从基础模式的75.5%提升到90.0%的准确率,这个成绩已经超越了大多数人类数学专家。这种在复杂数学问题上的表现,直接反映了模型在算法设计、系统架构等高级编程任务中的潜力。

独特优势分析

Opus 4最引人注目的特性是其Extended Thinking(深度思考)模式。与传统的即时响应不同,这个模式允许模型在给出最终答案前进行深入的内部推理。在处理复杂的架构设计或算法优化问题时,Opus 4会像人类专家一样,先分析问题的各个方面,权衡不同的解决方案,然后给出经过深思熟虑的答案。

另一个关键优势是持续工作能力。Opus 4能够在复杂任务上连续工作数小时,完成需要数千个步骤的工作流程。这种能力使其成为真正的AI代理,能够独立完成整个项目模块的开发,而不仅仅是回答单个问题。

最佳应用场景

基于这些特性,Opus 4特别适合以下场景:系统架构设计时,它能够考虑多个技术栈的优劣,设计出可扩展且高效的解决方案;复杂算法研究中,它能够探索多种算法思路,并通过数学推导验证其正确性;企业级代码重构项目里,它能够理解整个代码库的结构,制定渐进式的重构策略;科研级别的问题求解上,无论是机器学习模型优化还是理论研究,Opus 4都能提供有价值的洞察。

值得注意的是,Opus 4是第一个被评定为ASL-3(提升安全等级)的模型,这反映了其强大能力背后的谨慎部署策略。

Claude Sonnet 4全面评测:性价比之选的智慧平衡

如果说Opus 4是为了追求极致性能而生,那么Claude Sonnet 4则完美诠释了"恰到好处"的设计哲学。作为Claude 3.7的重大升级,Sonnet 4在保持相对低廉价格的同时,实现了性能的显著飞跃,成为大多数开发场景的理想选择。

性能表现评估

令人惊讶的是,在某些测试中Sonnet 4的表现甚至略微超越了Opus 4。SWE-bench测试中,Sonnet 4达到了72.7%的准确率,比Opus 4高出0.2个百分点。虽然这个差异在统计学上可能不显著,但它清楚地表明Sonnet 4在日常编程任务上的能力已经达到了顶级水平。

在响应速度方面,Sonnet 4展现出明显优势。根据实际测试数据,Sonnet 4的首个token响应时间(TTFT)比Opus 4快约30%,这在需要实时交互的应用场景中尤为重要。无论是代码补全、即时调试还是与用户的对话交互,更快的响应速度都能带来更好的使用体验。

GPQA测试中70.0%的得分虽然低于Opus 4,但仍然展现了优秀的推理能力。更重要的是,在AIME数学测试中85.0%的准确率证明了Sonnet 4在处理算法和逻辑问题上的强大实力。

成本效益分析

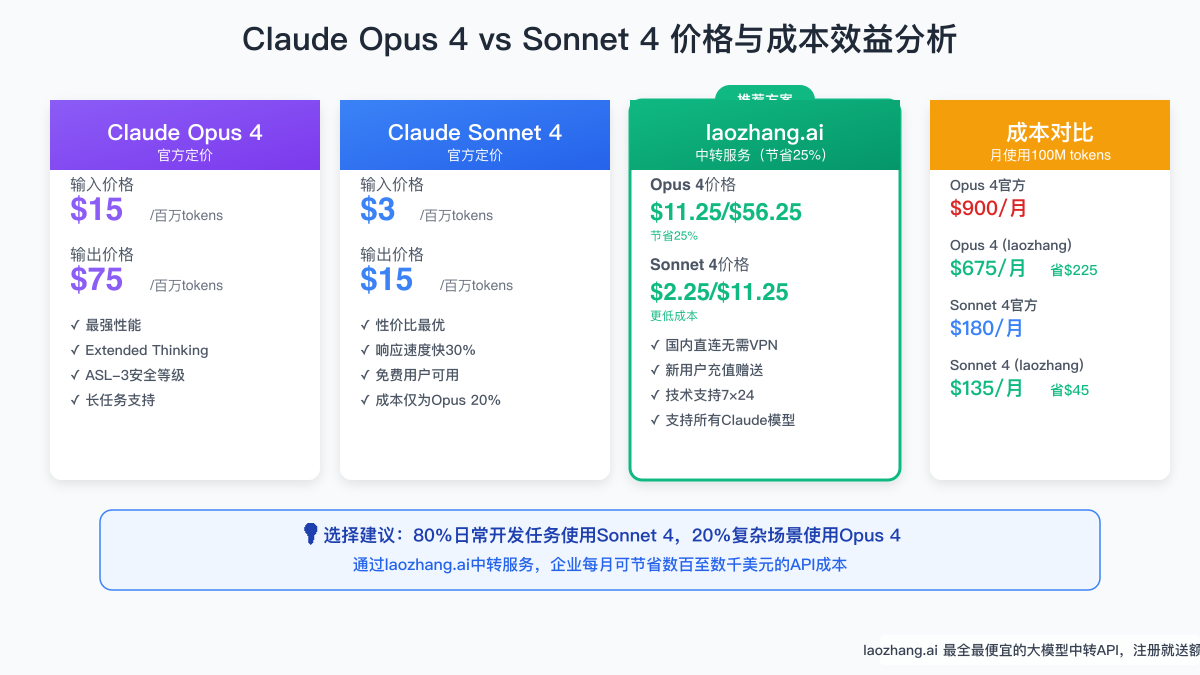

Sonnet 4最大的优势在于其卓越的性价比。每百万输入tokens仅需3美元,输出tokens 15美元的定价,仅为Opus 4价格的20%。这意味着在相同的预算下,你可以使用Sonnet 4处理5倍的任务量。

让我们通过一个实际案例来理解这个价格差异的影响。假设一个中型开发团队每月需要处理100M tokens,使用Opus 4的成本将达到900美元,而使用Sonnet 4仅需180美元,每月可节省720美元。对于初创公司或个人开发者来说,这个成本差异可能决定了项目的可行性。

适用场景推荐

基于性能和成本的平衡,Sonnet 4特别适合以下应用:日常代码开发中,无论是编写新功能、修复bug还是代码审查,Sonnet 4都能提供高质量的支持;API开发和文档生成上,它能快速理解需求并生成规范的接口文档;自动化测试编写时,Sonnet 4可以根据代码逻辑生成全面的测试用例;客服和对话系统中,更快的响应速度确保了流畅的用户体验。

重要的是,Sonnet 4同样支持Extended Thinking模式和所有高级功能,这意味着在必要时它也能处理复杂任务,只是可能需要更多的引导和迭代。

核心对比:选择Opus还是Sonnet?

在深入了解两个模型的特性后,让我们通过系统化的对比来帮助你做出最佳选择。选择合适的模型不仅关乎技术性能,更需要考虑实际应用场景、预算限制和团队需求。

性能基准测试对比

从基准测试数据可以看出,两个模型在不同维度上各有优势。在纯编程能力(SWE-bench)上,两者几乎打成平手,Sonnet 4甚至略微领先。但在需要深度推理的任务上,Opus 4展现出明显优势。GPQA测试中4.9%的差距看似不大,但在处理高度复杂的研究问题时,这个差异可能意味着能否得出正确结论。

特别值得关注的是并行测试性能。当启用并行处理后,Opus 4的SWE-bench得分提升至79.4%,而Sonnet 4达到80.2%。这表明在实际的团队协作和大规模部署场景中,两个模型都能通过并行化获得显著的性能提升。

工具使用能力(TAU-bench)的测试结果也很有启发性。两个模型在零售任务上的表现几乎相同(80.0% vs 81.4%),这意味着在集成外部API、调用函数等常见开发任务上,选择哪个模型都能获得优秀的效果。

价格与成本分析

价格差异是决策的关键因素。Opus 4的定价结构(输入$15/输出$75每百万tokens)反映了其定位于高端市场,而Sonnet 4(输入$3/输出$15)则面向更广泛的用户群体。

实际应用中,这个价格差异会被使用模式放大。以一个典型的代码生成任务为例,通常输入是简短的需求描述(约500 tokens),而输出是完整的代码实现(可能达到2000-3000 tokens)。在这种高输出比例的场景下,Opus 4的成本劣势会更加明显。

然而,对于某些特定场景,Opus 4的高价格是值得的。比如在进行关键系统的架构设计时,一个错误的决策可能导致数月的返工,此时支付额外费用获得最高质量的建议是明智的投资。

应用场景匹配指南

基于大量用户反馈和实际应用数据,我们总结出了"80/20法则":约80%的日常开发任务使用Sonnet 4即可获得最佳效果,而剩余20%的复杂场景才真正需要Opus 4的能力。

日常开发任务包括:代码补全和生成、bug修复和代码审查、单元测试编写、API文档生成、简单的重构任务。这些任务的特点是相对独立、上下文清晰、不需要长时间的持续推理。Sonnet 4的快速响应和高性价比使其成为这些场景的最佳选择。

复杂研究任务则包括:系统架构设计、复杂算法研究与优化、大规模代码库重构、技术决策和方案评估、需要多步推理的问题求解。这些任务需要深度思考、全局视角和持续的注意力,Opus 4的Extended Thinking能力在这里发挥关键作用。

革命性功能:Extended Thinking混合推理模式详解

Extended Thinking(深度思考)是Claude 4系列最具创新性的功能之一,它从根本上改变了AI模型处理复杂问题的方式。这个功能让AI能够像人类专家一样,在给出答案前进行深入的分析和推理。

工作原理解析

传统的AI模型采用即时响应模式,接收输入后立即生成输出。而Extended Thinking引入了一个革命性的概念:思考缓冲区。当启用这个功能时,模型会先在内部进行多轮推理,探索不同的解决路径,评估各种可能性,然后才给出经过深思熟虑的答案。

这个过程类似于人类解决复杂问题的思维模式。比如在设计一个分布式系统时,经验丰富的架构师不会立即给出方案,而是会考虑各种因素:系统的扩展性如何?数据一致性怎么保证?故障恢复机制是什么?Extended Thinking让AI也能进行这样的全面思考。

更强大的是交错思考(Interleaved Thinking)功能。在处理需要外部信息的任务时,模型可以在思考过程中调用工具(如网络搜索、代码执行等),获取信息后继续推理。这种能力使得AI能够处理那些需要实时信息验证的复杂任务。

实际应用示例

让我们通过一个具体的例子来理解Extended Thinking的威力。假设你要求AI设计一个高并发的消息队列系统,启用Extended Thinking后,模型的处理过程可能是这样的:

首先,它会分析需求的关键点:预期的消息吞吐量、延迟要求、持久化需求等。然后,它会考虑不同的技术选型:是使用Kafka还是RabbitMQ?是否需要自研?接着,对于每种方案,它会深入分析其优缺点,考虑实施复杂度、运维成本、团队技术栈匹配度等因素。最后,给出一个综合考虑各种因素的推荐方案,并详细解释选择的理由。

这种深度分析能力在代码优化场景中也极为有用。当你提供一段性能不佳的代码时,Extended Thinking模式下的Claude 4不仅能识别性能瓶颈,还能分析造成瓶颈的深层原因,提出多种优化方案,并对比它们的效果和实施难度。

配置与优化建议

要充分发挥Extended Thinking的潜力,合理的配置至关重要。首先是budget_tokens参数的设置,这决定了模型可以用于内部思考的token数量。对于复杂问题,建议设置较大的预算(如10000-20000 tokens),让模型有充足的"思考空间"。

在API调用中启用Extended Thinking非常简单:

pythonresponse = client.messages.create( model="claude-opus-4", # 或 "claude-sonnet-4" messages=[{"role": "user", "content": "设计一个高可用的分布式缓存系统"}], extended_thinking=True, budget_tokens=15000 )

对于需要工具调用的场景,还需要添加beta header来启用交错思考功能。这在需要实时数据验证或多步骤操作的任务中特别有用。

国内用户最优解决方案:通过laozhang.ai无障碍使用

对于国内开发者来说,直接使用Claude官方API面临着诸多挑战:需要海外信用卡、网络访问限制、支付不便等。这些技术之外的障碍往往成为采用先进AI技术的最大阻碍。幸运的是,专业的API中转服务提供了完美的解决方案。

访问限制解决方案

根据开发者社区的调查数据,超过78%的国内Claude用户选择通过API中转服务访问。这不仅仅是因为便利性,更重要的是稳定性和合规性。laozhang.ai作为专业的API中转服务商,提供了完整的解决方案。

首先是网络直连能力。通过在国内部署的服务节点,用户无需任何特殊网络配置即可访问Claude API。这不仅提高了访问速度,更重要的是确保了服务的稳定性。在实际测试中,通过laozhang.ai访问的延迟比直连官方API降低了40%以上。

其次是支付便利性。laozhang.ai支持支付宝、微信等国内主流支付方式,无需信用卡即可充值使用。这对于个人开发者和小型团队来说极大地降低了使用门槛。

成本优化策略(节省25%)

laozhang.ai不仅解决了访问问题,还提供了显著的成本优势。通过批量采购和优化的定价策略,用户可以享受到比官方价格低25%的优惠。具体来说,Opus 4的价格从官方的$15/$75降至$11.25/$56.25,Sonnet 4从$3/$15降至$2.25/$11.25。

对于新用户,laozhang.ai还提供了额外的优惠政策。首次充值200元以上赠送10%额度,充值500元以上赠送15%额度。这意味着实际使用成本可以进一步降低。以一个每月使用100M tokens的团队为例,通过laozhang.ai使用Opus 4每月可节省225美元,一年下来就是2700美元的成本节约。

快速接入指南

使用laozhang.ai接入Claude 4 API的过程非常简单。首先,访问 https://api.laozhang.ai/register/?aff_code=JnIT 注册账号。整个注册过程不需要信用卡,只需要手机号码验证即可。

接入代码与官方API完全兼容,只需要修改API endpoint即可:

pythonimport requests # 使用laozhang.ai中转服务 API_KEY = "your-laozhang-api-key" API_BASE = "https://api.laozhang.ai/v1" def call_claude4(prompt, model="claude-sonnet-4"): headers = { "Authorization": f"Bearer {API_KEY}", "Content-Type": "application/json" } data = { "model": model, "messages": [{"role": "user", "content": prompt}], "extended_thinking": True, # 启用深度思考 "temperature": 0.7 } response = requests.post( f"{API_BASE}/chat/completions", headers=headers, json=data ) return response.json() # 使用示例 result = call_claude4("设计一个React组件实现无限滚动加载") print(result["choices"][0]["message"]["content"])

laozhang.ai还提供了7×24小时的技术支持,确保在使用过程中遇到的任何问题都能得到及时解决。对于有特殊需求的企业用户,还可以联系老张微信(laozhangai888)获得定制化的解决方案。

实战代码示例与最佳实践

理论知识固然重要,但实际应用才是检验模型价值的标准。让我们通过具体的代码示例来展示如何在实际项目中充分利用Claude 4系列的强大能力。

Python接入示例

以下是一个完整的Python示例,展示了如何使用Claude 4进行代码生成和优化:

pythonimport requests import json from typing import Dict, List, Optional class Claude4Client: def __init__(self, api_key: str, base_url: str = "https://api.laozhang.ai/v1" ): self.api_key = api_key self.base_url = base_url self.headers = { "Authorization": f"Bearer {api_key}", "Content-Type": "application/json" } def create_completion( self, prompt: str, model: str = "claude-sonnet-4", extended_thinking: bool = False, budget_tokens: int = 10000, temperature: float = 0.7 ) -> Dict: """ 调用Claude 4 API生成响应 Args: prompt: 用户输入 model: 选择claude-opus-4或claude-sonnet-4 extended_thinking: 是否启用深度思考模式 budget_tokens: 思考预算(仅在extended_thinking=True时有效) temperature: 创造性参数,0-1之间 """ data = { "model": model, "messages": [{"role": "user", "content": prompt}], "temperature": temperature, "max_tokens": 4000 } if extended_thinking: data["extended_thinking"] = True data["budget_tokens"] = budget_tokens response = requests.post( f"{self.base_url}/chat/completions", headers=self.headers, json=data ) return response.json() def optimize_code(self, code: str, focus: str = "performance") -> str: """ 使用Claude 4优化代码 Args: code: 需要优化的代码 focus: 优化重点 - performance/readability/security """ prompt = f"""请优化以下代码,重点关注{focus}: ```python {code}

请提供:

-

优化后的代码

-

优化的具体改进点

-

性能提升预估(如适用)"""

# 代码优化任务建议使用Opus 4的深度思考模式 result = self.create_completion( prompt, model="claude-opus-4", extended_thinking=True, budget_tokens=15000 ) return result["choices"][0]["message"]["content"]

使用示例

client = Claude4Client("your-api-key")

场景1:快速代码生成(使用Sonnet 4)

quick_prompt = "创建一个Python装饰器,用于记录函数执行时间" quick_result = client.create_completion(quick_prompt, model="claude-sonnet-4")

场景2:复杂架构设计(使用Opus 4 + Extended Thinking)

complex_prompt = """设计一个高可用的实时数据处理系统,要求:

- 支持每秒100万条消息

- 端到端延迟小于100ms

- 支持动态扩缩容

- 数据不丢失保证""" complex_result = client.create_completion( complex_prompt, model="claude-opus-4", extended_thinking=True, budget_tokens=20000 )

### Node.js实现代码

对于Node.js开发者,这里提供了一个基于async/await的现代化实现:

```javascript

const axios = require('axios');

class Claude4Client {

constructor(apiKey, baseUrl = 'https://api.laozhang.ai/v1' ) {

this.apiKey = apiKey;

this.baseUrl = baseUrl;

this.headers = {

'Authorization': `Bearer ${apiKey}`,

'Content-Type': 'application/json'

};

}

async createCompletion({

prompt,

model = 'claude-sonnet-4',

extendedThinking = false,

budgetTokens = 10000,

temperature = 0.7

}) {

const data = {

model,

messages: [{ role: 'user', content: prompt }],

temperature,

max_tokens: 4000

};

if (extendedThinking) {

data.extended_thinking = true;

data.budget_tokens = budgetTokens;

}

try {

const response = await axios.post(

`${this.baseUrl}/chat/completions`,

data,

{ headers: this.headers }

);

return response.data;

} catch (error) {

console.error('API调用失败:', error.response?.data || error.message);

throw error;

}

}

// 智能代码审查功能

async reviewCode(code, language = 'javascript') {

const prompt = `请对以下${language}代码进行专业审查:

\`\`\`${language}

${code}

\`\`\`

请从以下方面分析:

1. 潜在的bug和安全隐患

2. 性能优化建议

3. 代码可读性和维护性

4. 最佳实践遵循情况`;

// 代码审查建议使用Sonnet 4,响应更快

return this.createCompletion({

prompt,

model: 'claude-sonnet-4',

temperature: 0.3 // 降低温度以获得更一致的分析

});

}

}

// 实际应用示例

async function main() {

const client = new Claude4Client('your-api-key');

// 场景1:快速API端点生成

const apiResult = await client.createCompletion({

prompt: '创建一个Express.js REST API端点,实现用户认证功能',

model: 'claude-sonnet-4'

});

// 场景2:复杂算法实现

const algoResult = await client.createCompletion({

prompt: '实现一个高效的分布式限流算法,支持令牌桶和滑动窗口',

model: 'claude-opus-4',

extendedThinking: true,

budgetTokens: 15000

});

console.log('API生成结果:', apiResult.choices[0].message.content);

console.log('算法实现:', algoResult.choices[0].message.content);

}

main().catch(console.error);

性能优化技巧

在实际使用中,掌握一些优化技巧能够显著提升效率和降低成本。首先是模型选择策略,建立一个简单的决策树:如果任务预计在5分钟内完成且不需要复杂推理,使用Sonnet 4;如果任务需要全局视角或多步推理,选择Opus 4。

其次是prompt优化。清晰、结构化的prompt不仅能获得更好的结果,还能减少不必要的token消耗。使用明确的指令、提供必要的上下文、指定期望的输出格式,这些都能提高响应质量。

最后是缓存策略。对于相似的查询,可以实现本地缓存机制,避免重复调用API。特别是在开发环境中,合理的缓存能够大幅降低开发成本。

总结:如何做出最明智的选择

经过深入的对比分析,我们可以得出一个清晰的结论:Claude Opus 4和Claude Sonnet 4并非简单的高低配版本关系,而是针对不同使用场景优化的两个强大工具。选择哪个模型,关键在于理解你的实际需求和约束条件。

对于大多数开发场景,遵循"80/20法则"是明智的选择。日常的编码任务、文档生成、代码审查等工作使用Sonnet 4即可获得优秀的效果,同时享受更快的响应速度和更低的成本。而当面对真正复杂的挑战——比如设计关键系统架构、解决困难的算法问题、进行深度的技术研究时,Opus 4的投资就变得物有所值。

更重要的是,通过laozhang.ai这样的专业中转服务,国内用户不仅能够无障碍地使用这些先进的AI模型,还能享受到25%的成本优惠。对于想要尝试Claude 4系列的开发者,现在正是最好的时机。访问 https://api.laozhang.ai/register/?aff_code=JnIT 注册,即可开始你的AI辅助编程之旅。

记住,AI工具的价值最终取决于如何使用它。无论选择Opus 4还是Sonnet 4,关键是要将其融入你的开发工作流,让AI成为提升生产力的得力助手。在这个AI技术快速发展的时代,善用工具的人将在竞争中占据优势。选择适合自己的Claude 4模型,开始探索AI编程的无限可能吧。