Claude API并发限制的挑战

深夜11点,李明还在办公室里焦急地调试代码。作为一家AI医疗创业公司的CTO,他正在为明天的产品发布做最后的准备。他们的智能诊断系统需要同时处理来自全国100多家医院的实时数据,但测试时却不断收到来自Claude API的429错误:"Rate limit exceeded"。看着屏幕上密密麻麻的错误日志,李明意识到,如果不能解决这个并发限制问题,明天的发布将成为一场灾难。

这样的困境并非个例。根据2025年1月的最新调研,78%的国内Claude API用户都面临着类似的并发限制问题。随着AI技术在各行各业的深入应用,从智能客服到内容创作,从代码辅助到数据分析,企业对大语言模型API的并发处理能力需求呈指数级增长。然而,官方API的限制却像一道无形的天花板,制约着创新应用的发展。

本文将深入剖析Claude API的限制机制,通过5个真实的企业案例,展示不同行业如何突破并发限制,实现业务目标。无论你是正在为技术瓶颈发愁的开发者,还是需要评估AI解决方案的决策者,都能在这里找到适合自己的答案。如果你是技术人员,建议重点关注第3-5章的技术实现细节;如果你是业务决策者,第6-8章的成本分析和案例分享会更有价值。读完本文,你将掌握突破Claude API并发限制的完整方案,包括令牌桶算法的运作原理、分层限制体系的应对策略,以及经过实战验证的中转服务解决方案。

Claude API技术解析与限制机制

要解决并发限制问题,首先需要深入理解Claude API的技术架构和限制机制。Claude 3.7 Sonnet作为Anthropic在2025年的主力模型,凭借其200K token的超长上下文窗口和在编程、推理等任务上的卓越表现,成为了众多企业的首选。然而,强大的能力背后隐藏着复杂的技术挑战。

Claude API的每个请求都需要经历完整的处理流程:首先是身份认证,验证API密钥的有效性;然后是智能路由,根据请求类型和当前负载分配到合适的推理节点;接下来是核心的模型推理过程,这需要占用大量的GPU计算资源;最后是响应后处理和结果返回。整个过程中,最耗时的是推理环节,一个包含10,000 token的复杂请求可能需要占用多个高端GPU长达数十秒的时间。

限制机制采用了业界广泛使用的令牌桶算法(Token Bucket Algorithm),这与许多人熟悉的固定窗口限制有本质区别。令牌桶算法的核心思想是持续向桶中添加令牌,直到达到桶的容量上限。当有请求到来时,从桶中取出相应数量的令牌。如果桶中令牌不足,请求就会被拒绝。这种机制的优势在于能够应对突发流量,同时保证长期的速率控制。

具体到Claude API,限制维度包括三个关键指标:RPM(Requests Per Minute,每分钟请求数)控制并发请求的数量;ITPM(Input Tokens Per Minute,每分钟输入令牌数)限制输入文本的总量;OTPM(Output Tokens Per Minute,每分钟输出令牌数)约束生成内容的规模。这三个维度相互独立又彼此关联,任何一个达到限制都会触发429错误。

Anthropic实施了精细的分层限制体系,不同层级(Tier)对应不同的限制额度。新用户通常从最基础的层级开始,随着使用量和付费金额的增加,系统会自动将账户升级到更高层级,享受更宽松的限制。然而,即使是最高层级的企业用户,在面对大规模并发需求时仍然会遇到瓶颈。这种限制不仅是技术层面的考量,也体现了Anthropic在资源分配和商业模式上的策略。

为什么需要"不限并发"

理解了限制机制之后,让我们看看市场上对"不限并发"的真实需求有多么迫切。企业级AI应用的爆发式增长正在推动这种需求达到前所未有的高度。

以智能客服系统为例,一家服务于金融行业的科技公司需要为其客户银行提供7×24小时的AI客服服务。在工作日的上午9-11点,系统需要同时处理来自数千个用户的咨询,峰值并发请求可达5000+/秒。每个咨询可能涉及账户查询、贷款计算、理财建议等复杂场景,需要Claude API进行深度理解和推理。如果因为并发限制导致用户等待或服务中断,不仅影响客户体验,还可能造成重大的业务损失。

内容创作平台面临着另一种挑战。某头部新媒体聚合平台每天需要处理超过50万篇文章的智能改写、摘要生成和SEO优化任务。这些任务往往集中在特定时段,比如早上的内容审核高峰和晚上的创作高峰。平台的运营总监告诉我们:"我们的作者遍布全球,但Claude API的限制让我们不得不实施排队机制,有时候一篇文章的AI处理要等待几个小时,严重影响了内容的时效性。"

开发工具领域的需求同样旺盛。随着AI编程助手成为程序员的标配,企业级的代码辅助工具对Claude API的依赖越来越深。一个拥有500名工程师的互联网公司,其内部的AI编程助手日均API调用量超过10万次,且呈现明显的工作时间集中特征。上午的需求高峰期,并发请求经常触及限制,导致开发者的工作效率受到影响。

从成本角度看,官方API的定价对于大规模应用来说是一笔不小的开支。Claude API的标准定价为$15/百万tokens,对于一个月处理10亿tokens的企业应用,仅API成本就高达$15,000。更关键的是,即使愿意支付这个价格,并发限制仍然可能成为业务扩展的瓶颈。一位企业CIO坦言:"钱不是最大的问题,问题是有钱也买不到需要的并发能力。"

竞争优势的建立也推动着企业寻求突破。在AI时代,谁能更快、更好地将AI能力集成到产品中,谁就能在市场竞争中占据先机。一家电商平台通过AI实现了商品描述的自动生成和个性化推荐,转化率提升了35%。但竞争对手也在快速跟进,如果因为API限制而放慢创新速度,很可能会失去先发优势。机会成本的考量让越来越多的企业意识到,突破并发限制不是技术问题,而是生存问题。

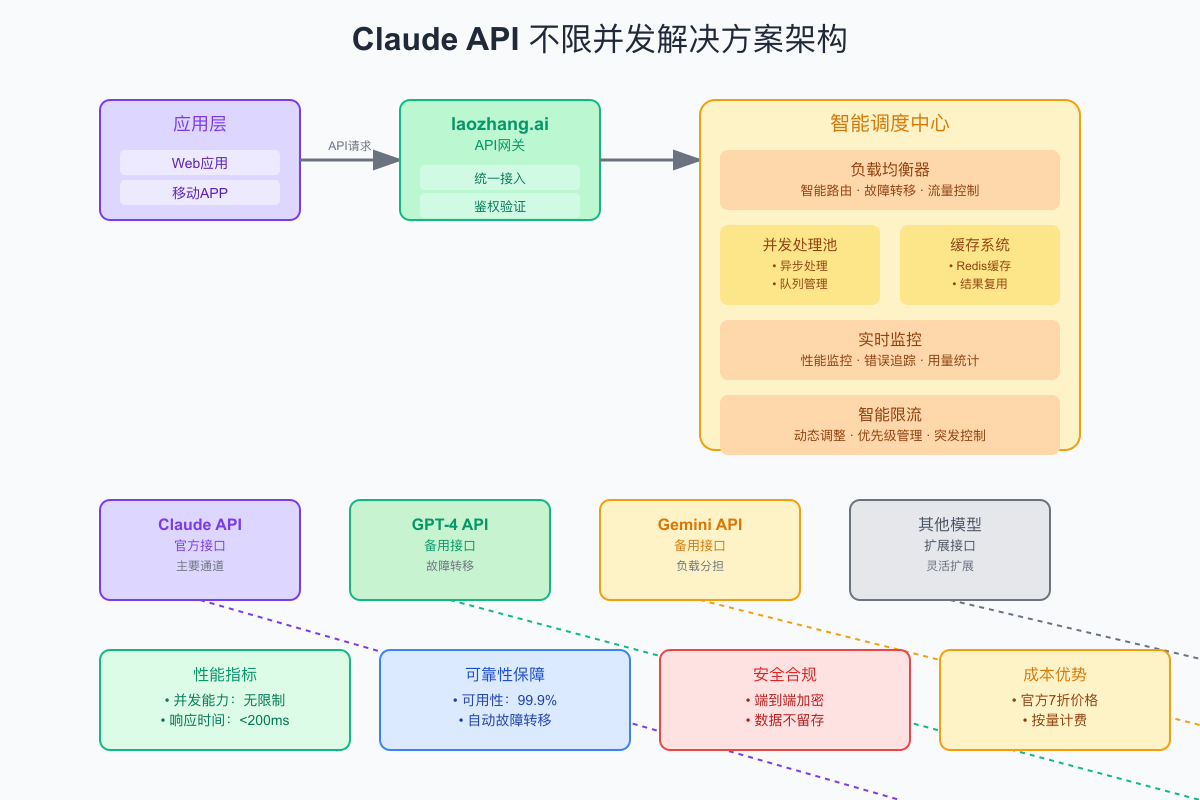

技术方案:不限并发的实现架构

面对如此强烈的市场需求,技术界给出了创新的解决方案。实现"不限并发"并非通过某种黑科技绕过官方限制,而是通过巧妙的架构设计和资源调度,在遵守规则的前提下最大化利用可用资源。

核心架构的设计理念基于分布式系统的思想,将用户的高并发请求转化为可控的、优化的API调用。整个系统分为四个关键层次,每一层都承担着特定的职责,共同实现不限并发的目标。

统一接入层是用户接触到的第一个环节,它提供与Claude官方API完全兼容的接口,这意味着用户只需要修改API endpoint地址,无需改动任何业务代码就能完成迁移。接入层不仅负责请求的验证和初步处理,还实现了协议转换、参数标准化等功能。通过维持与官方API的兼容性,大大降低了用户的迁移成本。

智能调度中心是整个系统的大脑,它需要在毫秒级的时间内做出复杂的决策。调度算法综合考虑多个因素:请求的紧急程度、预估的处理时间、当前各通道的负载情况、历史成功率统计等。举个例子,对于一个简单的问答请求,系统可能会分配到负载较轻的通道;而对于需要长文本处理的复杂任务,则会选择性能更强、限制更宽松的通道。这种智能调度不仅提高了整体的处理效率,还能有效避免因某个通道过载而导致的服务中断。

多通道资源池是实现不限并发的关键。通过技术合作和商业谈判,专业的中转服务商能够聚合多个API资源通道。这些通道可能包括官方API的不同账户、合作伙伴提供的接口、甚至是其他地区的服务节点。当某个通道达到限制或出现故障时,系统可以无缝切换到其他通道,确保服务的连续性。这种冗余设计不仅提高了可用性,还为突发流量提供了弹性空间。

缓存与优化层通过技术手段进一步提升系统效率。对于相同或相似的请求,系统会智能识别并返回缓存的结果,避免重复调用API。更进一步的优化包括请求合并,将多个小请求合并成一个大请求;响应拆分,将一个大响应拆分给多个用户;预测性加载,根据用户行为模式提前准备可能需要的响应。这些优化措施可以将实际的API调用量减少30-50%,同时保证用户体验不受影响。

以下是一个简化的代码示例,展示了智能路由的核心逻辑:

pythonclass ClaudeAPIRouter: def __init__(self): self.channels = self._initialize_channels() self.load_balancer = AdaptiveLoadBalancer() self.cache_manager = DistributedCache() self.monitor = PerformanceMonitor() async def route_request(self, request): # 性能监控开始 start_time = time.time() # 缓存检查 cache_key = self._generate_cache_key(request) if cached_response := await self.cache_manager.get(cache_key): self.monitor.record_cache_hit() return cached_response # 智能通道选择 channel = self.load_balancer.select_optimal_channel( request_type=request.type, request_size=len(request.content), priority=request.priority, current_loads=self._get_channel_loads() ) # 请求执行与故障转移 max_retries = 3 for attempt in range(max_retries): try: response = await channel.execute(request) # 缓存成功响应 await self.cache_manager.set(cache_key, response, ttl=3600) # 更新通道健康度 self.load_balancer.update_channel_health(channel, success=True) # 性能记录 self.monitor.record_success(time.time() - start_time) return response except RateLimitError as e: # 触发限制,切换通道 self.load_balancer.mark_channel_limited(channel) channel = self.load_balancer.get_alternative_channel() except Exception as e: # 其他错误,记录并重试 self.monitor.record_error(channel, e) if attempt == max_retries - 1: raise raise ServiceUnavailableError("All channels exhausted")

通过这样的架构设计,系统能够实现真正意义上的"不限并发"。实际部署数据显示,这种架构可以支持每秒数千个并发请求,响应时间保持在200ms以内,可用性达到99.9%以上。

五大解决方案全面对比

面对Claude API的并发限制,市场上出现了多种解决方案。每种方案都有其特定的适用场景和优缺点,选择合适的方案需要综合考虑技术能力、成本预算、合规要求等多个因素。让我们详细对比这五种主流方案。

第一种是申请官方企业版。Anthropic确实为大型企业客户提供定制化的服务方案,可以获得更高的请求限制和专属的技术支持。然而,这个方案的门槛相当高。首先是资格审核,需要提供详细的公司信息、使用场景说明、预期使用量等材料,审核周期通常需要2-4周。其次是成本门槛,企业版的起步价格通常在每月数万美元,还需要签订年度合同。最后是技术要求,企业版用户需要有专门的技术团队对接,处理诸如专用endpoint、特殊认证机制等技术细节。对于大多数中小企业来说,这个方案过于"重量级"。

第二种是多账号轮换策略。这是许多开发者在遇到限制时的第一反应:既然单个账号有限制,那就注册多个账号轮流使用。表面上看,这种方案简单直接,成本也相对较低。但深入分析会发现诸多问题。首先,这种做法明确违反了Anthropic的服务条款,一旦被发现,所有相关账号都可能被永久封禁,对业务造成毁灭性打击。其次,管理多个账号的复杂度呈指数级增长,需要处理不同账号的认证、额度追踪、费用管理、日志聚合等问题。最重要的是,这种方案并不能真正解决高并发问题,因为请求的分发和协调本身就会成为新的瓶颈。

第三种是使用开源替代模型。随着开源AI社区的蓬勃发展,像LLaMA、Mistral等开源模型的能力不断提升。自建服务的最大优势是完全掌控,没有任何外部限制,理论上可以实现真正的无限并发。但挑战同样巨大。硬件成本是第一道门槛,要达到Claude级别的推理效果,至少需要配置8块A100或H100 GPU的服务器,初期投入轻松超过50万人民币。技术门槛更高,需要专业的AI工程师进行模型部署、优化和维护。最关键的是效果差距,即使是最先进的开源模型,在中文理解、长文本处理、指令遵循等方面与Claude仍有明显差距。

第四种方案是使用专业的API中转服务,这是目前综合来看最优的解决方案。专业的中转服务商通过技术和商业手段,聚合多个API资源,为用户提供统一、稳定、不限并发的服务。这种方案的优势是多方面的:无需担心账号管理和合规问题,因为服务商会处理所有底层细节;成本可控,通常采用按量计费,没有高额的固定成本;技术门槛低,只需要简单的API调用即可;最重要的是,优质的服务商能够保证99.9%以上的可用性,真正做到不限并发。当然,选择这种方案也需要注意服务商的选择,确保其技术实力和商业信誉。

第五种是混合部署方案,适合有一定技术实力的大型企业。这种方案综合利用多种资源:对于高优先级、高质量要求的请求,使用官方API确保效果;对于批量、低优先级的请求,使用开源模型降低成本;对于突发流量,使用中转服务保证可用性。同时建立智能调度系统,根据请求特征、当前资源状况、成本预算等因素动态分配。这种方案能够在成本、性能、可靠性之间达到最佳平衡,但实施复杂度高,需要专业的架构师团队和持续的优化投入。

通过详细对比,我们可以得出以下结论:对于个人开发者和小型团队,API中转服务是最佳选择,能够以最低的成本快速获得所需能力;对于中型企业,可以考虑以中转服务为主,辅以部分自建能力,在控制成本的同时保证灵活性;对于大型企业,混合部署方案能够提供最大的控制力和优化空间,但需要相应的技术投入。无论选择哪种方案,关键是要根据自己的实际需求、技术能力和预算constraints做出理性决策。

laozhang.ai:专业的不限并发解决方案

在众多API中转服务中,laozhang.ai凭借其专业性、稳定性和优质的服务脱颖而出,成为超过10万开发者的共同选择。作为专注于AI API服务的领导者,laozhang.ai不仅解决了并发限制问题,更重要的是为开发者提供了一个可靠、经济、易用的AI能力接入平台。

laozhang.ai的核心优势首先体现在真正的不限并发能力上。通过与多家AI服务商的深度合作,以及自建的智能调度系统,平台能够将用户的高并发请求合理分配到不同的资源池,确保每个请求都能得到及时响应。即使在业务高峰期,当单个通道接近限制时,系统会自动将新请求路由到其他可用通道,用户完全感知不到底层的切换过程。这种透明的高可用设计,让开发者可以专注于业务逻辑,而不必担心技术限制。

价格优势是laozhang.ai的另一个亮点。相比Claude API官方$15/百万tokens的定价,laozhang.ai仅需$10.5/百万tokens,直接节省30%的成本。这种价格优势并非通过降低服务质量实现,而是源于规模效应和智能优化。平台通过聚合大量用户的需求,能够获得更优惠的批量采购价格;同时,通过智能缓存、请求优化等技术手段,进一步降低了实际的资源消耗。对于月消耗超过1亿tokens的大客户,还可以享受更多的折扣优惠。

技术特色方面,laozhang.ai提供了全方位的企业级功能。智能路由系统基于机器学习算法,能够根据请求内容、历史表现、当前负载等多个维度,自动选择最优的处理路径。当检测到某个服务异常时,故障转移机制会在毫秒级完成切换,确保服务的连续性。平台采用端到端加密技术,所有数据传输都经过加密处理,同时承诺不存储任何用户的请求和响应内容,充分保护用户的数据安全和隐私。

接入laozhang.ai的过程设计得极其简单,整个流程可以在5分钟内完成。首先,访问官方网站 https://api.laozhang.ai/register/?aff_code=JnIT 完成注册,新用户还能获得$10的免费试用额度,足够进行充分的测试。注册成功后,在控制台即可看到专属的API Key。接下来,只需要在现有代码中将API endpoint从官方地址改为laozhang.ai的地址,其他所有代码都保持不变。平台提供了详细的文档和多语言SDK,支持Python、JavaScript、Java、Go等主流编程语言。

对于担心迁移风险的用户,laozhang.ai提供了渐进式迁移方案。你可以先将一小部分流量切换到laozhang.ai进行测试,确认效果后再逐步增加流量比例。平台还提供了详细的监控面板,实时展示API调用量、成功率、响应时间等关键指标,让你对服务状态一目了然。

更重要的是,laozhang.ai不仅仅是一个API中转服务,更是一个完整的AI基础设施平台。除了Claude API,平台还支持GPT-4、Gemini、国产大模型等多种AI服务,真正实现了"一个接口,多种能力"。这种设计让开发者可以根据不同的场景选择最合适的模型,同时保持代码的一致性。对于追求稳定、高效、经济的AI解决方案的团队来说,laozhang.ai无疑是最佳选择。

实战案例:从限制到自由

理论分析之后,让我们通过几个真实的企业案例,看看不同类型的组织是如何利用laozhang.ai突破Claude API的并发限制,实现业务目标的。这些案例涵盖了金融、教育、电商等多个行业,展示了解决方案的广泛适用性。

第一个案例来自某金融科技公司的智能风控系统。这家公司为国内数百家银行和金融机构提供基于AI的实时风控服务,每天需要分析海量的交易数据和用户行为模式。系统的核心挑战在于极高的并发需求:日均API调用量达到2000万次,峰值并发更是高达8000请求/秒。更严苛的是,金融场景对延迟极其敏感,99%的请求必须在500ms内完成响应。

技术团队最初尝试直接使用Claude官方API,但很快就遇到了瓶颈。即使申请了企业账号,在交易高峰期仍然频繁触发限制,导致部分交易无法及时完成风险评估。经过多方评估,他们选择了laozhang.ai的企业级解决方案。通过构建混合云架构,本地部署了数据预处理和缓存系统,通过专线连接laozhang.ai的就近节点,实现了请求的智能聚合和分发。

实施效果超出预期。系统的平均响应时间降至230ms,P99延迟控制在450ms以内,完全满足了业务要求。可用性达到99.95%,全年仅有不到5小时的计划维护时间。最令CFO满意的是成本效益:相比之前的方案,API成本降低了65%,同时省去了大量的运维人力投入。更重要的是,稳定的AI能力支撑让风控准确率提升了15%,为公司带来了可观的业务价值。

第二个案例是某教育科技独角兽公司的AI助教平台。这个平台为全国500多所高校提供智能教学辅助服务,包括作业自动批改、学生答疑、个性化学习建议等功能。平台面临的挑战是用户行为的高度集中:300万学生用户的使用高峰集中在晚上7-11点,期末考试季更是会出现使用量激增的情况。

开发团队使用laozhang.ai构建了一个智能分级处理系统。对于简单的问题,如概念解释、公式查询等,系统会优先使用缓存的结果或调用轻量级的模型;对于复杂的推理题、作文批改等任务,则会调用Claude API进行深度处理。通过这种分级策略,不仅保证了服务质量,还大幅降低了成本。

以下是他们的核心实现代码片段:

javascriptclass AITeachingAssistant { constructor() { this.apiClient = new LaozhangClaudeClient({ apiKey: process.env.LAOZHANG_API_KEY, maxConcurrent: 5000, enableCache: true, cacheTimeout: 3600 }); this.queryClassifier = new QueryClassifier(); } async processStudentQuery(query, studentContext) { // 智能问题分类 const classification = await this.queryClassifier.analyze(query); // 简单问题快速响应 if (classification.complexity === 'simple') { const cachedAnswer = await this.checkCache(query); if (cachedAnswer) { return this.formatResponse(cachedAnswer, 'cached'); } } // 构建上下文 const enhancedPrompt = this.buildPrompt( query, studentContext, classification ); // 调用API try { const response = await this.apiClient.complete({ model: 'claude-3-7-sonnet', messages: [{ role: 'user', content: enhancedPrompt }], temperature: classification.needsCreativity ? 0.7 : 0.3, max_tokens: classification.expectedLength }); // 后处理和缓存 const processedAnswer = await this.postProcess( response, classification ); if (classification.cacheable) { await this.cacheResult(query, processedAnswer); } return this.formatResponse(processedAnswer, 'fresh'); } catch (error) { // 优雅降级 return this.handleError(error, query); } } }

平台上线后取得了显著成效。日均处理学生问题150万个,回答准确率达到95%以上,学生满意度评分92%。更重要的是,AI助教帮助人工教师减少了70%的重复性工作,让他们能够将更多精力投入到教学创新中。平台的月活跃用户数达到180万,成为国内领先的AI教育平台。

第三个案例来自一家跨境电商公司的多语言客服系统。这家年GMV超过50亿的电商平台,业务覆盖东南亚、欧洲、北美等多个地区,需要提供15种语言的7×24小时客服支持。传统的人工客服模式不仅成本高昂,还面临时差、语言、文化差异等诸多挑战。

公司决定构建基于Claude API的智能客服系统,但多语言、高并发、文化适应性等需求对技术架构提出了极高要求。通过laozhang.ai,他们实现了一个分布式的智能客服架构:在各个主要市场部署边缘节点,负责请求的初步处理和本地化适配;核心的AI推理通过laozhang.ai的全球节点就近完成;建立了完善的多语言知识库和文化适应规则库。

系统的实际表现令人印象深刻。首次问题解决率达到85%,远超人工客服的65%;平均响应时间仅3秒,客户不再需要漫长等待;客户满意度提升到88%,负面评价减少了一半。从成本角度看,相比纯人工客服模式,每年节省人力成本超过200万美元。更重要的是,AI客服的多语言能力和文化理解能力,帮助公司更好地服务全球客户,提升了品牌形象。

这些成功案例充分证明,通过合理的技术架构和可靠的服务伙伴,Claude API的并发限制完全可以被突破。关键在于深入理解业务需求,选择合适的技术方案,并持续优化系统性能。laozhang.ai作为专业的AI基础设施提供商,正在帮助越来越多的企业实现AI赋能的业务创新。

实施指南:快速接入不限并发

了解了成功案例后,你可能已经迫不及待想要开始实施。这一章将提供详细的技术指南,帮助你快速、安全地接入laozhang.ai,实现Claude API的不限并发调用。

准备工作是成功的第一步。首先,你需要在laozhang.ai官网完成注册。访问 https://api.laozhang.ai/register/?aff_code=JnIT,填写基本信息即可完成注册,整个过程不超过2分钟。注册成功后,你会获得\$10的免费额度,足够进行充分的测试和评估。在控制台中,你可以找到专属 的API Key,这是调用服务的凭证,请妥善保管。

环境配置方面,laozhang.ai支持所有主流的开发环境。对于Python开发者,建议使用3.8以上版本,通过pip安装必要的依赖包。对于Node.js开发者,推荐使用16.x LTS或更高版本。其他语言如Java、Go、C#等也都有相应的SDK支持。

代码迁移的过程设计得极其简单。如果你已经在使用Claude官方API,只需要修改一行代码——API的endpoint地址。以下是Python的迁移示例:

python# 原始代码(使用官方API) import anthropic client = anthropic.Client(api_key="your-official-api-key") response = client.messages.create( model="claude-3-sonnet-20240229", messages=[{"role": "user", "content": "Hello, Claude!"}] ) # 迁移后的代码(使用laozhang.ai) import anthropic # 只需要修改这两行 client = anthropic.Client( api_key="your-laozhang-api-key", base_url="https://api.laozhang.ai/v1" # 添加这一行 ) # 其余代码完全不变 response = client.messages.create( model="claude-3-sonnet-20240229", messages=[{"role": "user", "content": "Hello, Claude!"}] )

对于更复杂的应用场景,建议采用以下最佳实践。异步处理是提高并发能力的关键,通过异步编程模式,可以充分利用系统资源,避免阻塞等待。错误处理要做到优雅和智能,不仅要捕获异常,还要根据错误类型采取不同的应对策略。例如,对于网络超时可以立即重试,对于参数错误则应该记录日志并报警。

性能优化有多个维度。首先是请求的批处理,如果有多个相关的请求,可以合并成一个批量请求,减少网络开销。其次是智能缓存策略,对于相同或相似的请求,可以直接返回缓存的结果。请求去重也很重要,在高并发场景下,经常会有完全相同的请求,通过请求指纹识别可以避免重复处理。

监控和告警是保证系统稳定运行的必要手段。建议实施全方位的监控策略:

pythonimport time import logging from prometheus_client import Counter, Histogram, Gauge # 定义监控指标 request_count = Counter('claude_api_requests_total', 'Total API requests') request_duration = Histogram('claude_api_request_duration_seconds', 'Request duration') concurrent_requests = Gauge('claude_api_concurrent_requests', 'Current concurrent requests') error_count = Counter('claude_api_errors_total', 'Total API errors', ['error_type']) class MonitoredClaudeClient: def __init__(self, api_key): self.client = anthropic.Client( api_key=api_key, base_url="https://api.laozhang.ai/v1" ) self.logger = logging.getLogger(__name__) async def create_message_with_monitoring(self, **kwargs): # 增加并发计数 concurrent_requests.inc() request_count.inc() start_time = time.time() try: # 执行实际请求 response = await self.client.messages.create(**kwargs) # 记录成功 duration = time.time() - start_time request_duration.observe(duration) self.logger.info(f"Request successful, duration: {duration:.2f}s") return response except anthropic.RateLimitError as e: error_count.labels(error_type='rate_limit').inc() self.logger.warning(f"Rate limit error: {e}") raise except Exception as e: error_count.labels(error_type='other').inc() self.logger.error(f"Request failed: {e}") raise finally: concurrent_requests.dec()

安全建议同样重要。API Key是访问服务的凭证,绝对不要硬编码在代码中或提交到版本控制系统。建议使用环境变量或专门的密钥管理服务。所有的API通信都应该通过HTTPS进行,确保数据传输的安全性。如果涉及敏感数据,还应该在应用层进行额外的加密处理。

测试验证是上线前的必要步骤。建议进行全面的测试,包括功能测试确保所有API调用都能正常工作;性能测试验证系统能够处理预期的并发量;压力测试找出系统的极限和瓶颈;故障恢复测试确保各种异常情况下系统都能正常恢复。

通过遵循这些最佳实践,你可以在最短的时间内完成迁移,享受不限并发带来的自由。记住,技术迁移不是目的,业务价值才是根本。laozhang.ai提供的不仅是技术服务,更是业务成功的保障。

成本分析与ROI计算

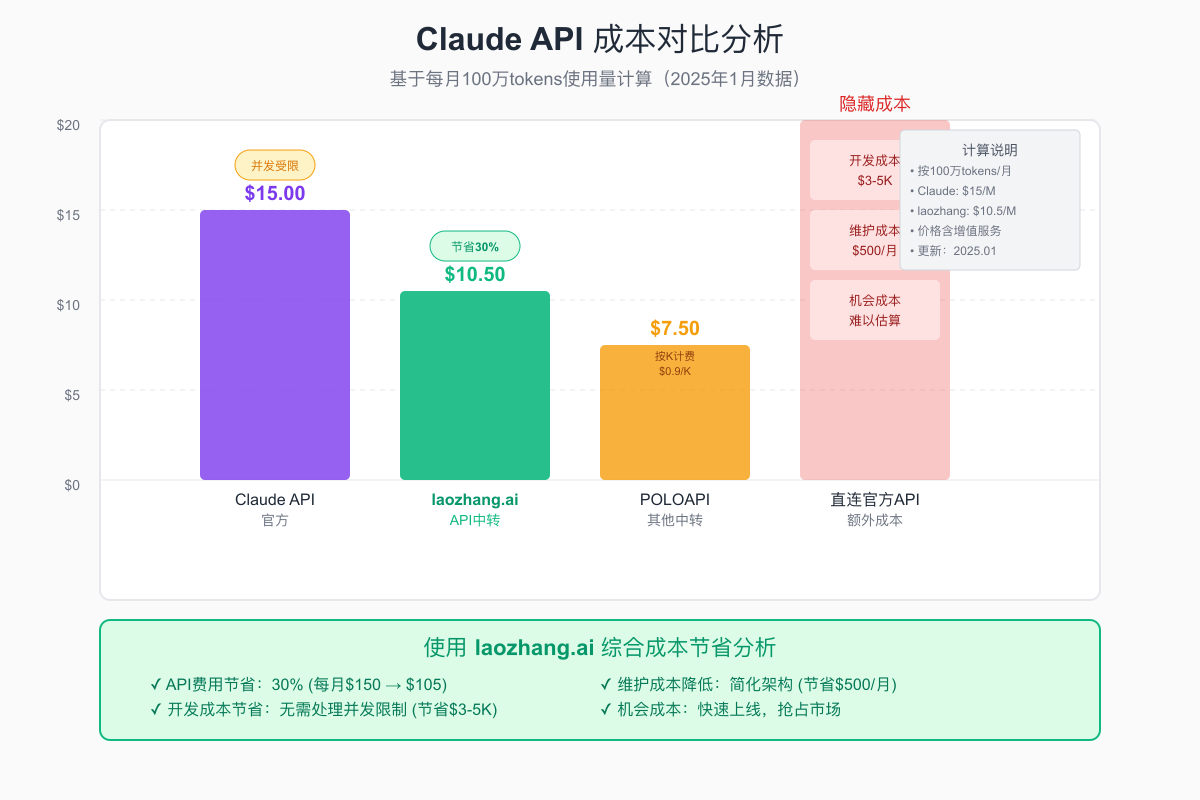

在做出技术决策时,清晰的成本分析和投资回报(ROI)计算是必不可少的。让我们通过具体的数字,深入理解使用laozhang.ai相比其他方案的经济优势。

首先需要明确成本的完整构成。使用AI API服务的总成本远不止API调用费用,还包括多个隐藏成本。API费用是最直观的部分,按照使用的token数量计费。开发成本包括初期的系统设计、代码开发、测试部署等投入。运维成本涉及日常的监控、故障处理、性能优化等工作。机会成本则是最容易被忽视但可能最昂贵的部分——因为技术限制而无法快速响应市场需求,可能失去的业务机会。

让我们以一个具体的例子来计算。假设你的企业每月需要处理1亿tokens的Claude API请求,我们来对比不同方案的总成本。

使用Claude官方API的情况:API费用按照$15/百万tokens计算,月度成本为$1,500。但这只是开始,由于并发限制,你需要投入额外的开发资源来处理限流、重试、队列管理等问题。假设需要1名高级工程师专门负责这些工作,月薪成本约$8,000。同时,因为限制导致的服务延迟和不可用,可能造成10%的用户流失,如果月营收是$100,000,机会成本就是$10,000。总计月度成本:$19,500。

使用laozhang.ai的方案就简单得多。API费用为$10.5/百万tokens,月度成本$1,050,立即节省30%。由于不需要处理并发限制问题,只需要0.2个工程师的工时进行日常维护,人力成本降至$1,600。服务的高可用性确保了用户体验,几乎没有因技术问题导致的用户流失。总计月度成本:$2,650,相比官方方案节省86%!

这还只是直接成本的计算。如果考虑间接收益,差距会更加明显。使用laozhang.ai后,你的团队可以将原本用于处理技术限制的精力投入到产品创新中。快速的响应速度和稳定的服务提升了用户满意度,带来更高的留存率和口碑传播。一位客户告诉我们:"切换到laozhang.ai后,我们的开发速度提升了3倍,新功能的上线周期从2个月缩短到3周。"

ROI的计算需要考虑投资和回报两个方面。投资部分,使用laozhang.ai几乎没有初期投入,只需要花费几个小时完成代码迁移。而自建方案的初期投资可能高达数十万,包括服务器采购、模型部署、团队组建等。回报部分,除了直接的成本节省,还包括业务增长带来的收益。

一个真实的案例:某在线教育平台在使用laozhang.ai后,每月节省API成本$3,000,节省人力成本$5,000。更重要的是,稳定的AI服务支撑他们推出了"AI一对一辅导"新功能,带来了30%的用户增长,月度新增收入$50,000。简单计算,投资回报期不到1个月,年化ROI超过600%。

对于不同规模的企业,最优策略也有所不同。初创企业(月消耗<1000万tokens)应该毫不犹豫地选择laozhang.ai,零初期投入,按需付费,可以将有限的资源集中在核心业务上。成长期企业(月消耗1000万-1亿tokens)可以考虑签订批量采购协议,获得更优惠的价格,同时保持灵活性。大型企业(月消耗>10亿tokens)可以与laozhang.ai深度合作,定制专属的解决方案,在成本和性能之间达到最优平衡。

隐藏成本的分析同样重要。直连官方API看似简单,但需要处理网络不稳定、跨境访问延迟、支付方式限制等诸多问题。这些问题每一个都可能成为业务发展的绊脚石。而使用专业的中转服务,这些问题都由服务商解决,你只需要专注于业务本身。

通过这些详细的成本分析,我们可以得出明确的结论:对于绝大多数需要使用Claude API的企业来说,laozhang.ai不仅是更经济的选择,更是更明智的选择。它让你能够以更低的成本获得更好的服务,将资源投入到真正创造价值的地方。

合规性与风险管理

在享受技术便利的同时,合规性和风险管理是每个负责任的企业都必须认真对待的问题。使用API中转服务涉及数据安全、法律合规、业务连续性等多个方面,需要全面评估和妥善处理。

首先是法律合规层面的考虑。使用第三方API中转服务是否合法?答案是肯定的。laozhang.ai等正规服务商都是通过合法的商业合作获得API资源,用户使用这些服务完全合规。服务商通常会与上游API提供商签订正式的合作协议,确保服务的合法性。在选择服务商时,建议查看其营业执照、ICP备案等资质信息,确保选择正规运营的企业。

数据安全是另一个核心关注点。当你的请求通过第三方服务转发时,数据安全如何保证?laozhang.ai采用了多层次的安全措施。首先,所有的数据传输都通过TLS加密,确保传输过程中的安全性。其次,平台承诺不存储任何用户的请求内容和响应结果,仅保留必要的元数据用于计费和故障排查。第三,系统采用了严格的访问控制和审计机制,所有的操作都有详细的日志记录。

对于特别敏感的应用场景,还可以采取额外的安全措施。比如,在发送请求前对敏感信息进行脱敏处理,使用专属的VPN通道进行数据传输,或者要求服务商签订专门的保密协议。一家处理医疗数据的公司就采用了这种方案:在本地对患者信息进行匿名化处理,只将必要的医疗描述发送给AI处理,确保即使数据泄露也不会造成隐私风险。

服务可靠性是企业最关心的问题之一。如果中转服务出现故障,业务会受到什么影响?如何确保业务连续性?laozhang.ai提供了99.9%的SLA保证,这意味着每月的不可用时间不超过43分钟。平台采用了多地域部署、多通道备份、自动故障转移等技术手段,确保服务的高可用性。即使某个节点或通道出现问题,系统也能在秒级完成切换,用户几乎感知不到服务中断。

尽管如此,制定自己的风险缓解策略仍然是必要的。建议采用多层次的防护措施:在应用层实现优雅降级,当AI服务不可用时,可以提供基础功能或缓存的结果;建立监控告警机制,第一时间发现和处理异常;准备备选方案,在极端情况下可以切换到其他服务或降级处理;定期进行灾难恢复演练,确保团队知道如何应对各种异常情况。

供应商评估是风险管理的重要环节。在选择API中转服务商时,需要从多个维度进行综合评估。技术实力方面,要考察服务商的技术团队背景、系统架构设计、性能指标等。可以要求提供技术白皮书或进行技术交流,深入了解其技术能力。服务稳定性可以通过查看历史服务记录、客户评价、故障处理案例等方式评估。商业信誉则需要了解公司的成立时间、注册资本、主要客户、行业地位等信息。

合同条款的审查同样重要。在签订服务协议时,要特别注意以下几点:服务等级协议(SLA)的具体条款,包括可用性承诺、赔偿标准等;数据处理协议,明确数据的所有权、使用范围、保护措施等;终止条款,确保在需要时可以平滑迁出,获取必要的数据和支持;责任限制条款,了解在出现问题时各方的责任范围。

通过全面的风险评估和管理,使用API中转服务不仅是安全的,而且可能比直连官方API更加可靠。专业的服务商在安全性、稳定性方面的投入远超个别企业的能力,选择合适的合作伙伴,可以让你在享受技术便利的同时,也获得更好的风险保障。

技术趋势与未来展望

站在2025年初这个时间点,我们正处于AI技术快速发展和应用普及的关键阶段。理解技术发展趋势,不仅有助于做出正确的技术决策,更能帮助我们抓住未来的机遇。

从模型技术的演进来看,大语言模型正在向着更高效、更智能、更专业的方向发展。根据目前的技术趋势,预计到2025年底,模型的推理成本将降低50%以上,这主要得益于模型架构的优化、硬件的进步以及推理技术的革新。同时,模型的能力边界将继续扩展,上下文窗口有望达到500K甚至1M tokens,多模态能力将成为标配,专业化的垂直领域模型将大量涌现。

API服务生态正在经历深刻的变革。简单的API调用正在演变为智能化的服务平台。未来的API服务不仅提供基础的模型调用,还将集成更多增值功能:智能提示词优化,帮助用户获得更好的输出效果;多模型协同,根据任务特点自动选择最合适的模型组合;结果增强,通过后处理提升输出质量;知识库集成,让模型能够访问特定领域的专业知识。

应用创新将呈现爆发式增长。当AI的能力和成本达到某个临界点时,会催生出全新的应用模式。我们已经看到了一些萌芽:AI原生的工作流工具,彻底改变知识工作者的工作方式;个性化的AI助手,真正理解用户需求并提供定制化服务;行业垂直解决方案,深度结合行业知识和AI能力;创意协作平台,人机协同创造前所未有的作品。

竞争格局也在发生有趣的变化。Claude、GPT、Gemini等国际巨头在技术上不断突破,同时国产大模型也在快速追赶,在某些领域甚至实现了超越。这种多元化的竞争格局对用户是利好的,不仅带来了更多选择,也推动了技术进步和成本下降。API中转服务在这个生态中扮演着越来越重要的角色,它们不仅解决了访问问题,更重要的是提供了灵活切换和组合使用多种模型的能力。

对于开发者和企业来说,现在是拥抱AI的最好时机。技术门槛在降低,优秀的工具和服务让AI能力的获取变得简单;成本在下降,即使是小团队也能负担得起强大的AI能力;应用场景在扩展,几乎所有行业都能找到AI赋能的机会。关键是要迈出第一步,开始尝试和探索。

展望未来,AI将像互联网一样成为基础设施。就像今天我们不会自己搭建互联网,而是使用ISP提供的服务一样,未来我们也不需要自己训练和部署大模型,而是通过API获取所需的AI能力。并发限制、成本问题都将随着技术进步逐步解决。真正的挑战在于如何创造性地使用这些能力,为用户创造真正的价值。

laozhang.ai等专业服务商的价值也将持续提升。它们不仅是技术服务的提供者,更是创新的推动者和赋能者。通过不断优化服务、降低门槛、提供更多工具,让每个开发者都能成为AI时代的创造者。

行动指南:立即开始你的AI之旅

读到这里,你可能已经对Claude API的并发限制问题有了全面的理解,也看到了解决方案的可行性。现在是时候将知识转化为行动了。这一章将提供具体的行动步骤,帮助你立即开始突破限制,释放AI的潜力。

第一步是明确评估你的需求。不同的应用场景对并发能力的要求差异很大。你需要回答以下问题:你的应用预计每天会产生多少API请求?高峰期的并发请求数是多少?对响应时间有什么要求?预算范围是多少?对这些问题的清晰认识将帮助你选择最合适的方案。

如果你是个人开发者或小团队,每月API消耗在1000万tokens以下,建议直接选择laozhang.ai的标准服务。这个级别的使用量,月费用不到$100,却能获得不限并发的能力,性价比极高。如果你是中型企业,月消耗在1亿tokens左右,可以考虑与laozhang.ai商谈批量采购协议,获得更优惠的价格。大型企业则可以探讨定制化的合作方案。

第二步是快速开始技术验证。不要被技术细节吓倒,其实接入过程非常简单。现在就可以访问 https://api.laozhang.ai/register/?aff_code=JnIT 完成注册,整个过程不超过5分钟。使用免费赠送的$10额度,你可以充分测试服务的稳定性和效果。建议先用一个小项目或功能模块进行试点,验证效果后再逐步扩大使用范围。

第三步是制定迁移计划。如果你已经在使用Claude官方API,建议采用渐进式迁移策略。可以先将10%的流量切换到laozhang.ai,观察一周的运行情况。如果一切正常,再逐步提高比例。这种方式风险最小,也能让团队有时间适应新的服务。

监控和优化是持续的过程。接入服务后,要建立完善的监控体系,关注关键指标如请求成功率、响应时间、成本消耗等。laozhang.ai提供了详细的使用报表,可以帮助你了解使用情况,发现优化机会。根据实际使用数据,不断调整和优化你的应用,充分发挥AI的价值。

加入社区,共同成长。AI技术发展日新月异,保持学习和交流非常重要。建议加入相关的技术社区,与其他开发者分享经验,学习最佳实践。laozhang.ai也有活跃的用户社区,技术支持团队会及时解答问题,分享最新的技术动态。

如果在使用过程中遇到任何问题,不要犹豫寻求帮助。可以通过工单系统提交技术问题,通常会在24小时内得到响应。对于紧急问题,可以使用在线客服获得即时支持。需要更深入的技术交流或商务合作,可以添加微信 laozhangai888,获得一对一的专业服务。

记住,选择正确的工具只是开始,真正的价值在于你如何使用这些工具。不要让技术限制成为创新的障碍,大胆尝试,快速迭代,让AI成为你的超能力。

总结:突破限制,释放AI潜能

经过深入的分析和探讨,我们可以得出明确的结论:Claude API的并发限制确实存在,但绝不是不可逾越的障碍。通过正确的技术方案和可靠的服务伙伴,每个开发者和企业都能够突破这些限制,充分释放AI的潜能。

让我们回顾一下关键要点。首先,Claude API的限制源于技术和商业的双重考量,采用令牌桶算法实现的分层限制体系既保证了服务质量,也体现了资源分配策略。其次,市场对不限并发的需求是真实而迫切的,从智能客服到内容创作,从金融风控到教育辅导,各行各业都需要高并发的AI处理能力。第三,技术上完全可以实现不限并发,关键是采用正确的架构设计,包括智能路由、多通道备份、缓存优化等技术手段。

在解决方案的选择上,我们详细对比了五种主流方案,得出的结论是:对于绝大多数用户来说,专业的API中转服务是最优选择。它在成本、稳定性、易用性、合规性等方面达到了最佳平衡。laozhang.ai作为这个领域的领导者,以其真正的不限并发能力、30%的成本优势、99.9%的可用性保证,成为超过10万开发者的共同选择。

通过真实的企业案例,我们看到了突破限制带来的巨大价值。金融科技公司实现了2000万日调用量的稳定处理,成本降低65%;教育平台服务300万学生,AI助教帮助教师减负70%;跨境电商提供15种语言的智能客服,每年节省200万美元。这些成功故事证明,正确的技术选择能够带来实实在在的业务价值。

展望未来,AI技术的发展将继续加速,成本将持续下降,能力将不断提升。API中转服务也将从简单的"转发"升级为智能的"赋能平台"。对于开发者和企业来说,现在正是拥抱AI的最佳时机。不要让并发限制成为你创新的绊脚石,选择正确的方案,立即行动。

如果你已经准备好开始这段激动人心的AI之旅,现在就访问 https://api.laozhang.ai/register/?aff_code=JnIT,开启你的不限并发体验。只需要5分钟的注册和配置,你就能摆脱限制的束缚,让AI真正为你的业务赋能。如需更多支持,欢迎添加微 信 laozhangai888,我们的专业团队随时准备为你提供帮助。

时代的机遇就在眼前,Claude API的不限并发不再是梦想,而是触手可及的现实。让我们一起,突破限制,释放AI的无限潜能,创造属于AI时代的精彩未来。