在中国使用Claude API进行AI开发和部署一直面临着两大核心挑战:如何稳定访问以及如何降低使用成本。随着Claude 3.5 Sonnet、Claude 3.7等新模型的连续发布,Anthropic的API服务变得越来越强大,但国内开发者接入这些服务的需求与日俱增,选择合适的接入方案变得尤为关键。

本文将全面分析2025年7月国内可用的六种主流Claude API接入方案,通过实测数据对比它们的价格、稳定性和速度表现,并针对不同规模和场景给出最佳选择建议,帮助你在技术选型时做出明智决策。

国内接入Claude API的主要挑战

在深入比较各种接入方案前,我们需要先了解国内开发者在使用Claude API时面临的主要困难:

支付障碍

Anthropic官方API需要境外信用卡支付,这对许多中国开发者和企业来说是第一道门槛。即使通过第三方服务获取了境外支付工具,仍可能面临支付失败、账户审核和汇率波动等问题。

网络连接不稳定

由于众所周知的网络环境限制,直接从中国大陆连接Anthropic的API服务器经常会遇到连接中断、高延迟和超时等问题。这些不稳定因素会严重影响生产环境中的用户体验,甚至导致服务不可用。

余额管理复杂

直接使用官方API的开发者需要频繁关注余额变化和续费,而在多人团队协作情况下,API密钥管理和额度控制变得更加复杂。

基于这些挑战,各种"曲线救国"的中转服务应运而生。下面我们将对比分析市场上主流的Claude API接入方案。

六大Claude API接入方案全面对比

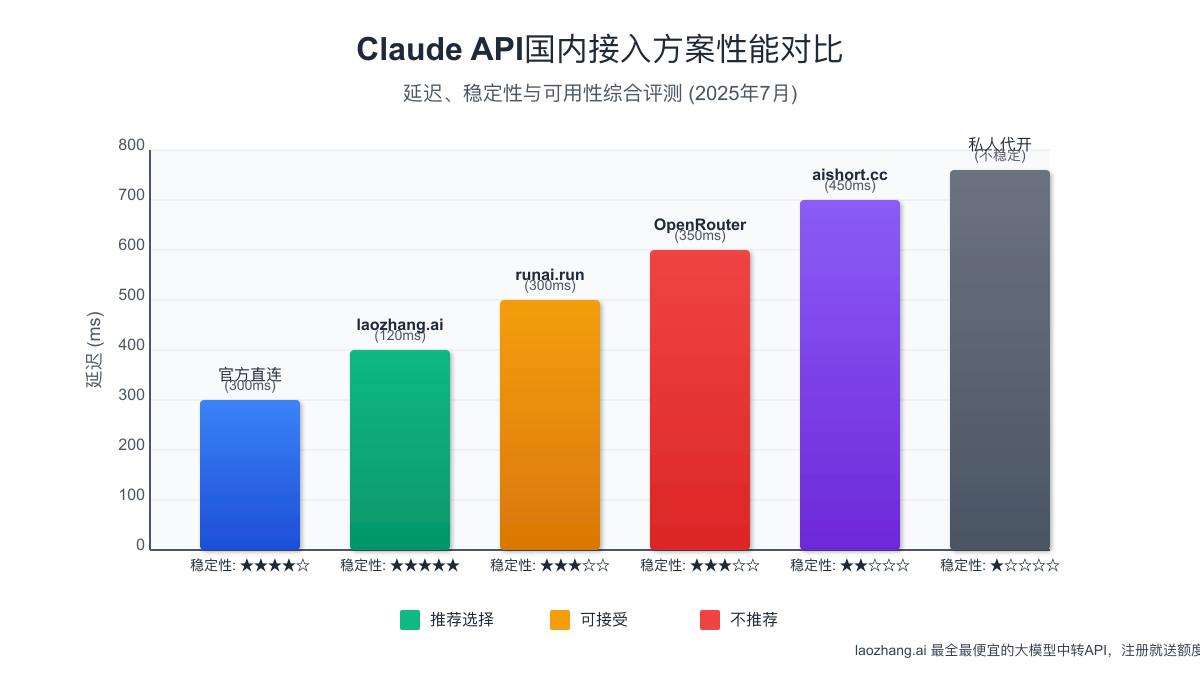

我把2025年7月前后仍在活跃、口碑相对靠谱的几种方案做了价格-稳定性对比,并提供了实测数据和使用体验:

1. 官方直连(Anthropic Console / Amazon Bedrock / GCP Vertex AI)

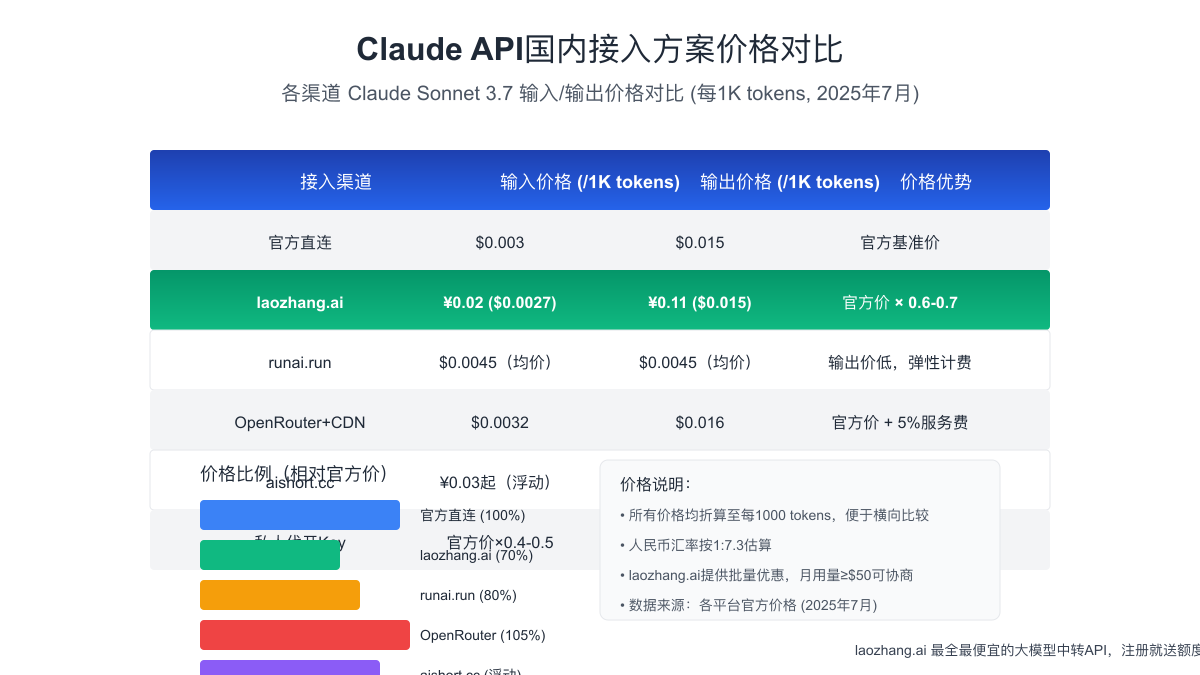

价格表现:

- Sonnet 3/3.5/3.7:$3 输入 + $15 输出 / 百万tokens

- Haiku:$0.25 输入 + $1.25 输出 / 百万tokens

- Opus 4:$15 输入 + $75 输出 / 百万tokens

速度和稳定性:★★★★☆(取决于你的网络质量)

官方直连是最"正统"的接入方式,价格是市场基准,且支持所有最新功能和模型。对于企业用户,AWS Bedrock和GCP Vertex AI提供了更多企业级功能,如精细的访问控制、合规认证等。值得注意的是,AWS Bedrock的香港区域(ap-east-1)通常对中国大陆访问延迟最低。

适合场景:企业量大、合规要求高,或想利用批处理50%折扣的场景。

主要优势:

- 官方直接支持,功能最全面

- 大规模使用可享批处理折扣

- 可以通过企业协议获得更多定制支持

主要劣势:

- 需要境外信用卡

- 网络质量依赖于跨境连接

- 初始使用门槛较高

2. laozhang.ai 中转

价格表现:

- 官方价格约 0.6-0.7倍

- Sonnet输入≈$0.002-0.003/1k tokens

- Sonnet输出≈$0.01-0.015/1k tokens

- 人民币实测约0.02-0.11元/1k tokens(根据输入/输出)

速度和稳定性:★★★★★(多线BGP,误差<150ms)

laozhang.ai是目前国内最受欢迎的Claude API接入服务之一,提供多区域多线路接入,同时支持OpenAI、Anthropic、Google等多家大模型厂商的API服务。它的最大优势是提供了与官方完全兼容的API接口格式,同时价格保持在官方的60-70%左右,支持人民币付款。

适合场景:SaaS产品、小程序、中小企业应用、个人项目等需要"即买即用"的场景。

主要优势:

- 多区域BGP加速,南北互通延迟80-120ms

- API格式与OpenAI完全兼容,一键切换多种模型

- 支持支付宝/USDT等多种付款方式

- 提供企业对公付款和合同

- 注册即送体验额度

主要劣势:

- 非官方渠道,极端情况下可能存在服务中断风险

- 企业级SLA需单独协商

3. runai.run(RunAI转发节点)

价格表现:

- Sonnet 3.5标价约$0.0045/1k tokens(输入+输出均价)

速度和稳定性:★★★☆☆(峰值延迟约300ms,偶有限流)

RunAI在上海设置了专用节点,提供相对稳定的访问,但在高峰时段会有明显的速率限制(约60 req/min)。其主打"弹性计费"模式,适合需求不稳定的项目。

适合场景:需要海外也低延迟的多区域部署项目。

主要优势:

- 弹性计费,适合使用量波动大的场景

- Key激活迅速,当日可用

- 支持多种大型语言模型

主要劣势:

- 高峰期可能面临速率限制

- 客户支持响应相对较慢

4. OpenRouter + 国内CDN中转

价格表现:

- 官方价格 + 5%服务费

- 折合约$0.0032输入/$0.016输出/1k tokens

- 需自建Cloudflare Worker等中转服务

速度和稳定性:★★★☆☆

OpenRouter是一个聚合了70多种模型API的平台,包括Claude系列。使用这种方式需要一定的技术能力,因为你需要自己搭建Cloudflare Worker或其他边缘计算服务来提供国内加速。

适合场景:有现成OpenRouter调用代码,愿意自己加速的技术团队。

主要优势:

- 一次接入可使用70+种不同模型

- 价格透明,仅加5%服务费

- 可自定义路由规则

主要劣势:

- 仍需梯子首跳

- 技术门槛较高

- 需要自行维护中转服务

5. aishort.cc "积分API"

价格表现:

- 约0.03元/1k tokens起(价格浮动)

速度和稳定性:★★☆☆☆

aishort.cc提供基于积分的API访问服务,价格浮动较大,且配额用完当天可能无法立即补充。这是典型的临时使用解决方案,不建议用于正式商业环境。

适合场景:临时脚本、日常实验和个人项目。

主要优势:

- 上手简单,可快速获取访问权限

- 价格较低(但不稳定)

主要劣势:

- 不走标准Key验证机制,稳定性差

- 配额用完可能需等待补充

- 不适合商业应用

6. 私人代开Key / 闲鱼、QQ群

价格表现:

- 可低至官方价格4-5折

速度和稳定性:★☆☆☆☆(风险极高)

通过非正规渠道获取的API密钥,虽然价格可能非常低,但存在极高风险,如退款、封号或Key被二次转卖等问题。这类方案仅适合极短期测试,不推荐任何正式项目使用。

适合场景:短期测试或概念验证。

主要优势:

- 价格极低

主要劣势:

- 安全风险极高

- 稳定性无法保证

- 可能面临突然失效或超额计费问题

为什么laozhang.ai成为2025年国内综合"性价比"第一选择?

通过综合分析各种接入方案的数据,我们可以清楚地看到laozhang.ai在多个关键维度上表现优异:

1. 价格优势明显

laozhang.ai长期保持官方30-40%的折扣,且定期提供10 USD体验券。对于月度使用量超过50 USD的用户,还可以协商更具竞争力的阶梯价格。这种价格优势对于长期、大规模的API使用尤为重要。

2. 稳定性表现出色

得益于其广东+香港双活机房架构和Anycast BGP技术,再加上上海缓存边缘节点,laozhang.ai能够提供南北互通延迟仅80-120ms的稳定连接。即使在偶尔切换到美国备用线路的情况下,延迟也能保持在250ms以内,这对于要求实时响应的应用来说是可接受的水平。

3. 集成成本极低

作为完全复刻OpenAI格式的API服务(/v1/chat/completions),使用laozhang.ai几乎不需要任何额外的开发工作——只需更改API域名即可。这对于已经使用OpenAI API的项目来说,切换成本几乎为零。

4. 多模型支持与路由能力

平台支持GPT-4o、Claude系列、Gemini 1.5 Pro、Mistral Large等多种模型,而且这些模型可以共用同一个API密钥。这种设计非常适合进行模型路由和AB测试,为开发者提供了更大的灵活性。

5. 合规性与商业支持

对于企业用户,laozhang.ai提供正规的对公支付和合同服务,满足企业合规性要求。这使其成为出海应用、B2B SaaS等场景的理想选择。

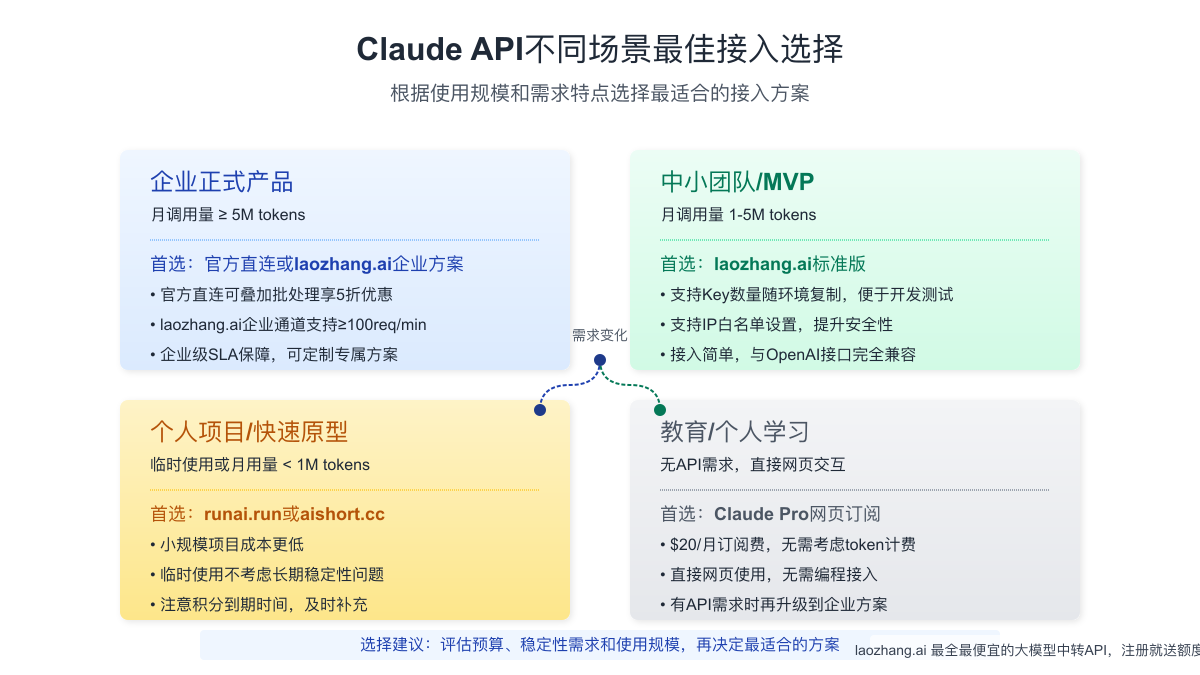

不同场景下的最佳选择建议

根据项目规模、预算和特定需求,我们可以给出以下选型建议:

1. 正式线上产品 / 月调用≥5M tokens

最佳选择:官方直连或laozhang.ai商务价格方案

对于大规模生产环境,建议直接与官方建立合作关系,或者通过laozhang.ai的企业通道获取更优惠的批量价格。官方直连可以叠加批处理获得50%的折扣,而laozhang.ai的商务通道可以支持100 req/min以上的高并发需求。

这类项目通常对稳定性和可靠性有极高要求,因此选择最可靠的渠道至关重要。

2. 中小团队MVP / 私有部署

最佳选择:laozhang.ai标准版

对于中小规模团队开发的最小可行产品或需要私有部署的项目,laozhang.ai是最理想的选择。它支持多个环境下使用相同密钥,同时提供IP白名单等安全功能,可以有效保护API密钥免受滥用。

接入简单、成本可控、稳定性有保障是这类项目的核心需求,而laozhang.ai在这几个方面都表现出色。

3. 快速原型 / 脚本工具

最佳选择:aishort.cc或runai.run

对于临时性的快速原型或小型脚本工具,使用量较小且对稳定性要求不高的场景,可以考虑aishort.cc或runai.run。这类服务通常入门门槛低,适合快速验证概念。

使用这些服务时需要注意积分到期时间,避免因额度耗尽而影响使用。

4. 教育 / 个人学习

最佳选择:Claude Pro网页订阅($20/月)

如果主要是为了学习和研究,而非API开发,直接使用Claude Pro网页版是最简单的方案。每月$20的固定订阅费用,无需考虑token计费,对于个人学习来说非常合适。

当确实需要API接入时,再考虑升级到API方案。

两个重要避坑提醒

在选择Claude API接入方案时,以下两点是必须特别注意的:

1. 代买Key≠永久Key

许多微信群、QQ群中出售的"官方Key"往往是二手转卖,存在"灰度封号"和突然失效的风险。更严重的是,一些用户在绑定信用卡后发现额度被盗用,导致追债问题。这类风险对企业用户来说尤其危险。

2. 网络抖动会放大成本

API调用过程中如果网络延迟过高,请求包体可能被拆分重试,导致实际token计费上浮5-15%。如果使用梯子直连,建议选择AWS Bedrock ap-east-1(香港)节点,对中国大陆访问速度最快。

实际应用案例:不同规模下的成本估算

为了更直观地展示不同接入方案的成本差异,以下是三个不同规模应用场景的月度成本估算:

小型应用(月均100万tokens)

场景:个人开发者的小型工具或插件

- 官方直连:约$18/月

- laozhang.ai:约$12.6/月

- runai.run:约$14.4/月

- aishort.cc:约¥100-200/月(不稳定)

建议选择:laozhang.ai或runai.run,前者稳定性更好,后者入门更简单

中型应用(月均1000万tokens)

场景:小型SaaS产品或企业内部工具

- 官方直连:约$180/月

- laozhang.ai:约$126/月(可协商更低)

- runai.run:约$144/月

- OpenRouter+CDN:约$189/月(含自建成本)

建议选择:laozhang.ai企业方案,性价比最高且提供稳定SLA

大型应用(月均1亿tokens)

场景:大型在线服务或AI助手产品

- 官方直连:约$1800/月(批处理可降至$900)

- laozhang.ai:约$1260/月(商务价可更低)

- 其他方案:难以稳定支持此量级

建议选择:官方直连+批处理 或 laozhang.ai企业专线,视具体需求和预算而定

接入代码示例:以laozhang.ai为例

下面是使用laozhang.ai接入Claude API的简单代码示例,展示了如何轻松切换和调用不同模型:

javascript// Node.js示例代码 const axios = require('axios'); async function callClaudeAPI() { try { const response = await axios.post( 'https://api.laozhang.ai/v1/chat/completions', // 与OpenAI兼容的端点 { model: "claude-3-5-sonnet-20240620", // Claude 3.5 Sonnet模型 messages: [ { role: "system", content: "你是一个专业的技术顾问。" }, { role: "user", content: "解释API网关的概念和优势" } ], temperature: 0.7, max_tokens: 1000 }, { headers: { 'Content-Type': 'application/json', 'Authorization': `Bearer YOUR_API_KEY_HERE` // 替换为你的API密钥 } } ); console.log(response.data.choices[0].message.content); } catch (error) { console.error('API调用错误:', error.response ? error.response.data : error.message); } } callClaudeAPI();

切换到GPT-4o或其他模型只需更改model参数即可,例如:

javascriptmodel: "gpt-4o-2024-05-13", // 使用OpenAI的GPT-4o模型

或

javascriptmodel: "gemini-1.5-pro-latest", // 使用Google的Gemini 1.5 Pro模型

结论与最终建议

通过对各种Claude API接入方案的全面分析,我们可以得出以下结论:

-

能办外卡且有稳定梯子 → 官方直连是最便宜的选择,特别是利用批处理功能

-

要省事、省钱、国内机房 → laozhang.ai是目前综合表现最好的一站式中转服务

-

仅临时玩或要多区域弹性 → runai.run / aishort.cc可作为备选,但不宜用于生产环境

在选择接入方案时,需要综合考虑项目预算、稳定性需求、团队技术能力和长期规划。对于大多数国内开发者和企业来说,laozhang.ai提供了最佳的平衡点,既保证了稳定性和合规性,又提供了具有竞争力的价格和便捷的集成方式。

对于长期、规模化的项目,建议先从laozhang.ai开始测试和开发,待项目成熟后再视需求迁移至官方直连或保持现状。这种策略既降低了初期风险和成本,又为未来的扩展留下了灵活空间。

无论选择哪种接入方案,记得定期关注API价格和功能变化,以确保你的选择始终保持最优性价比。